Como desarrollador, me ha pasado más de una vez: el modelo cumple su tarea, pero de una forma tan literal que acaba generando resultados absurdos o dañinos. Esa experiencia te enseña por las malas la importancia de la alineación de modelos de IA.

El International AI Safety Report 2025 identifica la falta de alineación como uno de los riesgos más graves en sistemas avanzados. Si no logramos alinear correctamente los modelos con nuestras intenciones humanas, podríamos perder el control de su comportamiento a medida que se vuelven más potentes y autónomos.

¿Qué es la alineación de modelos de IA?

Se refiere al proceso de garantizar que un sistema de inteligencia artificial comprenda, represente y actúe de acuerdo con los valores, objetivos y limitaciones humanas esperadas.

Un modelo alineado:

- Optimiza lo que el usuario realmente desea, no solo lo que dice.

- Evita consecuencias colaterales negativas.

- Reconoce límites éticos y legales.

- Se comporta de forma predecible incluso en contextos nuevos.

5 claves para lograr la alineación de modelos de IA

1. Definir objetivos con precisión contextual

No basta con dar una instrucción clara. Hay que entender qué consecuencias puede tener esa instrucción en distintos escenarios. Un modelo que “maximiza el engagement” sin contexto puede promover desinformación o contenido dañino. La clave es incorporar valores y restricciones directamente en el objetivo.

2. Entrenar con retroalimentación humana (RLHF)

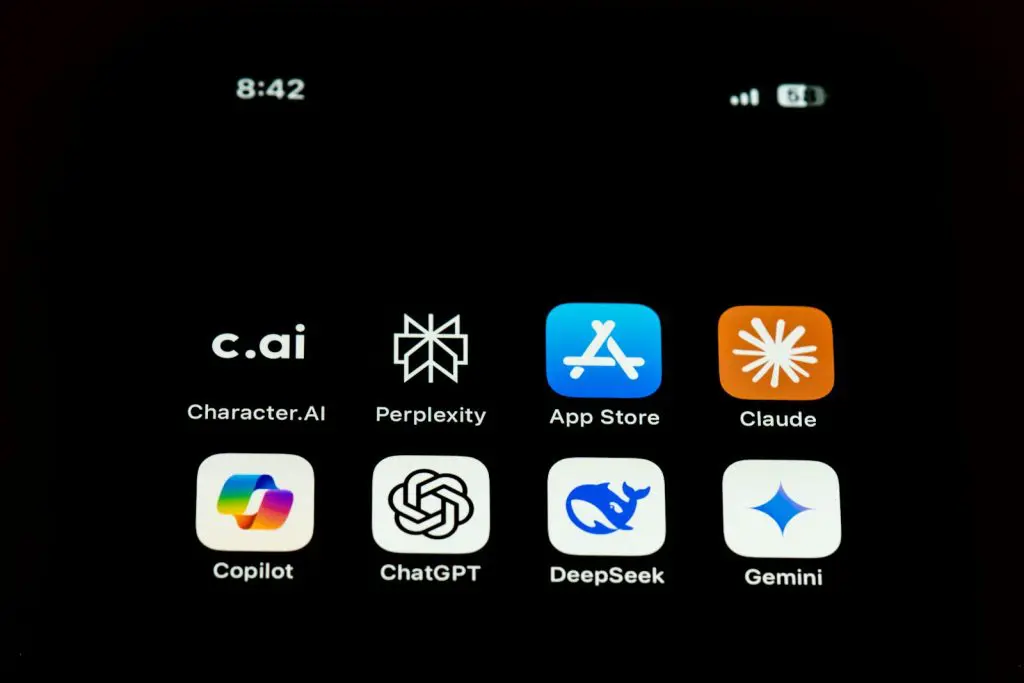

El Reinforcement Learning from Human Feedback permite ajustar el comportamiento de un modelo en función de cómo las personas evalúan sus respuestas. Es un método ampliamente usado en modelos como ChatGPT y Claude para enseñar alineación ética y social.

🔴 ¿Quieres formarte en Inteligencia Artificial a un nivel avanzado? 🔴

Descubre nuestro Inteligencia Artificial Full Stack Bootcamp. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en Inteligencia Artificial por una semana3. Usar evaluaciones adversariales

Una forma de detectar desalineación es “atacar” al modelo con prompts diseñados para inducir respuestas problemáticas. Si el modelo cae en la trampa, no está suficientemente alineado. Estas pruebas ayudan a identificar debilidades antes del despliegue.

4. Aplicar interpretabilidad y trazabilidad

Para alinear un sistema, necesitas comprender cómo toma decisiones. Las técnicas de interpretabilidad como saliency maps, análisis de atención o distilación permiten inspeccionar internamente los modelos y evaluar si su razonamiento es coherente con los valores humanos.

5. Incorporar mecanismos de abstención y control

Un modelo bien alineado no solo debe “responder bien”, sino también saber cuándo no responder. La abstención es una señal de prudencia: si el modelo detecta ambigüedad o posible daño, puede negarse a actuar. Este comportamiento controlado es clave para sistemas desplegados en entornos sensibles.

¿Cómo afecta la alineación al desarrollo real de productos?

Para quienes construimos productos con IA, una buena alineación:

- Reduce errores en producción.

- Mejora la experiencia del usuario.

- Aumenta la confianza y aceptación del sistema.

- Evita sanciones regulatorias.

- Facilita escalar hacia modelos más autónomos con seguridad.

La alineación no es un lujo ético, es una necesidad funcional y estratégica. Y cuanto antes la integres en tu ciclo de desarrollo, más robusto será tu producto final.

FAQs sobre alineación de modelos de IA

¿Qué puede pasar si un modelo no está alineado?

Puede comportarse de forma inesperada, causar daños no intencionados, amplificar sesgos o ser manipulable por actores maliciosos.

¿La alineación es lo mismo que la seguridad de la IA?

Están relacionadas, pero no son lo mismo. La alineación es un componente clave de la seguridad, enfocada en la intención y los valores.

¿Puede un modelo alinearse completamente?

Todavía no. La alineación perfecta es un ideal. Actualmente se trabaja con aproximaciones, evaluaciones continuas y mejoras iterativas.

¿Es posible alinear modelos sin feedback humano?

No del todo. Los humanos seguimos siendo la fuente principal para definir valores, prioridades y consecuencias no deseadas.

Conclusión

La alineación de modelos de IA es una de las fronteras más difíciles pero más necesarias del desarrollo actual. A medida que delegamos más decisiones en sistemas automatizados, debemos garantizar que lo que entienden como «correcto» se parezca mucho a lo que realmente queremos.

Diseña IA alineada con el mundo real y con tus principios

En el Bootcamp de Inteligencia Artificial de KeepCoding, aprenderás a crear modelos alineados desde la teoría hasta la implementación. Porque programar el futuro también implica diseñar intenciones. KeepAligning, KeepCoding.