Apache Kafka forma parte de la gran variedad de sistemas creados para el manejo adecuado del Big Data. Recuerda que el Big Data hace referencia a un gran volumen de datos; de hecho, anualmente se presenta un aumento del 12% en los datos generados. Por ello, este campo exige la multiplicidad de herramientas con las que cuenta.

De hecho, este estudio de los macrodatos desde herramientas opensource como Apache Kafka aumentan la posibilidad de llevar a cabo un procesamiento de los macrodatos muy preciso, en el que se destaque el valor de la información. Por esta razón, en este post, te exponemos qué es Apache Kafka y cómo funciona dentro del mundo Big Data.

¿Qué es Apache Kafka?

Apache Kafka es una herramienta de streaming opensource escrita en JAVA y Scala. En otra palabras, podrás considerar a Kafka como otro tópico de arquitectura Big Data que son los Pub/Sub, los cuales trabajan como un mensaje de streams.

De esta forma, Apache Kafka es una herramienta para lidiar o para tratar con los streams de datos. De manera que el flujo de los datos es continuo y, además, se distribuye en paquetes pequeños de información.

El funcionamiento de este flujo de datos consiste en que se envía en stream un fichero grande como un gran volumen de bits y su principal tarea se basa en llevar y orientar los datos sin importar el tiempo que pueda tardar.

Es decir, Apache Kafka te ayuda a controlar una gran cantidad de datos producidos en tiempo real, por ello se le conoce como un stream de datos. De esta manera, cualquier cantidad de datos que se está produciendo ahora mismo podrás procesarla por medio de Apache Kafka; por ejemplo, los tuits que se están generando justo ahora a medida que se van publicando. Ten en cuenta que debe ser una relación inmediata, no contar con los tuits de hace tres días.

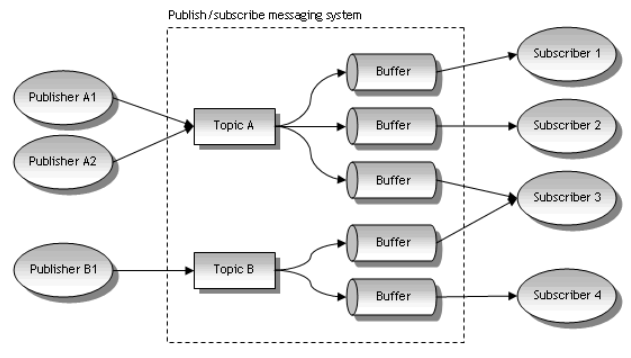

En definitiva, Kafka ayuda a generar un buffer con los datos a procesar. Es decir, crea una clase de sujetadores con unos envases en los que va capturando los mensajes para que tú puedas ir procesando los macrodatos. Para ello, este sistema de transmisión de datos cuenta con ciertos componentes que te compartimos a continuación:

Pub/Sub

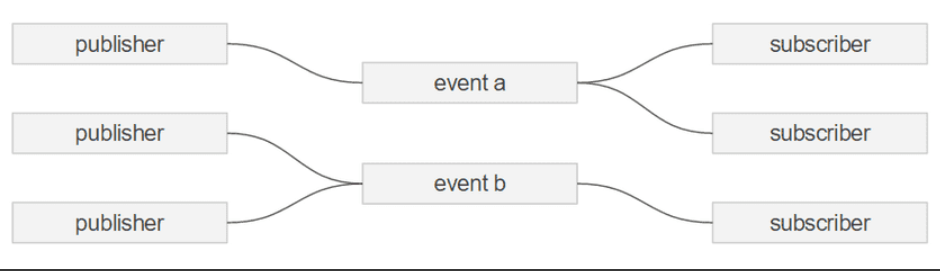

Este se presenta cuando estés tratando con streams, sin embargo, lo más importante es entender el concepto de Pub/Sub. Es muy sencillo, ya que se basa en que en una arquitectura de streaming tiene siempre uno o más PUBlishers y uno o más SUBscribers.

Eventos/Mensajes

Ahora, podrás pensar que cada objeto que se publica es un objeto o un mensaje, así lo reconoce Apache Kafka. A pesar de que, en otras palabras, este factor es simplemente información o datos estructurados que se insertan en el sistema a través de topics.

Topics

En cuanto a este componente, los mensajes de un stream pueden organizarse en topics, y a su vez, los SUBscribers pueden subscribirse a uno o mas topics para procesarlos, como se muestra en la siguiente ilustración:

Primeros pasos para Apache Kafka

Antes de empezar, debes conocer Zookeeper (necesario para levantar Kafka). Este es un servicio distribuido que sirve para almacenar configuraciones distribuidas y gestiones multiservicio. Internamente funciona como un árbol de directorio, cada elemento de la estructura es conocido como Znode, los cuales pueden almacenar información en su interior, por ejemplo, un JSON String.

Ya sabes qué es Apache Kafka, pero ¿cómo funciona? En la estructura de Apache Kafka hay dos partes importantes, llamadas productores y consumidores. Dependiendo de la configuración de cada proyecto, Kafka puede funcionar bajo dos tipos de sistemas de mensajes.

El primero es un Modelo de Cola, en el cual el productor distribuye los mensajes de manera equitativa a todos los consumidores, y la otra manera es llamada publicador/suscriptor en el que los consumidores se suscriben a un topic y, de esta manera, un mismo mensaje puede llegar a varios consumidores.

De las estructuras propias de kafka, el servicio principal de esta herramienta es Kafka Broker, donde se crean las colas de mensajes o también llamadas topics. Los topics se pueden dividir en particiones para que, de esta forma, se puedan fraccionar en diferentes clústeres y, así, facilitar su procesamiento. Dentro de las particiones se almacenan los mensajes que tienen un identificador único llamado offset.

Otra parte importante dentro de Kafka son las réplicas, que funcionan para garantizar la continuidad de los servicios, ya que si algún broker llega a fallar, tendrá un respaldo y un procedimiento que Kafka puede utilizar para seguir funcionando. Las réplicas se asignan a cada topic y el número máximo de estas debe ser igual o menor a la cantidad de brokers asignados.

La parte más importante o estructuras propias de kafka son los mensajes, los cuales están compuestos por cuatro partes: header, timestamp, clave y un valor. La clave se suele utilizar para decidir a qué partición va cada mensaje.

¿Cómo crear un topic?

Lo más importante en las líneas de código de este proceso es incluir el número de particiones, el número de réplicas y, de manera opcional, las configuraciones del topic. El código debe verse así:

kafka-topics.sh --zookeper localhost:2181 --create --topic topicTest --partitions 4 --replication-factor 2 -config x=y¿Cómo conseguir Kafka?

Ahora que sabes qué es Apache Kafka, te interesará saber que, al ser una herramienta open source, su descarga es muy fácil y, para conseguirlo, puedes ir a esta página. ¿Necesitas un Curso de Apache Kafka? Ahora que ya lo tienes instalado en tu ordenador, aquí te dejamos un ejercicio práctico de un curso Kafka gratis para que entiendas su funcionamiento y lo empieces a usar. ¡No te pierdas el Kafka tutorial!

En Big Data, podrás encontrar miles de retos y beneficios que solo esta industria te puede ofrecer. Convertirte en un Kafka Engineer, u otro perfil Big Data es posible en tan solo ocho meses y mucho esfuerzo de tu parte. Podrás aprender Kafka, programación ¡y mucho más! Descubre el Bootcamp Big Data y conoce cómo lograrás esta meta con nosotros.