Conocer los detalles sobre la arquitectura VGG16 y VGG19 en Deep Learning es de suma importancia, puesto que esta es una de las arquitecturas más utilizadas para el manejo de los macrodatos en el aprendizaje profundo de redes neuronales convolucionales.

Por esta razón, un buen data scientist debe contar con esta estrategia por si quiere un análisis más profundo sobre las redes que aborda en el procesamiento del Big Data. Así, en este post, te exponemos qué es y cómo funciona la arquitectura VGG16 y VGG19 en Deep Learning.

Arquitectura VGG16 y VGG19 en Deep Learning

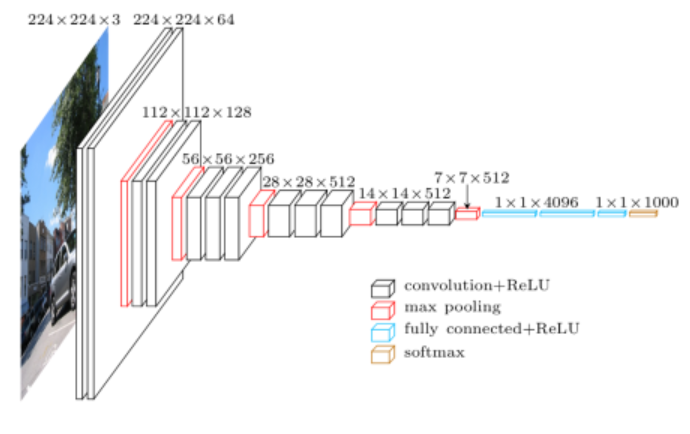

La arquitectura VGG16 y VGG19 en Deep Learning fue una de las primeras en aparecer. Fue introducida por Simonyan y Zisserman en 2014 con su artículo titulado Very Deep Convolutional Networks for Large Scale Image Recognition (vgg19 network). A continuación, te presentamos cómo se vería internamente este tipo de arquitectura en el aprendizaje profundo:

La arquitectura VGG16 y VGG19 en Deep Learning se trata de una arquitectura bastante simple, usando solo bloques compuestos por un número progresivo de capas convolucionales con filtros de tamaño 3×3. Además, para reducir el tamaño de los mapas de activación que se van obteniendo, se intercalan bloques maxpooling entre los convolucionales, reduciendo a la mitad el tamaño de estos mapas de activación. Finalmente, se utiliza un bloque de clasificación compuesto por dos capas densas de 4096 neuronas cada una, y una última capa, que es la de salida, de 1000 neuronas.

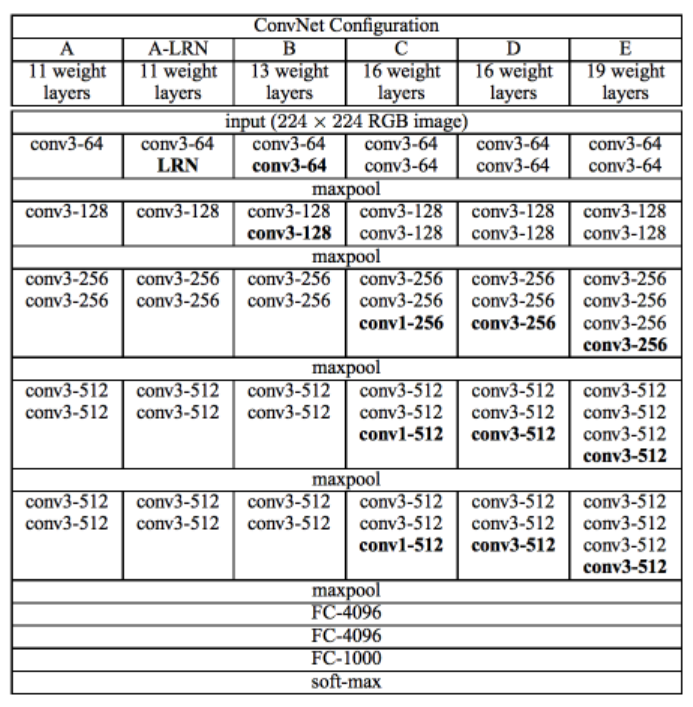

El 16 y 19 de vggnet 19 y el modelo vgg16 se refiere al número de capas con pesos que tiene cada red (las convolucionales y las densas, las de pooling no se cuentan). Se corresponden con las columnas D y E de la tabla que verás a continuación; esta expone este tipo de arquitectura vgg19 vs vgg16 en Deep Learning:

El motivo por el que ves el resto de arquitecturas en la tabla es porque, por aquel entonces, a Simonyan y Zisserman les costó bastante entrenar su arquitectura de forma que convergiera. Como no lo conseguían, lo que se les ocurrió fue entrenar primero redes con arquitecturas más sencillas, y una vez estas convergían y estaban entrenadas, aprovechaban sus pesos para inicializar la siguiente red, que era un poco más compleja. así hasta llegar a la VGG19.

Fíjate en la importancia que tiene la inicialización de los pesos, como ya hemos visto. A este proceso se le conoce como pretraining.

Sin embargo, este arreglo de la arquitectura vgg16 y vgg19 en Deep Learning fue en aquellos tiempos, ahora ya no se hace esto, ya que requiere demasiado tiempo. En la actualidad podemos conseguir lo mismo utilizando la inicialización de Xavier/Glorot o de He.

Esta red, sin embargo, tiene un par de desventajas:

- En primer lugar, tarda muchísimo tiempo en entrenar.

- Por otra parte, tiene un número muy elevado de parámetros por consolidar.

Ahora que en el proceso de este post te has podido familiarizar con la arquitectura VGG16 y VGG19 en Deep Learning, ya podrás contar con este saber tan fundamental para el análisis de redes neuronales convolucionales en el procesamiento del Big Data. Sin embargo, te aconsejamos continuar aprendiendo sobre las demás arquitecturas y, así, como data scientist, podrás escoger la mejor de ellas para tu procesamiento de datos.

Desde KeepCodging, te traemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning, gracias al que podrás aprender mucho más sobre los sistemas y herramientas más importantes en el universo del Big Data. De la mano de profesionales y en menos de nueve meses, te convertirás en todo un experto y serás capaz de conocer e identificar las alternativas de gestión de datos más apropiadas para los estudios de los macrodatos. ¿A qué estás esperando para empezar? ¡No dudes en solicitar más información e inscríbete ahora!