El proceso de cómo entrar al clúster de Dataproc con Shell se ha instaurado como una ventaja para el desarrollo de un estudio de macrodatos efectivo. Es por ello que, desde KeepCoding, te traemos en este artículo cómo funciona este proceso de entrar al clúster de Dataproc con Shell.

¿Qué es Dataproc para el Big Data?

En primer lugar, antes de conocer cómo entrar al clúster de Dataproc con Shell, resulta importante saber qué es DataProc, puesto que el proceso deriva de este servicio.

DataProc forma parte del múltiple conjunto de servicios que ofrece GCP (Google Cloud Plataform). Este servicio de Google cuenta con dinámicas y estrategias que agilizan el procesamiento adecuado de los macrodatos por medio de los clústeres en las distintas plataformas y programas con los que trabaja.

De hecho, una de sus dinámicas consta del proceso de ETL (extracción, transformación y carga) de los macrodatos. Ahora, podrás ver un poco del mismo con el proceso que te expondremos a continuación de cómo entrar al clúster de Dataproc con Shell.

¿Cómo entrar al clúster de Dataproc con Shell?

El primer paso para entrar en el clúster de Dataproc con Shell consiste en crear una carpeta para Apache Flume. Después, deberás descargarlo directamente desde internet de la siguiente forma:

- sudo mkdir /usr/lib/flume

- sudo chmod -R 777 /usr/lib/flume

- cd /usr/lib/flume

- wget http://apache.rediris.es/flume/1.9.0/apache-flume-1.9.0-bin.tar.gz

- ls

- tar -xzf apache-flume-1.9.0-bin.tar.gz

Posteriormente, debes insertar esto en el archivo .bashrc del home para modificar las variables del entorno para Apache Flume:

- export FLUME_HOME=”/usr/lib/flume/apache-flume-1.9.0-bin”

- export FLUME_CONF_DIR=”$FLUME_HOME/conf”

- export FLUME_CLASSPATH=”$FLUME_CONF_DIR”

- export PATH=”$FLUME_HOME/bin:$PATH”

A continuación, debes refrescar .bashrc y proceder a entrar en la carpeta de configuración de Flume así:

- source ~/.bashrc

- cd $FLUME_CONF_DIR

- cp flume-env.sh.template flume-env.sh

- cp flume-conf.properties.template flume-conf.properties

- rm /$FLUME_HOME/lib/guava-11.0.2.jar

Dentro del archivo de environment de flume (flume-env.sh), debes configurar las variables de entorno:

- export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-amd64

- Give Flume more memory and pre-allocate, enable remote monitoring via JMX

- export JAVA_OPTS=”-Xms100m -Xmx2000m -Dcom.sun.management.jmxremote”

- cd $FLUME_CONF_DIR

- sed -i ‘$a \export JAVA_HOME=/usr/lib/jvm/java-1.8.0-openjdk-amd64\nexport JAVA_OPTS=”-Xms100m -Xmx2000m -Dcom.sun.management.jmxremote”‘ flume-env.sh

Ahora tienes que confirmar que los cambios de configuración han ido bien y si este comando no falla: flume-ng -help. Además, para que funcione la conexión, debes buscar la IP privada de la máquina de Apache Kafka y ejecutar lo siguiente:

- export KAFKA_IP=”10.172.0.12″

- echo $KAFKA_IP

Tras haber configurado correctamente Flume, podrás crear un CONSUMER para Apache Kafka definiendo un archivo de configuración nuevo de esa manera: kafka.conf.

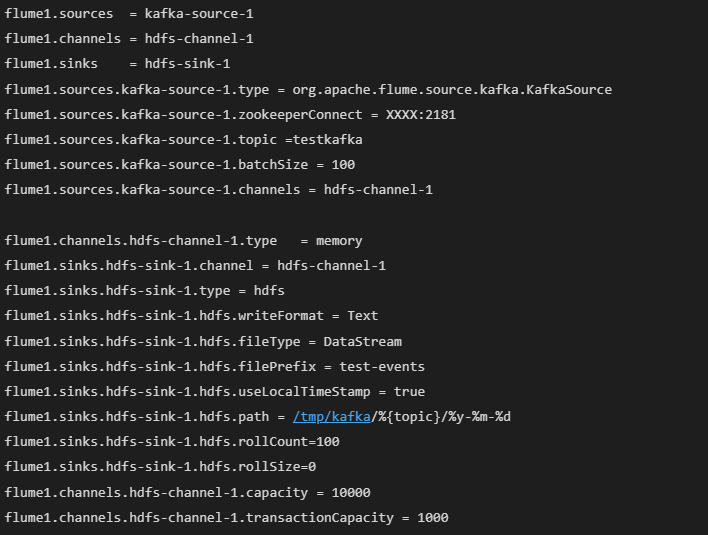

Por último, debes tener algo así en la definición del sink/conector para Hadoop-kafka:

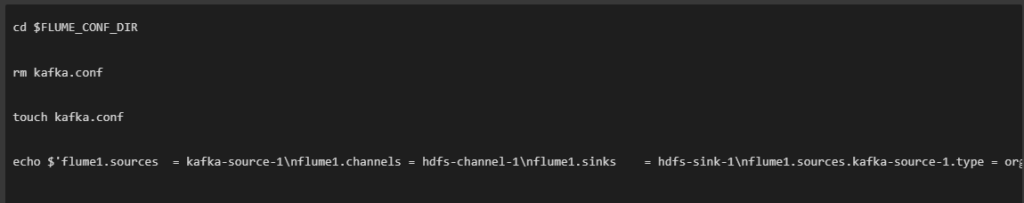

Para realizarlo por medio de un comando, este se vería así:

Una vez definido el archivo del consumidor, deberás arrancarlo con Apache Flume:

- flume-ng agent -n flume1 -c conf -f kafka.conf – Dflume.root.logger=INFO,console

¡Lo has logrado! A partir de ahora, cada mensaje que envías en el productor que has arrancado en Kafka se va a desviar al sink de HDFS (Hadoop Data File System).

Finalmente, para ver el resultado, este deberá aparecer una vez realices el siguiente comando:

- hdfs dfs -ls -R /tmp/kafka/

¿Cómo continuar aprendiendo sobre Big Data?

Por medio de este post, has podido identificar cómo funciona el entrar a un clúster de Dataproc con Shell. No obstante, este desarrollo exige continuar practicando para ganar experiencia. Si no tienes claro cómo puedes empezar, ¡desde KeepCoding te traemos una alternativa!

Nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning cuenta con once módulos que te prepararán y pondrán a prueba tus destrezas con las principales herramientas desarrolladas para el procesamiento de los macrodatos. Para ello, también contarás con el apoyo de una serie de expertos en Big Data que te guiarán en los procesos tanto teóricos como prácticos. ¡No esperes más, inscríbete y empieza ahora!