En el desarrollo del Big Data podrás contar con una gran variedad de herramientas, sistemas y lenguajes que se dedican a la gestión de los macrodatos. En cada uno de estos procesos se logra la facilitación de la manipulación de la información y se ayuda a destacar el valor de los datos para potenciar decisiones y rutas de acción.

Por ello, contar con conocimientos como la configuración de colas de procesamiento en Hadoop se muestra como un conocimiento más que necesario, puesto que estas se prestan para facilitar y personalizar el desarrollo de la gestión de datos. Por esta razón, en este post te compartimos cómo funciona configurar colas de procesamiento en Hadoop.

¿Qué es una cola de procesamiento en Hadoop?

Las colas de procesamiento en Hadoop hacen referencia al proceso de organización que adquieren las consultas de datos una vez se van realizando. Así, podrás encontrar el sitio al que llegan todas las peticiones y se va formando la estructura de fila que es el punto default.

Se le llama así porque las colas no reconocen cuál de las peticiones es más importante, ya que usan la metodología FIFO (First in, first out). Esto quiere decir que otorga la prioridad al procesamiento de datos según el orden de llegada de las peticiones.

Sin embargo, este tipo de orden no siempre será el adecuado, razón por la que es necesario contar con herramientas como Scheduling, que permiten configurar las colas de procesamiento en Hadoop.

Configurar colas de procesamiento en Hadoop

Llevar a cabo la configuración de colas de procesamiento aporta una gran ventaja en la personalización de la gestión de datos a partir de la búsqueda, administración y resultados arrojados.

De hecho, trabajar con este tipo de procesos se acoplará a las prioridades de consulta que planees manejar por medio de la división y clasificación de colas de peticiones. Por ejemplo, herramientas como Scheduling te permiten remitir determinados datos a colas específicas y de qué manera se acumularán las peticiones en una u otra cola.

Configurar un par de colas de procesamiento

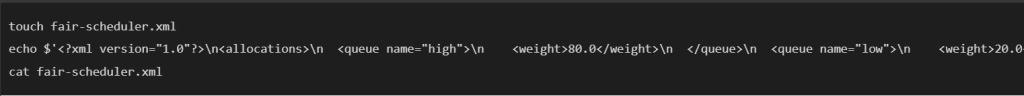

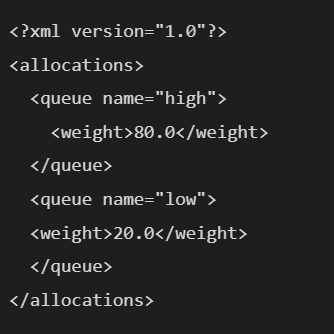

En primer lugar, te mostraremos cómo podrás configurar dos colas (una de alta prioridad y otra de baja prioridad por simplificar). En la consola, este proceso se desarrolla de la siguiente manera:

Dentro de las otras opciones de configuración de colas de procesamiento en Hadoop, también podrás desarrollar un “balanceador”. Esta herramienta te permitirá gestionar el tráfico de peticiones y datos de manera automática una vez lo hayas implementado. A continuación, te compartimos cómo se ve el equivalente a incluir un “balanceador” de colas con el contenido anterior:

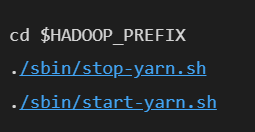

Ahora bien, si lo que quieres es retomar los cambios, tendrás que reiniciar el YARN (Yet Another Resource Negotiator) en todos los nodos de la siguiente manera:

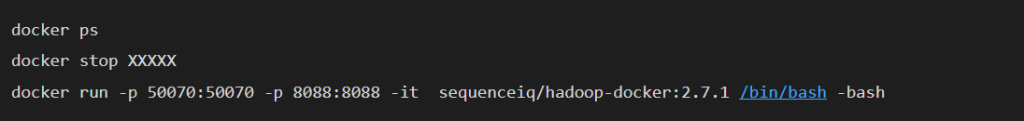

Si no consigues desarrollar alguno de los comandos

Ten en cuenta que si te llegas a quedar atascado en alguno de los comandos, para avanzar solo debes cerrar el terminal y abrir otro al escribir:

Una vez estés realizando tu propio ejemplo debes reemplazar la nomenclatura de XXXXXX por el nombre o identificador del container con el que estabas trabajando.

¿Cómo enviar un job a una cola específica?

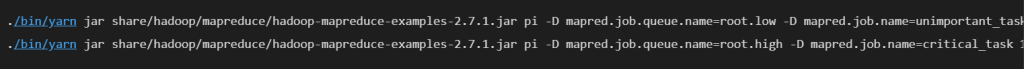

Dentro del manejo de las colas de procesamiento en Hadoop también podrás contar con un proceso muy útil que consiste en enviar determinado job a una cola específica según la intención de la administración de los datos. Para ello, el comando se desarrolla de la siguiente forma:

Continúa aprendiendo más sobre Big Data

En el desarrollo de este post, has podido comprender cómo se configuran las colas de procesamiento en Hadoop. Por medio de ejemplos ilustrativos, habrás notado cómo funcionan estas colas y su importancia dentro de la aplicación de las herramientas Big Data. En efecto, este factor aporta una gran facilidad en la gestión de datos. Sin embargo, aún queda mucho por aprender.

Por ello, desde KeepCoding te traemos como alternativa para continuar instruyéndote el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Por medio de este bootcamp, podrás aprender a desarrollar toda la serie de herramientas, sistemas y lenguajes desarrollados para destacar el valor de los macrodatos. En menos de nueve meses, este proceso te aportará las bases suficientes para convertirte en todo un experto Big Data, gracias a su metodología “hands on” y de la ayuda de grandes profesionales. ¡Empieza ahora!