Cómo puedes ejecutar jobs sin comandos a mano en Dataproc es uno de los conocimientos que debes saber para el manejo más profundo y efectivo de Google Cloud Dataproc, puesto que este servicio de Google es uno de los softwares libres de Big Data más utilizados. Además, aporta una gran variedad de herramientas y es totalmente gestionado.

Por ello, en este post, te compartimos una breve guía de cómo ejecutar jobs sin comandos a mano en Dataproc.

Ejecutar jobs sin comandos a mano en Dataproc

En primer lugar, para explicarte cómo ejecutar jobs sin comandos en Dataproc, hay que partir de la facilidad que presta GCP (Google Cloud Plataform) Dataproc en la gestión de datos en una red. Además, dentro de sus posibilidades se encuentra el hecho de que podrás utilizar el control de ficheros de forma directa por medio de la consola.

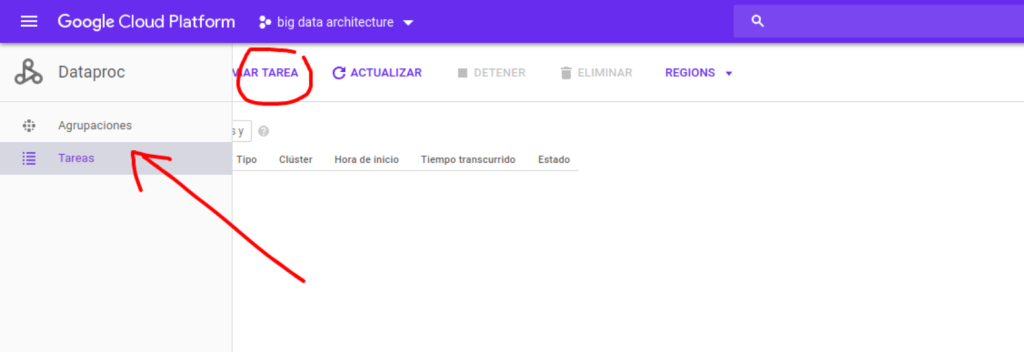

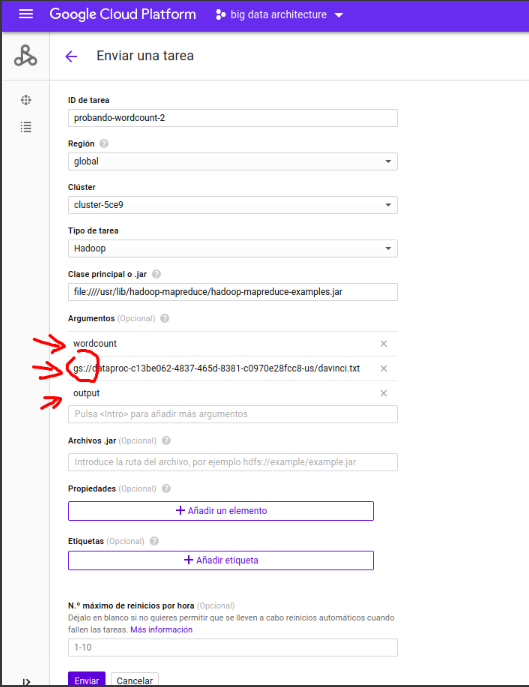

Por otra parte, también podrás ejecutar jobs de MapRed de la siguiente manera:

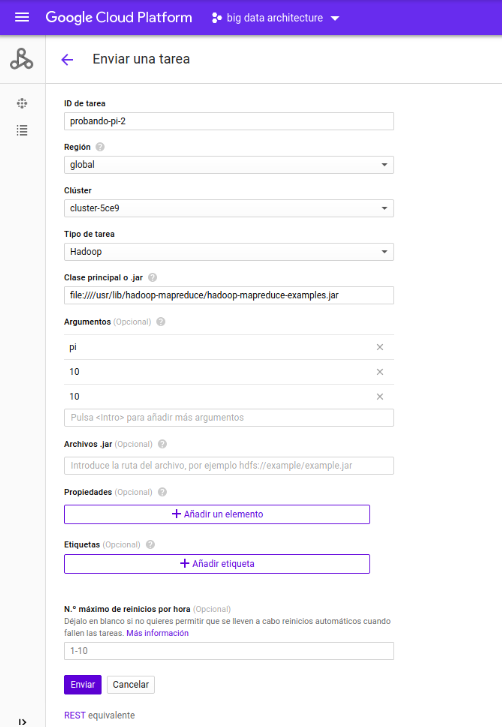

Ahora, debes rellenar el formulario con lo siguiente:

Dentro del JAR pondrás: file:////usr/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar

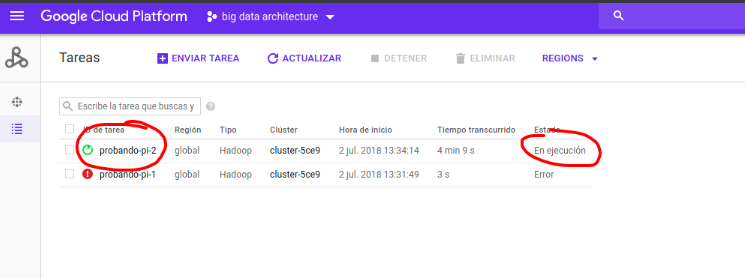

Posteriormente, podrás ir a la vista de tareas y ver el resultado de los jobs sin comandos a mano en Dataproc.

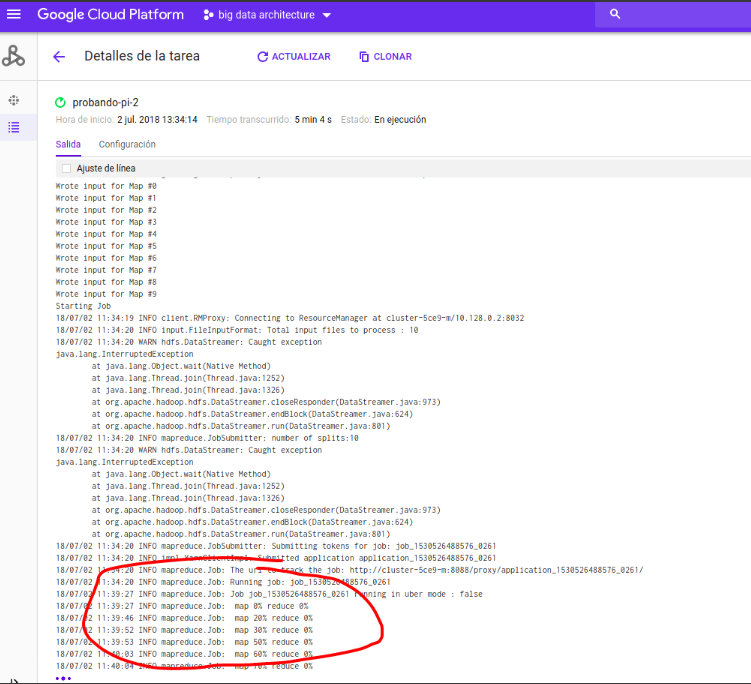

También puedes ver los logs y el resultado así:

Subir ficheros y utilizarlos

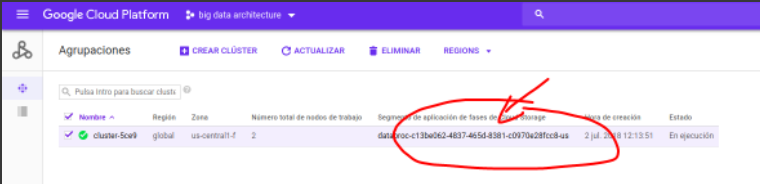

Al crear clústeres, GCP (Google Cloud Plataform) automáticamente crea un storage segment (el equivalente a un bucket de S3 de AWS) conectado a través de un conector.

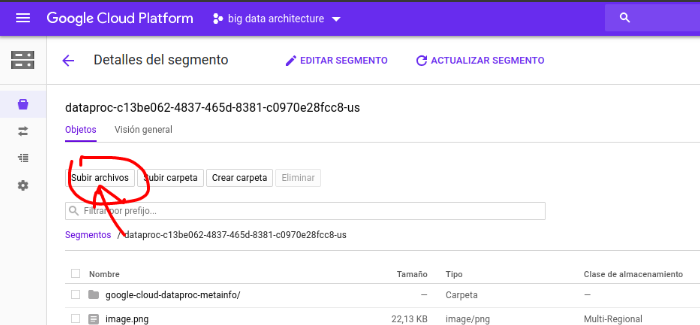

Por lo tanto, podrás subir los ficheros al bucket y tenerlos disponibles tanto para ejecutar jars como para cargar datos en HDFS (Hadoop Distributed File System):

Una vez dentro, podrás subir ficheros, carpetas, archivos .jar, etc. Estos estarán disponibles para ejecutar tareas o para cargar al HDFS (Hadoop Distributed File System).

Ahora, haz una prueba subiendo el archivo de txt de pruebas de scraping. Para ello, debes descargar un dataset de noticias y, después, subirlo:

Para ello debes emplear: file:////usr/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar

Después, utilizarás: gs:///bigdata-9/xxxx/xxxx.csv

Finalmente, los resultados deberían estar en:

- hdfs dfs -ls output

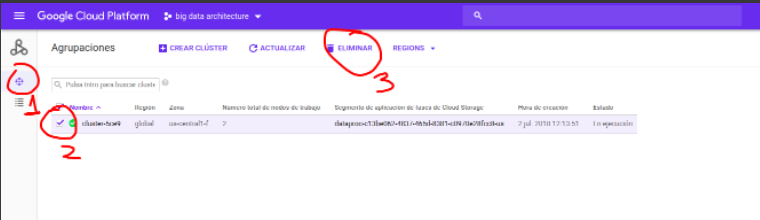

Por último, recuerda apagar al final para no gastar recursos y dinero.

Aprende más sobre Big Data con KeepCoding

En el transcurso de este post, te hemos mostrados una breve guía de cómo ejecutar jobs sin comandos a mano en Dataproc y cuál es su importancia dentro del mundo Big Data. Sin embargo, este es un primer acercamiento a las funciones que cumplen los jobs dentro de Dataproc.

Para continuar aprendiendo y convertirte en un experto, desde KeepCoding te presentamos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En él, te encontrarás con una serie de módulos con las herramientas, sistemas y lenguajes más populares e importantes del mundo Big Data. ¡Apúntate ya!