El entrenamiento de una red neuronal en Deep Learning suele ser un conocimiento que se ignora; sin embargo, este es uno de los primeros pasos y, por tanto, uno de los más fundamentales para llevar a cabo un procesamiento efectivo dentro del Deep Learning.

En efecto, el aprendizaje de una red neuronal se asegurará de la forma en la que los resultados arrojados sean eficaces y adecuados. Por esta razón, en este post, te compartimos en qué consiste el entrenamiento de una red neuronal en Deep Learning.

Entrenamiento de una red neuronal en Deep Learning

Como primer acercamiento, el entrenamiento de una red neuronal en Deep Learning es uno de los primeros factores a considerar para implementar este tipo de procesamiento. De hecho, se puede decir que el aprendizaje de una red neuronal se asemeja al de los seres humanos, que es el aprendizaje basado en ejemplos. Al igual que los seres humanos, las redes neuronales analizan objetos, predicen lo que representan y se corrigen en caso de que se equivoquen. Tras está corrección, varían su conocimiento para no producir el mismo error.

Por tanto, el entrenamiento de una red neuronal se basa en cuatro pasos básicos: forward pass, comparación con el Ground truth (GT), cálculo del error total y backward pass o backpropagation.

¿Y cómo varían las redes neuronales su conocimiento para asemejarse lo máximo posible a la verdad absoluta o Ground truth? Es sencillo: minimizando el error obtenido. ¿Recuerdas cuál es el método más utilizado para la minimización de una función? ¡El descenso de gradiente!

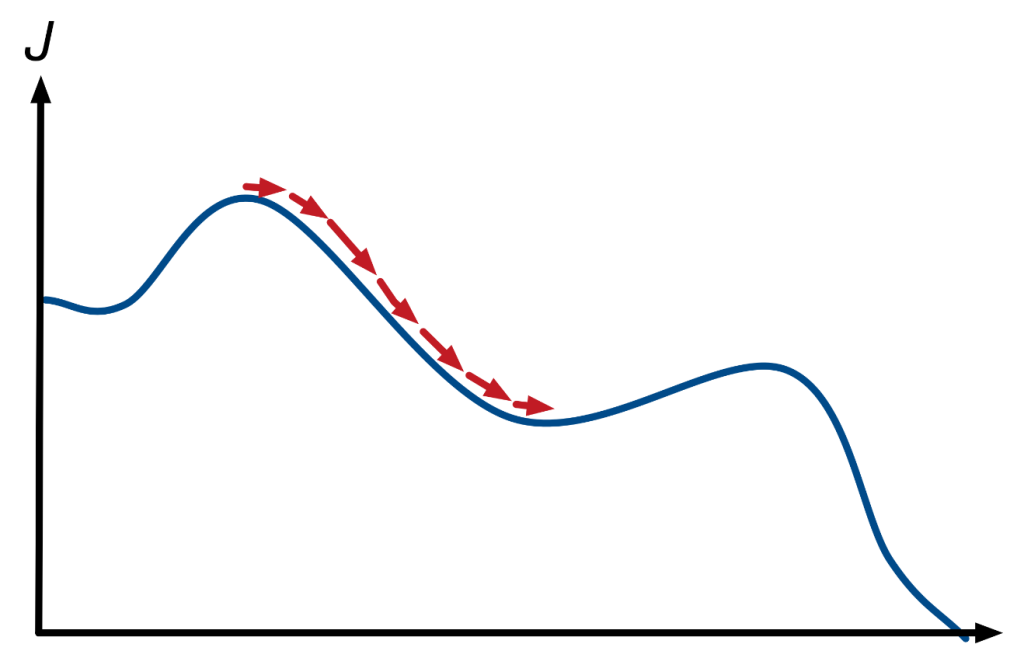

Imagínate que la ruta para bajar de la montaña es la función que queremos minimizar para llegar al error mínimo (la zona baja de la montaña), ¿cómo podríamos calcular la pendiente en cada punto para elegir el camino óptimo?

La respuesta es calculando la derivada, que se expresa así:

f′(x)=f(x+h)−f(x−h)/2, cuando h→0.

La primera derivada de una función mide la rapidez con la que cambia una función, es decir, cuánto crece o decrece. Así que lo que podemos hacer es calcular la pendiente para cada punto al que llegamos para seguir bajando esa pendiente hasta un punto mínimo.

En efecto, el entrenamiento de una red neuronal en Deep Learning va a ir de derivadas. El descenso del gradiente, algoritmo de optimización que permite minimizar cualquier función (siempre que sea diferenciable, es decir, que podamos calcular sus derivadas), va a ser el corazón de las redes neuronales y aquel que nos va a permitir su optimización.

En el desarrollo de este post, te hemos expuesto en qué consiste el entrenamiento de una red neuronal en Deep Learning; sin embargo, este tipo de procesos requiere de muchos más saberes y de una práctica constante. Para ello, te aconsejamos instaurar estos conceptos en tu proyecto de datos para asegurar un estudio de la información eficaz.

Como todavía queda mucho por aprender, desde KeepCoding te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En él, podrás potenciar tus destrezas en el manejo de los macrodatos y en las múltiples herramientas, lenguajes y sistemas más populares. Además, aprenderás todo lo necesario para convertirte en un profesional del Big Data en menos de nueve meses. ¡Pide información y apúntate ahora!