En el presente artículo vamos a estandarizar datos de preprocesamiento en R. Los datos que tenemos son la media y la desviación típica de un ejercicio en donde se hace la predicción de la potencia de generación de una central de ciclo combinado.

¿Qué es estandarizar datos de preprocesamiento en R?

La estandarización de datasets es un proceso en el que se convierten los datos a un formato común para poder permitir a los usuarios procesar y analizar el conjunto de datos.

Este proceso se utiliza para crear consistencia en los datos y facilitar su uso posterior en las empresas y organizaciones. Se usa en contextos de machine learning y algoritmos de smart learning.

En el proceso de estandarizar datos de preprocesamiento en R, los valores se centran alrededor de la media con una desviación estándar unitaria. Esto quiere decir que la media del atributo se convierte en 0 y la distribución resultante tiene una desviación estándar unitaria.

La fórmula para la estandarización es:

Ejercicio para estandarizar datos de preprocesamiento en R

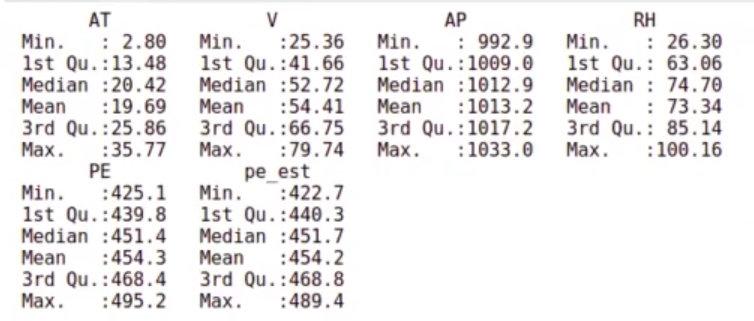

Tenemos el testing del ejercicio:

Al modelo de regresión lineal no se le pueden pasar esos datos, se tienen que estandarizar. ¿Y cómo podemos estandarizar datos de preprocesamiento en R?

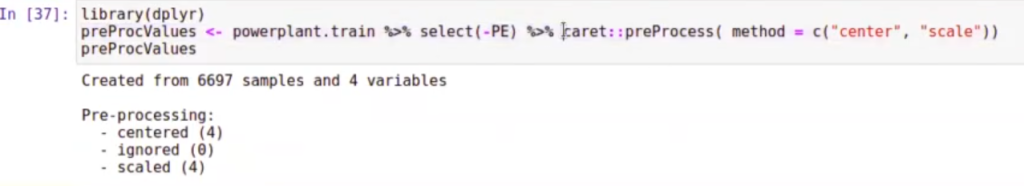

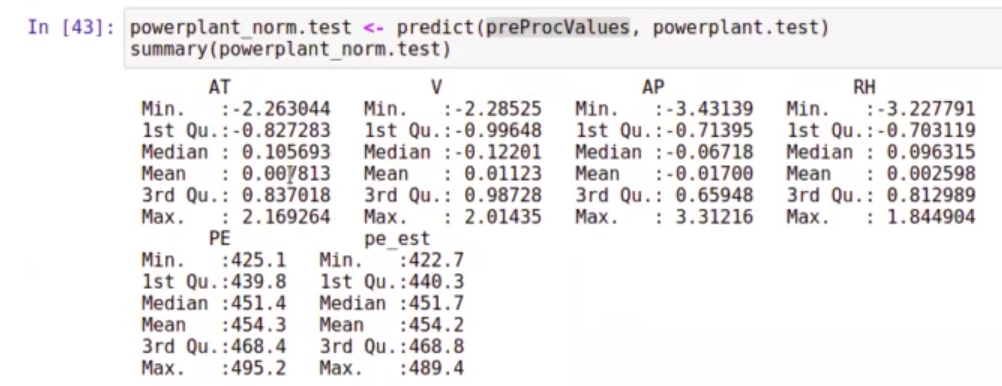

Lo hacemos con la función predict con el modelo preProcValues, el cual se había creado previamente con este código:

Con la información contenida en este dataset, vamos a realizar la estandarización. ¿Qué información contiene esto? Contiene la media y la desviación típica. Se sabe cuánto hay que restar, cuál es la media que hay que restar a cada uno de los elementos y por cuánto hay que dividirlo.

Si nos fijamos bien, la media (reflejada en la fila Mean) ya no es 0, ya que está estandarizada con la media del grupo de datos de train.

Lo más importante que tienes que aprender es que los valores de normalización, que pueden ser con la media, el máximo, el mínimo o lo que quiera, se deben calcular solo entre el train. Una vez hecho esto, el train se guarda y se utiliza luego para el testing.

¿Quieres seguir aprendiendo?

Si quieres seguir aprendiendo más sobre esta temática, puedes entrar en nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp, donde, en unos pocos meses, vas a aprender todo lo necesario para incursionar en un mercado laboral lleno de ofertas de empleo. ¡Anímate a impulsar tu carrera y solicita más información!