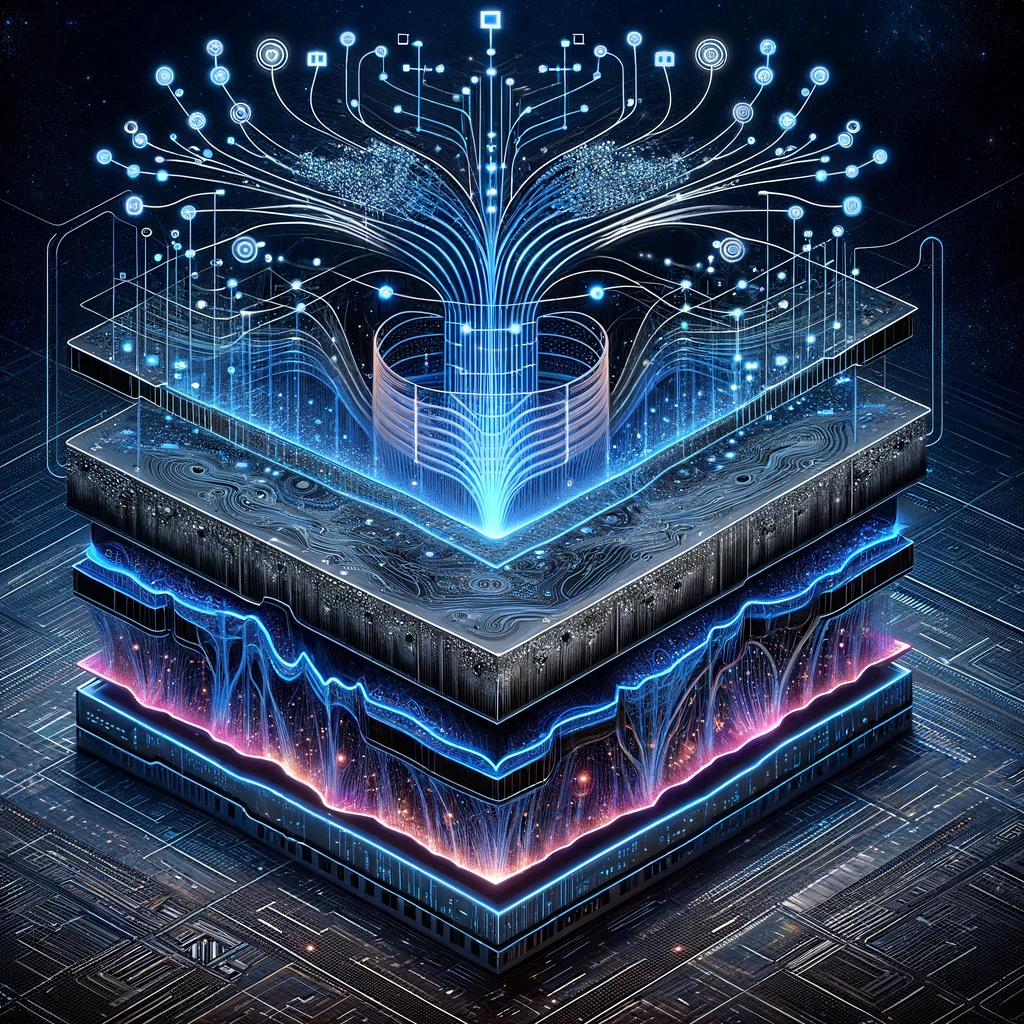

Los transformers en el campo del machine learning (ML) son una pieza fundamental en el mundo de las redes neuronales y el deep learning. Estos modelos basados en redes neuronales han revolucionado la forma en la que procesamos grandes conjuntos de datos de texto a gran escala. En este artículo, exploraremos la estructura general de un transformer en ML, su importancia en el procesamiento de datos de texto y su impacto en la industria de la tecnología.

¿Qué es un modelo transformer en ML?

Un transformer en ML es una arquitectura de red neuronal desarrollada en el campo del machine learning que ha revolucionado la forma en la que las máquinas procesan y comprenden el lenguaje humano. A diferencia de las arquitecturas de redes neuronales recurrentes (RNN) anteriores, que dependían de secuencias de datos anteriores para comprender el contexto, los transformer en ML destacan por su capacidad para capturar relaciones y patrones a larga distancia en el texto. Esta característica ha permitido avances significativos en una amplia variedad de aplicaciones de procesamiento del lenguaje natural.

La estructura fundamental de un transformer se basa en la atención multicabeza, una técnica que le permite al modelo asignar pesos a diferentes partes de una secuencia de entrada, enfocándose en las palabras o tokens más relevantes en un contexto dado. Esto ha demostrado ser esencial para comprender y generar texto coherente y relevante.

Componentes clave de un transformer

Un transformer en ML consta de varias capas, incluyendo una capa de codificación y una capa de decodificación. En la capa de codificación, el texto de entrada se descompone en vectores numéricos que representan el significado contextual de cada palabra o token. Luego, la atención multicabeza se aplica para comprender las relaciones entre las palabras en el contexto. Finalmente, en la capa de decodificación, se genera el texto de salida a partir de la representación numérica del texto de entrada.

- Capa de codificación. En esta capa, el texto de entrada se descompone en vectores numéricos que la red puede procesar. Cada palabra o token se representa mediante un vector que captura su significado contextual.

- Atención multicabeza. La atención multicabeza permite al modelo capturar relaciones entre palabras a diferentes distancias en el texto. Esto es crucial para comprender el contexto en el que se encuentra cada palabra y generar texto coherente.

- Capa de decodificación. Esta capa genera texto de salida a partir de la representación numérica del texto de entrada. Es esencial en tareas como la traducción automática, donde se necesita generar texto en otro idioma.

- Conexiones residuales y normalización. Estas técnicas mejoran la estabilidad del entrenamiento y la capacidad del modelo para aprender patrones en los datos de texto.

Importancia en el procesamiento de datos de texto

Los transformers en ML han cambiado la forma en que procesamos datos de texto en gran escala. Antes de su desarrollo, las redes neuronales recurrentes (RNN) tenían dificultades para capturar relaciones a larga distancia en el texto, lo que resultaba en problemas de coherencia y comprensión. Los transformer en ML superaron estas limitaciones y permitieron avances significativos en tareas como la generación de texto, la traducción automática, el resumen de texto y la clasificación de documentos.

Grandes modelos y conjuntos de datos

Uno de los aspectos más destacados de los transformer en ML es su capacidad para manejar grandes modelos con millones de parámetros. Esto les permite aprender de manera efectiva a partir de conjuntos de datos de texto a gran escala, lo que mejora la calidad de las predicciones y el rendimiento en tareas complejas.

Impacto en la industria de la tecnología

El impacto de los transformer en ML en la industria de la tecnología es innegable. Estos modelos se utilizan en aplicaciones de procesamiento de lenguaje natural en empresas líderes como Google, Facebook y Amazon. Desde asistentes virtuales y motores de búsqueda más inteligentes hasta la automatización de tareas de atención al cliente y la generación de contenido, los transformer en ML están detrás de muchas de las innovaciones tecnológicas más emocionantes.

Descubre la relación de los transformers con el diseño UX/UI

Los transformer en ML representan un avance revolucionario en el procesamiento de datos de texto a gran escala. Su arquitectura única y su capacidad para capturar relaciones a larga distancia han abierto nuevas posibilidades en el campo del procesamiento de lenguaje natural. Si deseas formar parte de esta emocionante revolución tecnológica y cambiar tu vida, te invitamos a explorar el Diseño UX/UI AI Driven Full Stack Bootcamp de KeepCoding. Al finalizar el bootcamp, estarás preparado para una carrera en el sector tecnológico, una industria con una alta demanda de profesionales y oportunidades laborales excepcionales. ¡No pierdas esta oportunidad de transformar tu futuro!