Las extracciones hacia Segmentos de Google Storage en Hive se han ido convirtiendo en una de las estrategias de desarrollo de Hive más populares gracias a su facilitación en el procesamiento de los macrodatos. De forma que si planeas convertirte en todo un experto en el manejo del Big Data, esta herramienta resulta fundamental.

Comprender en profundidad las posibilidades que ofrece a los usuarios y a quién realiza el estudio de los datos te ayudará en la tarea de ser un experto. Por este motivo, desde KeepCoding te traemos una guía básica para identificar qué y cuáles son las son las extracciones hacia Segmentos de Google Storage en Hive.

¿Cómo funciona Google Storage y Apache Hive?

Apache Hive es una infraestructura de almacenamiento de datos, que consta de la ayuda de Data Warehousing y ETL (extraer, transformar, cargar), generada para funcionar sobre YARN (Yet Another Resource Negociator) y HDFS (Hadoop Data File System).

Por otra parte, Google Storage o Google Cloud Storage es conocido por su principal función de almacenar los macrodatos en la GCP (Google Cloud Plataform) y, a partir de allí, ceder o denegar el acceso a ellos.

Ahora bien, las extracciones hacia segmentos de Google Storage en Hive requieren una relación entre estas dos herramientas y esta se establece a partir de la forma en la que compaginan sus funciones. Es decir, Google Storage te servirá para cargar a la nube los datos almacenados en Hive y poder acceder a ellos en remoto. En efecto, el desarrollo del Google Storage no se encuentra en el local de Hive, puesto que Google es un software que está ejecutándose dentro del clúster trabajando con los HTTPs.

Por otra parte, contarás con la excepcional tarea que hace Google Storage, que consiste en mapear el Google Store con el de data feed, es decir, a medida que se lleva a cabo el almacenamiento del Big Data, se actualiza inmediatamente la información de estos que se ofrece a los usuarios en tiempo real.

¿Cómo son las extracciones hacia Segmentos de Google Storage en Hive?

El funcionamiento de las extracciones hacia segmentos de Google Storage en Hive se basa en un comando muy sencillo. En primer lugar, debes partir de que este proceso no es más que una query compleja dentro de Hive que se apoya en Google Storage.

En otras palabras, lo que sucede es que desde Hive se realiza una petición de información y dicha información se encuentra contenida en Google Storage, por lo que deberás crear una carpeta output para guardar el resultado de esta query.

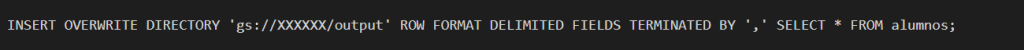

A continuación, desde KeepCoding te mostramos cómo funciona la extracción hacia segmentos de Google Storage en Hive. En este ejemplo de query se pide que extraer un segmento que parte de la clasificación de alumnos. Para ello, el comando se desarrolla en la consola con la siguiente sintaxis:

- INSERT OVERWRITE DIRECTORY ‘gs://XXXXXX/output’ ROW FORMAT DELIMITED FIELDS TERMINATED BY ‘,’ SELECT * FROM alumnos;

En el ejemplo anterior, deberás sustituir XXXX con el nombre del segmento, es decir, de la carpeta de output que hayas creado. Por último, ten en cuenta que existe una gran cantidad de comandos, como modificar tablas, jugar con joins, funciones, etc.

¿Cómo continuar aprendiendo sobre Big Data?

En el desarrollo de este post, has podido llegar a conocer más sobre las extracciones hacia Segmentos de Google Storage en Hive y su importancia dentro del mundo Big Data. Sin embargo, habrás podido notar que este es un tema extenso y que requiere mucha práctica para dominarlo. Si quieres convertirte en un experto y no sabes por dónde empezar, no te preocupes, porque desde KeepCoding te traemos la solución ideal.

Nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning te aproximará a los lenguajes, sistemas y plataformas más populares e importantes para el manejo de los macrodatos. Por medio de este bootcamp, podrás recorrer de forma práctica todos y cada uno de los módulos de Spark, iniciando camino en su ‘core’ y transitando por Spark SQL, Spark Streaming (Structured), Spark MLlib (Machine learning) y GraphX (información almacenada en estructuras arborescentes). ¿A qué estás esperando para empezar? ¡Consulta nuestro temario y apúntate ya!