Los ficheros de configuración en Hadoop se han establecido como una gran herramienta para la facilitación de la gestión de los macrodatos en esta biblioteca de software. Hadoop cuenta con muchas más herramientas y procesos que te ayudarán durante el procesamiento de la información. Por tanto, conocer cómo funcionan y se desenvuelven en este proceso es de suma relevancia para un desarrollo efectivo del análisis de datos.

En KeepCoding reconocemos este valor, por lo que en este post te exponemos cómo funcionan los ficheros de configuración en Hadoop y cuál es su implicación dentro del universo del manejo Big Data.

¿Qué son los ficheros de configuración en Hadoop?

Tal como indica su nombre, los ficheros de configuración en Hadoop son los archivos que ayudan a la modificación del entorno distribuido y de código abierto de Hadoop.

Estos tipos de ficheros se dedican a administrar de forma personalizada el flujo de datos por medio de un clúster. En suma, dichos ficheros se encuentran en determinados directorios de Hadoop según su función.

De manera general, podrás contar con los dos archivos de configuración más empleados, que son:

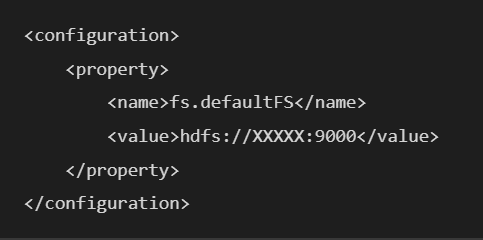

- core-site.xml: este fichero de configuración consigue editar el directorio de HDFS dentro del localhost, es decir, la base de la distribución de los datos. Su comando funciona como te mostramos a continuación:

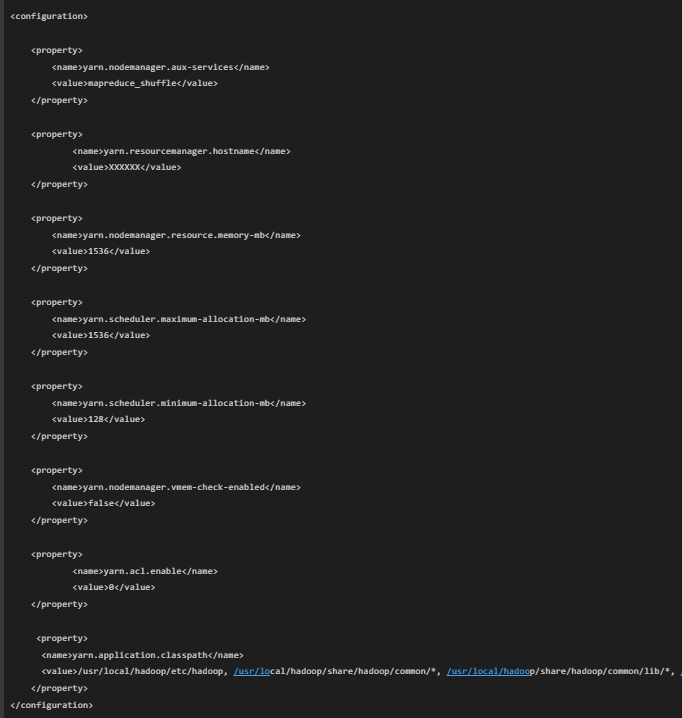

- yarn-site.xml: este fichero de configuración se utiliza para realizar una modificación en el YARN (Yet Another Resource Negotiator) de Hadoop. Es decir, la parte de distribución de recursos de búsqueda que maneja esta plataforma. La sintaxis de su comando debe verse de la siguiente manera en la consola:

¿Cómo funcionan los ficheros de configuración en Hadoop?

Como ya te hemos mencionado, los ficheros de configuración en Hadoop se agrupan en determinados directorios según sus funciones. Podrás encontrarlos en /usr/local/hadoop/etc/hadoop. Así, por medio de estos directorios y archivos de configuración podrás administrar un clúster en Hadoop efectivamente.

Como ya te hemos compartido los ficheros más importantes, ahora te exponemos los directorios más empleados en este sistema distribuido:

Directorio bin

Este primer directorio cuenta con los archivos ejecutables de los principales servicios de Hadoop, como HDFS (Hadoop Distributed File System) y YARN (Yet Another Resource Negociator). Por esta razón, su funcionamiento es de vital importancia.

Directorio sbin

El directorio sbin consta de los ejecutables de arranque para empezar la gestión de los datos. En suma, también se encarga de la administración de los principales componentes de Hadoop como YARN (Yet Another Resource Negociator) y MapReduce.

Debes tener en cuenta que, una vez ejecutes un jps. en Hadoop, por defecto, te aparecerá este directorio. Además, lo necesitarás para la implantación del directorio usr, ya que también cuenta con todos los ejecutables del directorio bin.

Directorio share

Este tipo de directorio se basa en mantener y proteger la documentación y los ejemplos que son compartibles entre las máquinas por medio de la red.

Así que aquí se suelen cargar los archivos .jar una vez los lances, puesto que, una vez se instauran en las máquinas los archivos comprimidos que han sido compartidos, estos se almacenan en el directorio share.

Directorio etc

En el directorio etc se encuentran la mayoría de ficheros de configuración, especialmente los ubicados dentro de Hadoop, a pesar de que también administra los ejecutables de configuración para los programas y aplicaciones que se instauran posteriormente.

Directorio usr

Por último, el directorio usr es de suma importancia, ya que contiene los ficheros de configuración en Hadoop que facilitan el restablecimiento del sistema En suma, este directorio ofrece un entorno común entre los programas y gestiona el acceso de los usuarios a este entorno.

¿Cómo aprender más sobre el Big Data?

A lo largo de este post, has podido comprender cómo funcionan los ficheros de configuración en Hadoop. No obstante, debes tener en cuenta que para lograr un conocimiento más preciso es necesario llevarlo a la práctica, puesto que cada uno de los aspectos mencionados se rectifican en la consola de Hadoop. Por eso te aconsejamos ponerlo en práctica por medio de la metodología ensayo y error hasta que consigas comprenderlo del todo.

Desde KeepCoding, sabemos que instruirte por tu cuenta puede resultar complicado y aburrido, por ello, te presentamos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Por medio de este, podrás contar con todos los conocimientos necesarios para ser un experto en el ecosistema de sistemas, lenguajes y herramientas del Big Data a la par que los llevas a la práctica guiado por gran un grupo de profesionales. ¡No esperes más para inscribirte!