Los jobs en Dataproc son de suma relevancia, ya que, desde la aparición del Big Data, uno de los mayores retos para los Data Scientists ha sido ser capaces de escoger las características, herramientas y lenguajes adecuados para solucionar cada problema. Por ello, identificar cómo funcionan los jobs en Dataproc se presenta como un aliciente para superar este reto.

A causa de ello, desde KeepCoding te compartimos una breve guía de cómo funcionan los jobs en Dataproc.

¿Cómo funcionan los jobs en Dataproc?

Los jobs en Dataproc funcionan como una clase de petición que realiza el administrador para que el sistema lleve a cabo ciertas funciones. De hecho, según dichas funciones podrás contar con diferentes tipos de jobs en Dataproc, por ejemplo, los jobs de tipo dub requieren de un jar.

Por otra parte, para lanzar un job no es necesario que entres al clúster, puesto que GCP (Google Cloud Plataform) cuenta con un sitio donde ataca a los clústers para enviar los jobs.

Jobs: Subir ficheros y utilizarlos

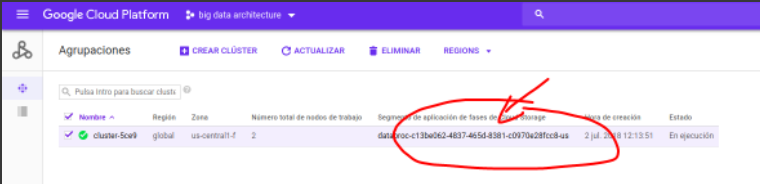

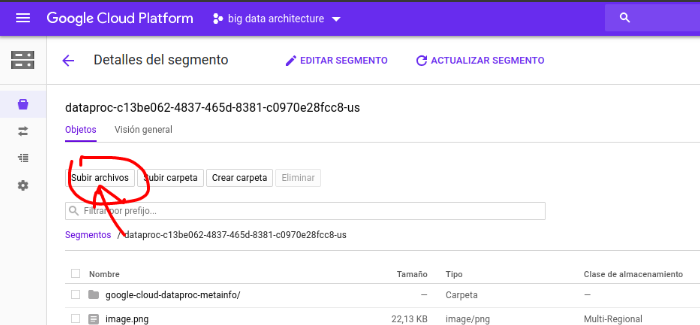

Al crear clústeres, Google Cloud Plataform automáticamente crea un storage segment conectado (el equivalente a un bucket de S3 de AWS). De manera que podrás cargar los ficheros al bucket y dejarlos disponibles para ejecutar jars y para cargar datos en HDFS (Hadoop Distributed File System):

Una vez dentro, podrás subir ficheros, carpetas, archivos .jar... Estarán disponibles para ejecutar tareas y para cargar al HDFS (Hadoop Distributed File System).

A continuación, realiza una prueba subiendo el archivo de txt de pruebas de scraping. Entonces, tendrás que descargar un dataset de noticias y subirlo:

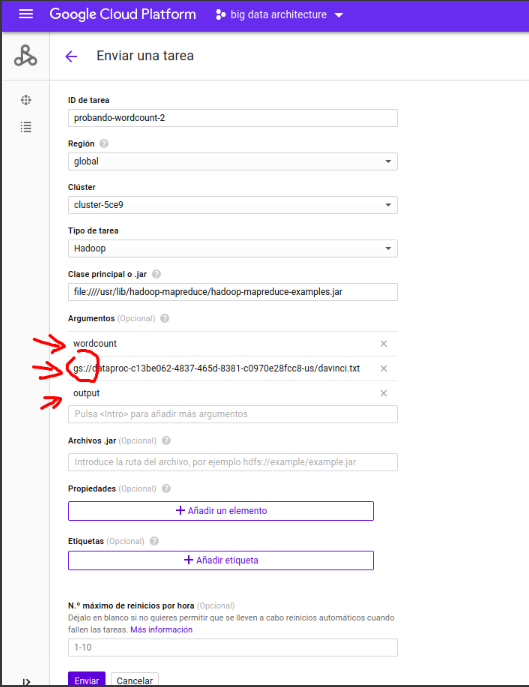

Deberás emplear: file:////usr/lib/hadoop-mapreduce/hadoop-mapreduce-examples.jar

Ahora, ejecutas: gs:///bigdata-9/xxxx/xxxx.csv

Finalmente, los resultados deberían estar en:

- hdfs dfs -ls output

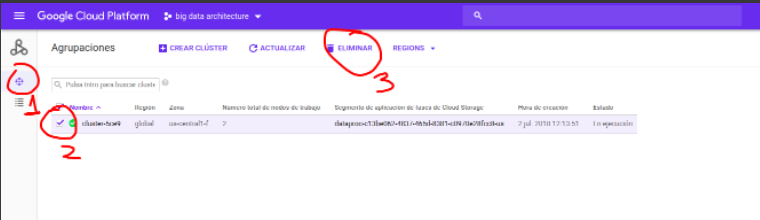

Por último, recuerda apagar al final para no gastar recursos y dinero.

En este post, te hemos expuesto cómo funcionan los jobs en Dataproc, sin embargo, este es solo un primer acercamiento a la variedad de jobs que podrás emplear en Dataproc. ¡Todavía falta mucho por aprender al respecto!

Por ello, en KeepCoding te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En su desarrollo podrás contar con diversos módulos que te orientarán sobre el manejo de los macrodatos. Por ejemplo, en el módulo de Deep Learning se introducen las redes neuronales profundas, que permiten encontrar automáticamente las características adecuadas para solucionar problemas, aprovechándose de la gran cantidad de datos disponibles. ¡Apúntate ahora!