MapReduce en Hadoop forma parte de los componentes fundamentales para desarrollar las funciones principales de este sistema. De manera que, junto a HDFS, YARN y Common, la eficiente estructura de software que ofrece Hadoop no podría llevarse a cabo. Por ello, si buscas comprender este software, es muy importante partir de sus componentes principales.

Debido a esto, en este post te exponemos qué es y cómo funciona MapReduce en Hadoop.

¿Qué es MapReduce en Hadoop?

MapReduce es uno de los módulos esenciales de Hadoop. Este se desarrolla basado en dos componentes clave:

- Map (Reading and formatting data): consiste en la capacidad de leer y formatear datos dentro de la estructura interna del Hadoop.

- Reduce (Applying transformations and operations on all of the data): en español esto se traduce como la aplicación de transformaciones y operaciones en todos los datos.

MapReduce en Hadoop: conteo general de palabras

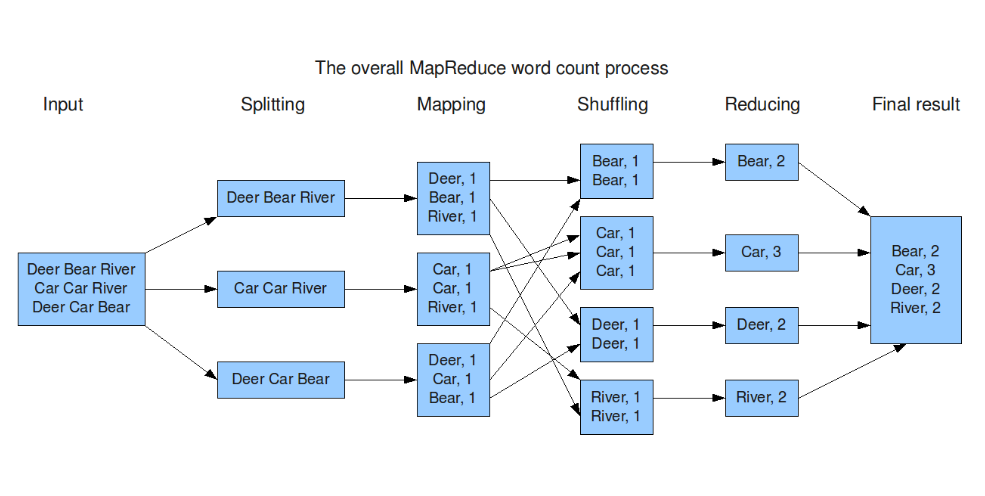

Pues bien, la función de MapReduce consiste en desarrollar un conteo general de palabras. Este proceso se basa en la reducción de los datos por medio de determinados procesos de selección y análisis para facilitar el estudio de la información.

Por ejemplo, si quisieras realizar un estudio lingüístico de Don Quijote de la Mancha, podrías reducir el trabajo si el conteo de palabras te lo divide en siete partes, posteriormente en cinco y así sucesivamente.

De esta manera funciona MapReduce: contará todas las palabras, después dividirá los datos, los volverá a dividir y lo repetirá hasta que se reducen los datos al máximo. Ahora bien, para llevar a cabo este sistema, MapReduce cuenta con una serie de procesos:

- Input (entrada): el primero de ellos consiste en la agregación de la información textual que se procesará.

- Splitting (separar): hace referencia al proceso de división de los datos.

- Mapping (mapeo): mapeo de la información, es decir, la identificación y clasificación de los datos.

- Shuffling (barajar): este proceso consiste en la reubicación de los datos según su relación.

- Reducing (reducir): la cúspide de su función es reducir. Hadoop MapReduce lleva a cabo su principal objetivo de reducir la información basándose en los parámetros de análisis de datos.

- Final result: por último, se arrojan los resultados de la información simplificada.

¿Cuál es el siguiente paso?

Ahora que comprendes más a fondo cómo funciona MapReduce en Hadoop, es imprescindible llevar el conocimiento teórico al proceso práctico para afianzar los conocimientos adquiridos. Si lo que planeas es ser todo un Data Scientist y conocer de lleno los sistemas alrededor del Big Data, ¡desde KeepCoding te ofrecemos una gran oportunidad!

Con nuestro Bootcamp Big Data, Inteligencia Artificial & Big Data podrás contar con el conocimiento y la implementación de los sistemas y herramientas más conocidos en este sector. Este bootcamp te preparará para el inmenso ecosistema de los macrodatos y su capacidad para destacar el valor de la información. Tendrás 11 módulos para instruirte, de forma teórica y práctica, sobre el gran Big Data. ¡Apúntate ahora mismo y continúa aprendiendo!