El clúster de Hadoop en la nube es un elemento fundamental para el desarrollo de esta biblioteca de software en la gestión de los datos. Por ello, su implementación en la nube resulta imprescindible una vez se pasan los macrodatos a la red, ya que a partir de ello se establecen una serie de funciones alrededor de la presencia del clúster. De manera que conocer cómo se implementa en la nube de Hadoop es imprescindible.

A pesar de que montar un clúster de Hadoop en la nube puede parecer un proceso complicado y difícil, su desarrollo trae consigo una gran variedad de ventajas. Además, por medio de ejemplos ilustrativos, este proceso es un poco más comprensible para su aplicación a la consola. Por ello, en este post, te exponemos cómo montar un clúster de Hadoop en la nube.

Algunas consideraciones antes de empezar

Para montar un clúster de Hadoop en la nube es necesario partir de que el objetivo de estos radica en liberarse de los setups locales. Además, este proceso te ayudará a aprender a usar los servicios aprovisionados en la nube de Hadoop.

Conocer estos servicios es de suma importancia, ya que en el desarrollo profesional pocas veces podrás trabajar en equipos locales. Por ello, las herramientas Cloud se convierten en un elemento fundamental.

Sin embargo, trabajar en la nube tiene un precio. A día de hoy, de todos los planes gratuitos o de Trial, el más conveniente es GCP Compute. En líneas generales, GCP te ofrece un crédito de 300 USD para gastar durante tres meses enteros en lo que quieras, a diferencia de otros proveedores que te dan menos tiempo o menos dinero.

¿Cómo montar un clúster de Hadoop en la nube?

En primer lugar, deberás tener una cuenta de Google (puedes crear una nueva de prueba si no quieres desgastar tu cuenta principal). Ahora, para empezar esta pequeña guía de cómo montar un clúster de Hadoop en la nube, utilizaremos la prueba gratis de Google Cloud.

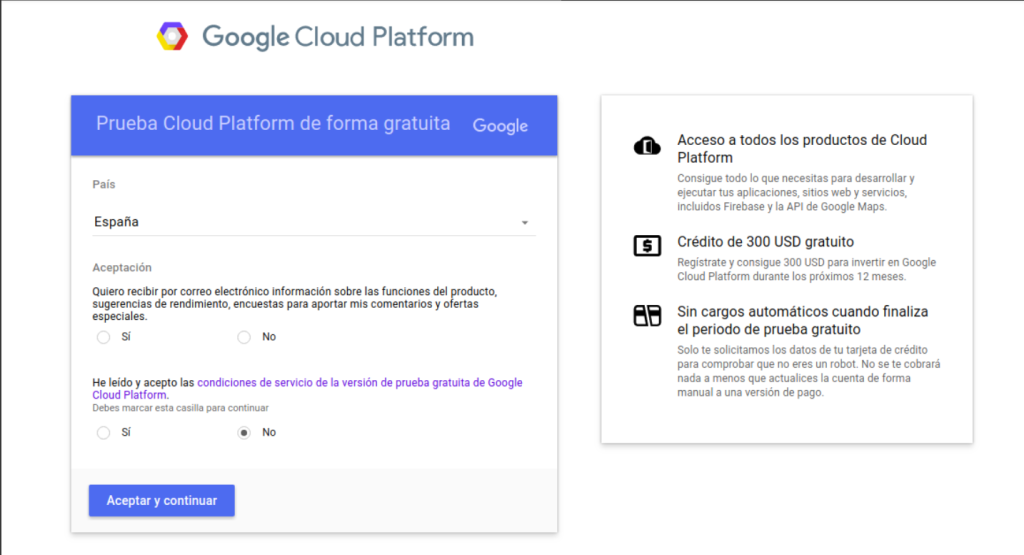

Una vez te dirijas allí y le des clic a la prueba gratis, deberás ver algo como lo que se muestra en la siguiente imagen. Aquí tendrás que dar clic en «aceptar» y «continuar» hasta el final.

Si no te sale algo como la imagen anterior, entonces, verás algo como:

Finalmente, podrás ver la siguiente información, lo que significa que ya estás dentro:

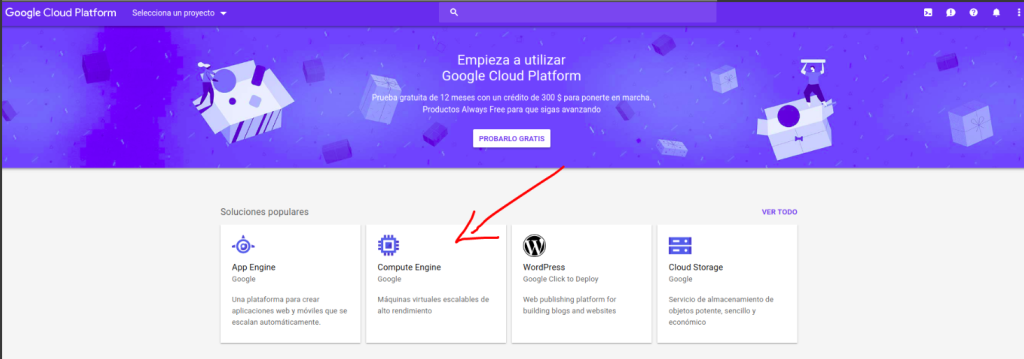

Ahora, tendrás que dirigirte a la plataforma de Google Cloud, en donde deberás hacer clic en la opción de «Compute Engine», como se muestra a continuación:

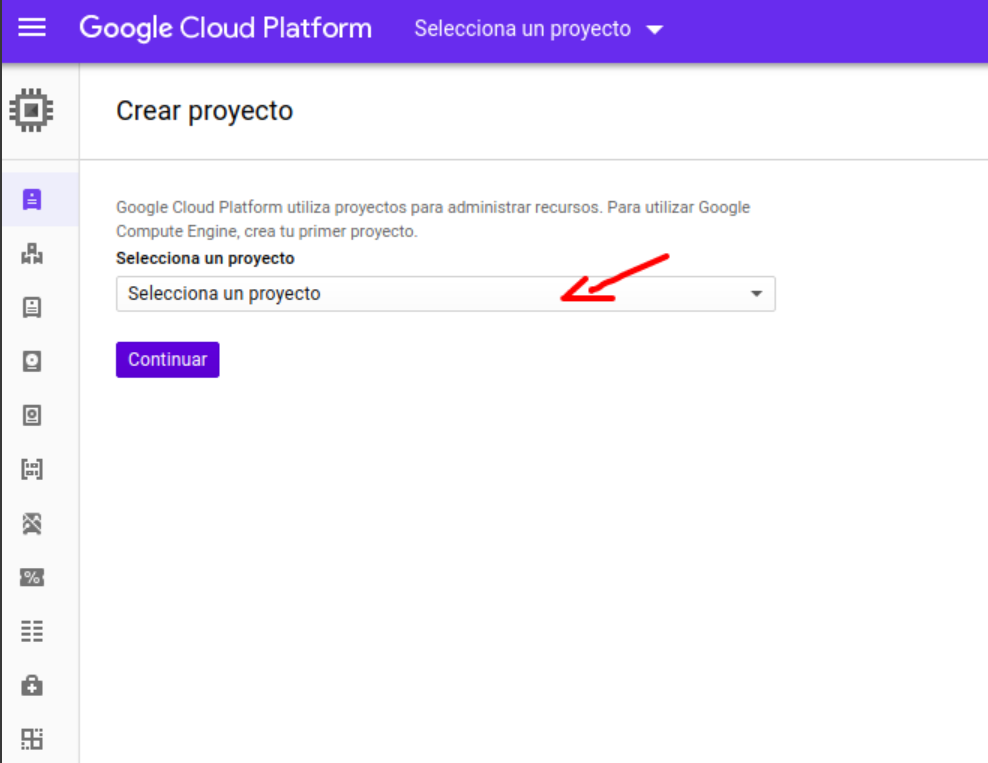

Entonces, se abrirá una ventana de «Crear proyecto», en la que deberás seleccionar un proyecto como ejemplo para montar el clúster de Hadoop en la nube.

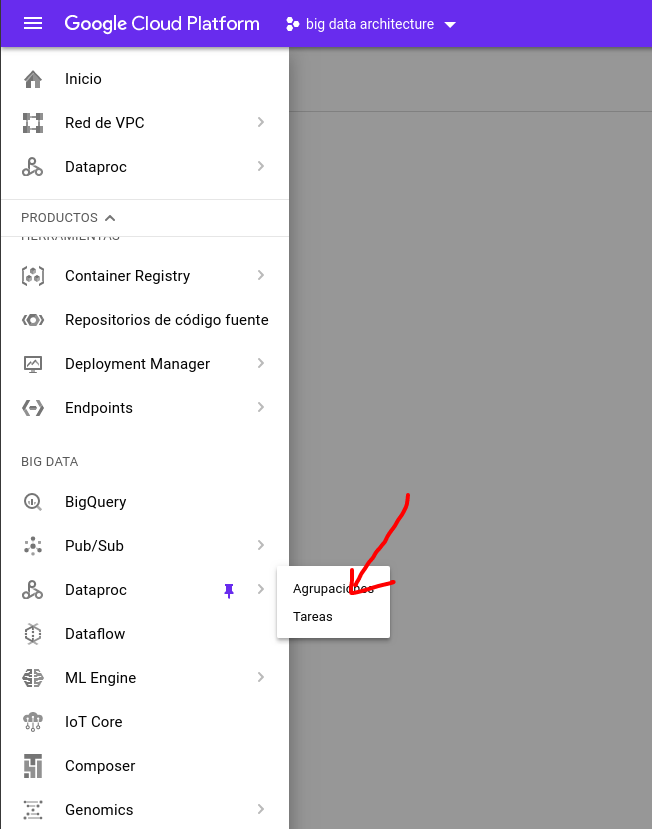

Después, debes seleccionar la opción de Dataproc y luego dar clic en «Agrupaciones».

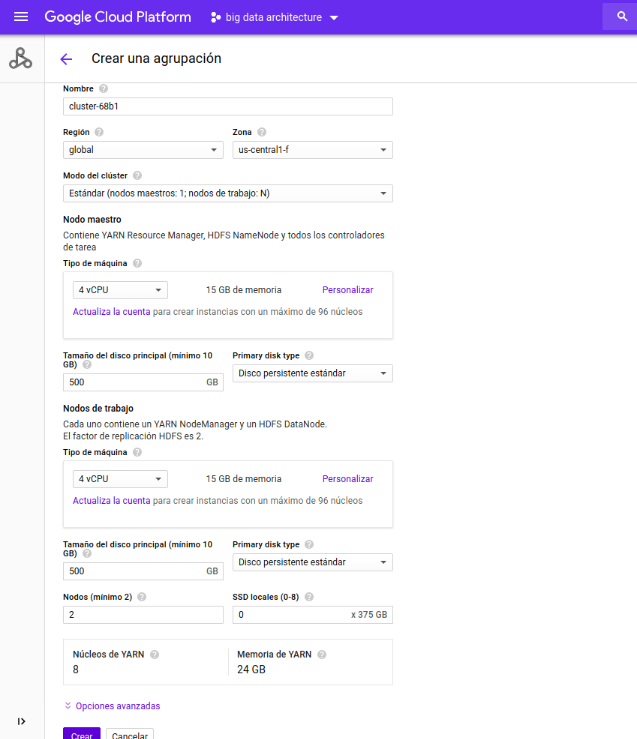

Ahora, saldrá una ventana de «Crear una agrupación», dentro de la que podrás empezar a crear el clúster de Hadoop en la nube.

Llegados a este punto, el proceso consiste en «Definir clúster» y finalizar al dar clic en «Crear».

¿Cuál es el siguiente paso?

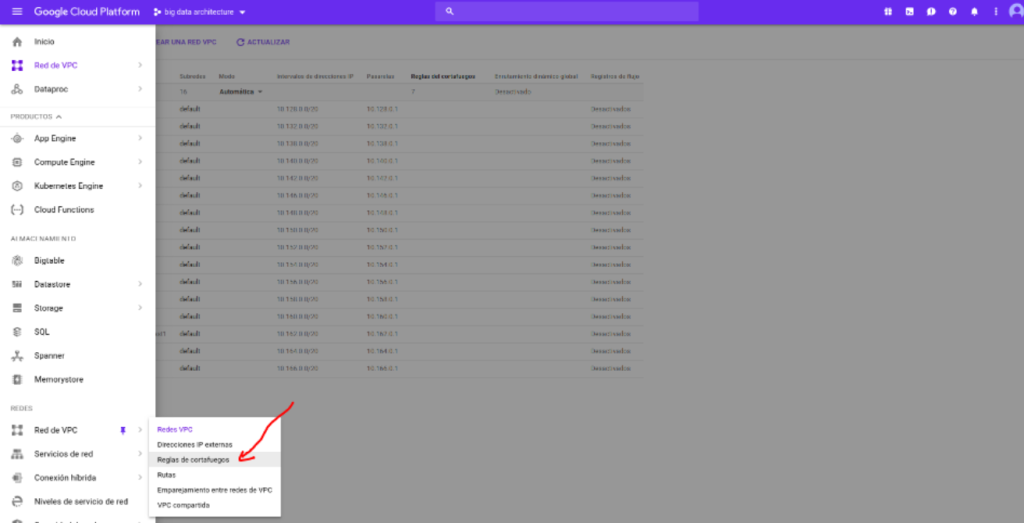

Ahora, podrás analizar la red VPC (Virtual Private Cloud) y el cortafuegos o firewall:

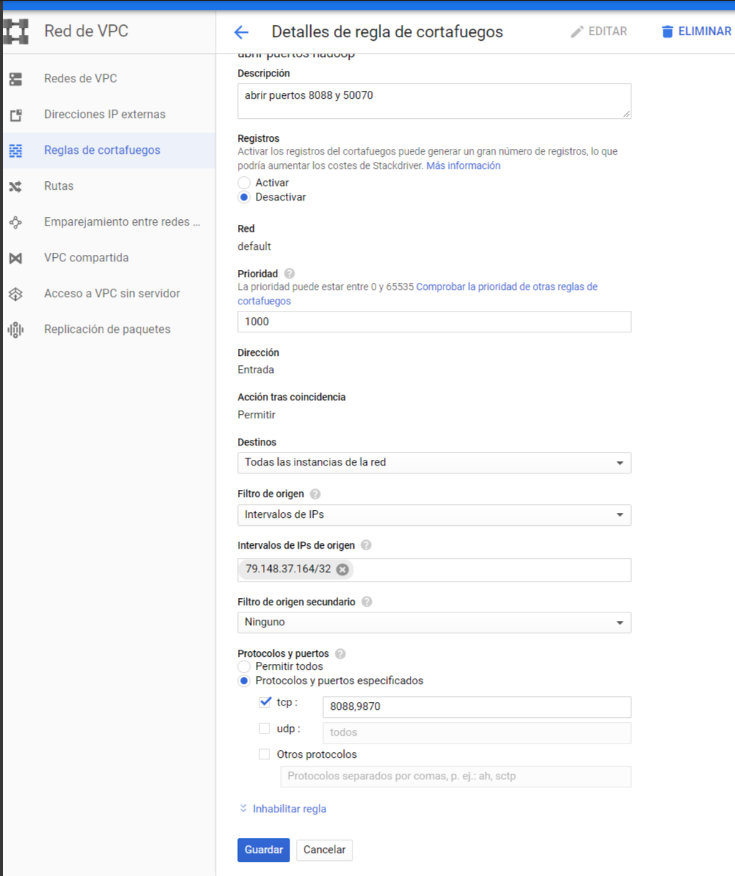

Por otra parte, ten en cuenta que Hadoop en GCP (Google Cloud Plataform) funciona a través de los puertos 8088 y 9870.

Ahora, podrás añadir una nueva regla que te permita entrar en las vistas de administración del clúster, como te mostramos a continuación:

Recuerda que los puertos son: tcp:8088;udp:8088;tcp:9870;udp:9870.

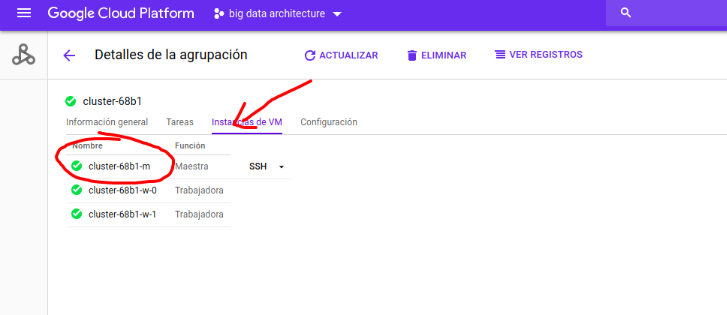

Una vez hecho esto, podrás buscar la IP del nodo maestro, para ello, debes dirigirte a Compute Engine y ver las instancias creadas.

Ahora, podrás entrar al clúster montado.

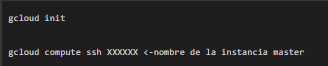

Por otra parte, si quieres entrar a comprobar directamente, podrás descargar GCP (Google Cloud Plataform) SHELL y finalmente, debes ejecutar:

¡Ya estás dentro!

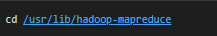

Una vez estés dentro con el SHELL, debes tener en cuenta que esta instalación de Hadoop está hecha por el equipo de Google, por lo que no todos los archivos se encuentran en el mismo lugar.

De hecho, para comprobar los ficheros, deberás ubicarte en el directorio que contiene los archivos .jar de ejemplo de Hadoop, de la siguiente forma:

Ten en cuenta que al estar provisionada no tendrás que ocuparte de arrancar servicios, a menos que quieras arrancar los servicios extra.

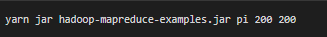

Ahora, por último, podrás calcular PI como siempre lo has hecho en un clúster local.

¿Cómo aprender más sobre Big Data?

En el transcurso de este post, te hemos mostrado cómo montar un clúster de Hadoop en la nube, de manera que ya solo te queda ensayar la parte práctica para complementar el ejemplo presentado. En suma, Hadoop posee múltiples alternativas de desarrollo para que la gestión de la información sea mucho más sencilla, intuitiva y eficaz. De forma que te aconsejamos continuar aprendiendo sobre el manejo del Big Data a través de esta biblioteca de software.

Si aún no sabes cómo y quieres instruirte a profundidad en las principales herramientas para el procesamiento de los macrodatos, desde KeepCoding te ofrecemos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Con este bootcamp, no solo continuarás instruyéndote sobre el Big Data, también podrás hacerlo de manera remota y con el acompañamiento de grandes especialistas en cada uno de sus once módulos de desarrollo. Además, nuestra enseñanza teórica siempre irá de la mano del ensayo práctico. ¿A qué estás esperando? ¡Inscríbete ahora!