El procesamiento de lenguaje natural con inteligencia artificial es un campo dedicado al desarrollo de técnicas que permitan que los ordenadores entiendan y procesen el lenguaje humano en todas sus variantes. Este campo ha sido muy importante durante años y, gracias a ello, hoy son más fáciles las tareas de clasificación de documentos, normalización de textos, traducción automática, reconocimiento del habla, asistentes virtuales…

Procesar lenguaje natural con inteligencia artificial

Hace unos días celebramos un webinar junto a Carlos Rodríguez Abellán, quien nos ha mostrado el mundo del procesamiento del lenguaje natural con inteligencia artificial NLP enfocado en la recuperación de información. Esta es una ciencia que permite encontrar información en datos de naturaleza no estructurada.

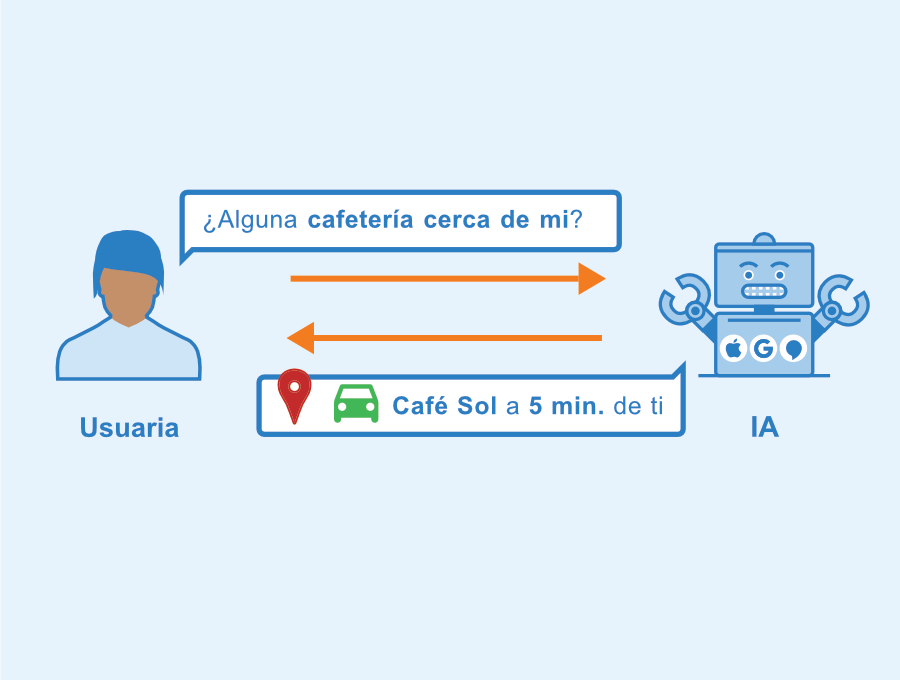

Esto, llevado a un ejemplo, es cuando le preguntas a un asistente virtual como Google, Alexa o Siri el tiempo de hoy o los partidos de fútbol de la semana. Es decir, cuando un usuario envía una query a un sistema de recuperación de información, el cual contiene documentos organizados e indexados de una manera que le da al usuario un resultado en pocos milisegundos.

Para la recuperación de información existen diferentes modelos que varían en su metodología, funciones y resultado, dentro de los modelos más importantes encontramos:

Modelo booleano

Es el modelo más sencillo dentro del lenguaje natural con inteligencia artificial y se basa en la lógica booleana y teoría de conjuntos. En este tipo de modelo no se le da importancia al orden de los documentos, simplemente se atiende una query con una matriz de “incidencia documento-término”. Este modelo es el más sencillo de desarrollar, ya que se utiliza cuando los términos de búsqueda son pocos. Actualmente hay cientos de asistentes virtuales que lo emplean.

Índice invertido

Es la estructura de datos más usada cuando crece el número de documentos y términos en el lenguaje natural con inteligencia artificial, lo que hace que la matriz crezca y, por lo general, se convierta en una matriz sparse. Esto quiere decir que hay muchos términos dentro, pero la mayoría no son comunes entre todos documentos. Por esta razón, la dinámica de este modelo se basa en tokens asignados a cada término, y estos almacenan la información de qué documentos contienen el término asignado.

🔴 ¿Quieres formarte en Inteligencia Artificial a un nivel avanzado? 🔴

Descubre nuestro Inteligencia Artificial Full Stack Bootcamp. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en Inteligencia Artificial por una semanaModelo scoring

Este tipo de modelo de lenguaje natural con inteligencia artificial parte de la premisa de que no todas las palabras o documentos son igual de relevantes. Por esta razón, el resultado que obtiene el usuario al hacer una query se debe organizar en función de la relevancia de los términos que concuerdan con lo buscado. Hay diferentes maneras de otorgar el score a cada término; dentro de las más usadas se encuentran Weighted Zone Scoring, Frecuencia de Término (TF), Frecuencia inversa de Documento (IDF) y la combinación de TF-IDF.

Modelo de espacio vectorial

Cada documento de este modelo de lenguaje natural con inteligencia artificial se entiende como un conjunto de términos que se asocian a un vector para que se pueda organizar de manera espacial. De esta manera, dentro de un vector podrán encontrarse diferentes términos que cumplan con los requerimientos para su asociación.

Las etapas del lenguaje natural con inteligencia artificial varían según el modelo con el que se trabaje; sin embargo, todo se centra en el preprocesado, el cual garantiza que toda la información sea indexada de manera correcta.

Preprocesado de datos

Esta etapa del lenguaje natural con inteligencia artificial recoge los documentos que servirán para solucionar las queries. Estos documentos se dividen en tokens con unidades mínimas de procesamiento, después se identifican las palabras o términos que no son importantes para eliminarlos, se normaliza la información y se finaliza empleando técnicas que ayuden a reducir la dimensionalidad del vocabulario o llevarlo a su raíz a través de técnicas como stemming o lematización.

Para descubrir cómo funciona los modelos de recuperación de datos, aquí te dejamos algunos casos de aplicación práctica que estudiamos en nuestro webinar.

Como puedes ver, el campo del Big Data y la inteligencia artificial tiene miles de aplicaciones que ayudan a convertir proyectos en potentes desarrollos. Para dominar todas las herramientas y metodologías del ecosistema Big Data, descubre nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp. Es un programa diseñado en Silicon Valley para que lleves tu conocimiento de cero a cien en tan solo unos meses con clases teóricas y prácticas que se imparten en directo y en remoto. ¿Quieres conocerlo por completo? ¡Entra ya y pide información!