En el desarrollo de las herramientas del Big Data, las herramientas de arquitectura en tiempo real como PubSub se han convertido en un saber imprescindible una vez se quiere lograr un estudio efectivo de los datos. En efecto, este tipo de arquitectura streaming se reconoce por su ayuda en la clasificación y procesamiento de la información.

Sin embargo, el universo del Big Data es sumamente extenso por el volumen de datos que maneja, de manera que, según su campo y función, requiere de ciertas herramientas. Por ello, a continuación, desde KeepCoding, te exponemos qué es PubSub y cuáles son sus componentes para trabajar con Kafka.

¿Qué es PUBSUB?

PubSub de Google es un servicio de API (Interfaz de Programación de Aplicaciones) que consiste en gestionar la ruta de mensajería entre los diferentes sistemas en la arquitectura del software.

Por otra parte, Pub/Sub es una herramienta que se encuentra a la par de Apache Kafka, puesto que esta es otra alternativa para gestionar el flujo de datos. Sin embargo, es un sistema de streaming opensource escrito en JAVA y Scala. Mientras tanto, PubSub está administrado por Google, es decir, no es de código abierto. No obstante, estos dos patrones de mensajería suelen combinarse según los intereses, ya que su transmisión de datos es sencilla.

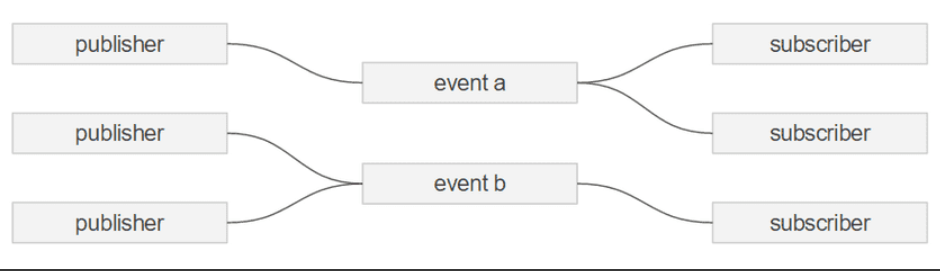

Para la implementación de Pub/Sub has de estar trabajando con streams, ya que este es un patrón de publicación y suscripción. Es decir, este servicio de Google se encuentra en una arquitectura de streaming que tiene siempre uno o más PUBlishers y uno o más SUBscribers, de allí proviene su nombre.

A continuación, te exponemos un esquema sencillo que ilustra cómo funciona este flujo de datos en la arquitectura del software:

Principales características de Pub/Sub

En cuanto a las principales características de PubSub podrás encontrar: el manejo de datos en streaming, la escalabilidad del sistema, los eventos o mensajes, el uso de topics y el filtrado. Con el fin de que comprendas cada uno de estos componentes y características, a continuación te explicamos brevemente en qué consiste cada uno de ellos:

Datos de streaming (flujo de datos)

Este aspecto se refiere al manejo de datos por streams, es decir, al flujo de datos que en PubSub consiste en un patrón de publicación y suscripción. Por otra parte, este componente también remite a su beneficio en trabajar con el Big Data, puesto que el flujo de datos se genera de manera simultánea y a partir de distintas fuentes.

Escalabilidad del sistema

Pub/Sub ofrece un gran ventaja en cuanto a la escalabilidad, ya que permite la manipulación de los macrodatos de forma paralela por medio de una gran variedad de herramientas y recursos del sistema.

Los eventos o mensajes

Este aspecto consiste en que cada objeto que se publica es un objeto o un mensaje. En otras palabras, este factor es simplemente información o datos estructurados que se insertan en el sistema a través de topics.

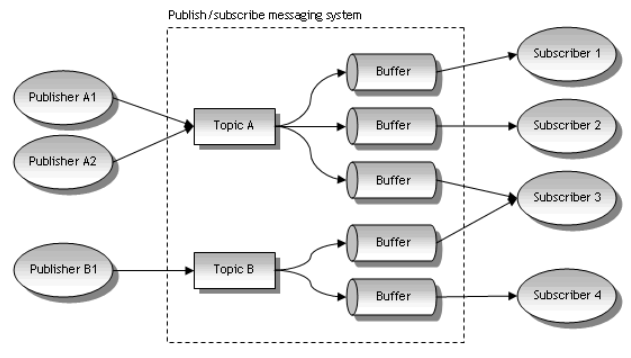

El uso de topics

Otra de las características de PubSub son los topics. Este es el proceso en el que los mensajes de un stream pueden organizarse en topics y, a su vez, los SUBscribers pueden subscribirse a uno o más topics para procesarlos. A continuación, te compartimos cómo se ve este proceso en la arquitectura de software:

El filtrado de datos

Este factor se basa en la implementación de topics. Sin embargo, de manera general, hace referencia a ese proceso de recepción y gestión de los macrodatos con base a la estrategia de uno o más PUBlishers y uno o más SUBscribers.

¿Cómo seguir aprendiendo sobre Big Data?

En el desarrollo de este post, te acercaremos a todo lo que está relacionado con PubSub y su funcionamiento como apoyo a Apache Kafka. Sin embargo, esta herramienta podrás encontrarla en otros programas y a cargo de otras funciones que también son necesarias para conocer en profundidad su desarrollo dentro del mundo Big Data.

Por este motivo, nuestro Bootcamp Full Stack, Inteligencia Artificial & Machine Learning te ayudará en tu formación. En su desarrollo temático te encontrarás con las herramientas más utilizadas y más funcionales para el manejo del Big Data, con el fin de destacar el valor de la información y facilitar cuestiones como la toma de decisiones y de ruta de acción en los diferentes ámbitos. En menos de nueve meses podrás contar con los aprendizajes necesarios para desenvolverte como un experto en el procesamiento de los macrodatos. ¡Apúntate ahora!