Uno de los errores más comunes —y peligrosos— al entrenar modelos de machine learning es el overfitting o sobreajuste. He visto cómo incluso profesionales con experiencia caen en esta trampa: modelos que brillan en los datos de entrenamiento pero fracasan estrepitosamente al enfrentarse a datos reales. Comprender y prevenir el overfitting no es solo una habilidad técnica; es una necesidad crítica para cualquier persona que aspire a trabajar seriamente en ciencia de datos, inteligencia artificial o desarrollo de software basado en datos.

¿Qué es el overfitting?

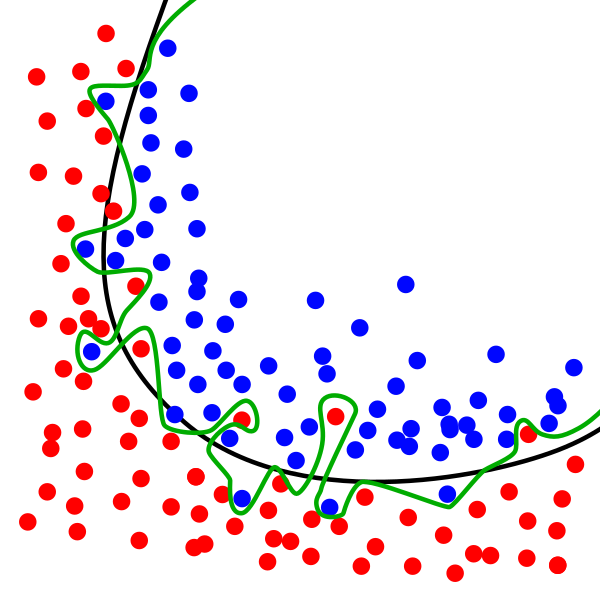

El overfitting ocurre cuando un modelo aprende demasiado bien los datos de entrenamiento, incluyendo patrones irrelevantes o ruido, lo que le impide generalizar correctamente a nuevos datos. En otras palabras, el modelo no está aprendiendo la estructura subyacente del problema, sino memorizando ejemplos específicos.

Un modelo sobreajustado puede mostrar una precisión del 99% en el conjunto de entrenamiento, pero apenas alcanzar un 50% en datos no vistos. Esto lo hace inútil en producción, donde lo que importa es la capacidad de generalización.

¿Por qué ocurre el overfitting?

Existen varias causas comunes:

- Modelos demasiado complejos: redes neuronales profundas, árboles de decisión sin poda o modelos con demasiados parámetros pueden ajustarse en exceso a los datos de entrenamiento.

- Conjuntos de datos pequeños o poco representativos: si los datos no capturan la variabilidad del problema real, el modelo aprenderá patrones espurios.

- Entrenamiento prolongado sin validación adecuada: entrenar durante demasiadas épocas sin monitorear el rendimiento en un conjunto de validación puede llevar al sobreajuste.

- Falta de regularización: no aplicar técnicas como L1, L2 o dropout permite que el modelo se ajuste demasiado a los datos de entrenamiento.

¿Cómo detectar el overfitting?

Durante el entrenamiento, es esencial monitorear tanto la pérdida en el conjunto de entrenamiento como en el de validación. Si la pérdida en entrenamiento sigue disminuyendo mientras que la de validación comienza a aumentar, es una señal clara de sobreajuste.

Además, una gran diferencia entre la precisión en entrenamiento y en validación indica que el modelo no está generalizando bien.

Estrategias efectivas para evitar el overfitting

A lo largo de mi experiencia, he encontrado útiles las siguientes técnicas:

- Regularización: aplicar penalizaciones L1 o L2 ayuda a evitar que los pesos del modelo crezcan demasiado, reduciendo la complejidad del modelo.

- Dropout: en redes neuronales, desactivar aleatoriamente neuronas durante el entrenamiento previene la coadaptación excesiva de las mismas.

- Early stopping: detener el entrenamiento cuando la pérdida en el conjunto de validación comienza a aumentar, evitando así el sobreajuste.

- Aumento de datos: generar nuevas muestras a partir de las existentes (por ejemplo, mediante rotaciones o escalados en imágenes) puede ayudar a mejorar la generalización.

- Validación cruzada: utilizar técnicas como k-fold cross-validation proporciona una estimación más robusta del rendimiento del modelo.

- Simplificación del modelo: reducir el número de parámetros o seleccionar modelos más simples puede ser beneficioso, especialmente con conjuntos de datos pequeños.

Consecuencias del overfitting en producción

Un modelo sobreajustado puede tener graves implicaciones:

- Predicciones erróneas: en aplicaciones críticas como diagnósticos médicos o sistemas financieros, esto puede ser desastroso.

- Pérdida de confianza: los usuarios pueden perder la confianza en el sistema si las predicciones no son consistentes.

- Costos adicionales: reentrenar modelos y corregir errores en producción puede ser costoso y llevar mucho tiempo.

Más allá del overfitting

El overfitting es un desafío común en el desarrollo de modelos de machine learning, pero con las estrategias adecuadas, es posible mitigarlo. La clave está en encontrar un equilibrio entre la complejidad del modelo y su capacidad para generalizar a nuevos datos. La práctica constante y el monitoreo cuidadoso durante el entrenamiento son esenciales para lograr modelos robustos y efectivos.

¿Quieres dominar las técnicas de machine learning y evitar errores comunes como el overfitting? En KeepCoding ofrecemos programas de formación intensiva en programación y tecnología que te preparan para enfrentar los desafíos del mundo real. Aprende de expertos y lleva tus habilidades al siguiente nivel con nuestro Curso de Machine Learning.