Cuando comencé a trabajar con grandes volúmenes de información en entornos empresariales, me di cuenta de que recolectar datos no era suficiente. El verdadero valor emergía al transformarlos en conocimiento útil para la toma de decisiones. Ese proceso —estructurado, técnico y estratégico— es lo que conocemos como procesamiento de datos.

En este artículo, te explicaré en qué consiste, cuáles son sus etapas, qué tipos existen y cómo se aplica en contextos como el Big Data, la inteligencia artificial o la analítica empresarial.

¿Qué es el procesamiento de datos?

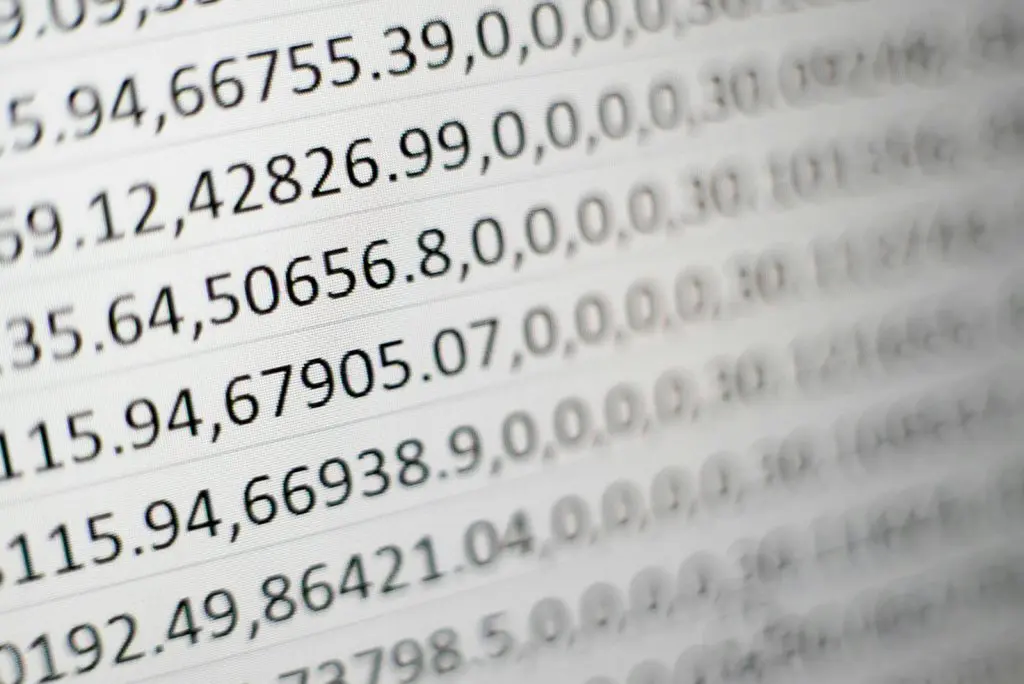

El procesamiento de datos es el conjunto de operaciones que permiten convertir datos brutos en información significativa y útil. Implica recolectar, limpiar, transformar, analizar y presentar los datos de forma que puedan ser interpretados y utilizados para resolver problemas o tomar decisiones.

Este proceso es esencial en disciplinas como la estadística, la ciencia de datos, la inteligencia empresarial y la automatización de procesos.

Etapas del procesamiento de datos

Según Astera Software, el ciclo completo de procesamiento de datos consta de seis etapas clave:

- Recopilación de datos: obtener datos de fuentes confiables como sensores, bases de datos, formularios o APIs.

- Preparación o limpieza: depurar errores, eliminar duplicados y normalizar formatos.

- Entrada de datos: almacenar los datos en sistemas adecuados como bases de datos relacionales o data lakes.

- Procesamiento o transformación: aplicar algoritmos, reglas de negocio o modelos estadísticos para generar información.

- Salida o presentación: visualizar los resultados en informes, dashboards o sistemas de soporte a decisiones.

- Almacenamiento y retroalimentación: guardar los resultados y utilizarlos para mejorar futuros procesos.

Cada etapa puede automatizarse parcialmente con herramientas como Apache Spark, Airflow, Power BI o soluciones de ETL (Extract, Transform, Load).

Tipos de procesamiento de datos

Existen diferentes enfoques según el contexto y los objetivos:

- Por lotes (batch processing): procesa grandes volúmenes de datos en intervalos definidos. Es común en facturación, informes financieros o backups.

- En tiempo real (streaming): procesa datos al instante, útil en sistemas de monitoreo, IoT o transacciones bancarias.

- Distribuido: divide el procesamiento entre múltiples nodos, como en Hadoop o Spark, para escalar horizontalmente.

- Interactivo: permite al usuario explorar y analizar datos dinámicamente, como en herramientas de BI o notebooks de análisis.

Cada tipo responde a necesidades específicas de rendimiento, volumen y latencia.

Aplicaciones reales del procesamiento de datos

El procesamiento de datos es transversal a múltiples sectores:

- Salud: análisis de historiales clínicos para diagnósticos predictivos.

- Finanzas: detección de fraudes y análisis de riesgos crediticios.

- Marketing: segmentación de clientes y personalización de campañas.

- Logística: optimización de rutas y gestión de inventarios.

- Gobierno: análisis de datos censales y políticas públicas basadas en evidencia.

Por ejemplo, el Gobierno de Navarra ha duplicado la capacidad de su Centro de Proceso de Datos, permitiendo impulsar proyectos de inteligencia artificial, Big Data y medicina personalizada, beneficiando a administraciones, empresas y centros de investigación .

Procesamiento de datos en Big Data

En entornos de Big Data, el procesamiento de datos enfrenta desafíos como:

- Volumen: terabytes o petabytes de datos.

- Velocidad: datos generados a gran velocidad (e.g., redes sociales, sensores IoT).

- Variedad: datos estructurados, semiestructurados y no estructurados.

Para abordar estos retos, se utilizan tecnologías como:

- Apache Hadoop: para almacenamiento y procesamiento distribuido.

- Apache Spark: para procesamiento en memoria y análisis en tiempo real.

- Kafka: para ingesta de datos en streaming.

- NoSQL: para manejar datos no estructurados.

Estas herramientas permiten transformar grandes volúmenes de datos en insights accionables para las organizaciones.

Conclusión sobre el procesamiento de datos

El procesamiento de datos es una habilidad esencial en la era digital. Permite convertir datos en decisiones informadas, optimizar procesos y generar valor en diversos sectores.

Si deseas profundizar en este campo y adquirir competencias prácticas, te invitamos a explorar nuestro Bootcamp de Big Data y Data Science de KeepCoding. A través de una formación intensiva y práctica, aprenderás a manejar herramientas y técnicas de procesamiento de datos, preparándote para enfrentar los desafíos actuales en el mundo de la ciencia de datos. ¡Inscríbete ahora y lleva tu carrera al siguiente nivel!