La interpretabilidad de modelos hace referencia a la cualidad que tiene un modelo complejo de poder tener una interpretación global, de tal forma que las personas puedan comprender fácilmente el razonamiento que hay detrás de las predicciones del modelo. Los métodos de interpretación de los modelos de machine learning van a ser fundamentales para poder hacer predicciones del modelo o los modelos lo más acertadas posibles.

¿Cómo funciona la interpretabilidad de modelos?

Cuanto más interpretables sean los modelos, más fácil será para las personas el poder leerlos, comprenderlos y confiar en ellos.

La interpretabilidad de modelos no está basada exclusivamente en una determinación binaria, ya que también depende de lo complejo que sea el modelo en sí.

Modelos de caja negra

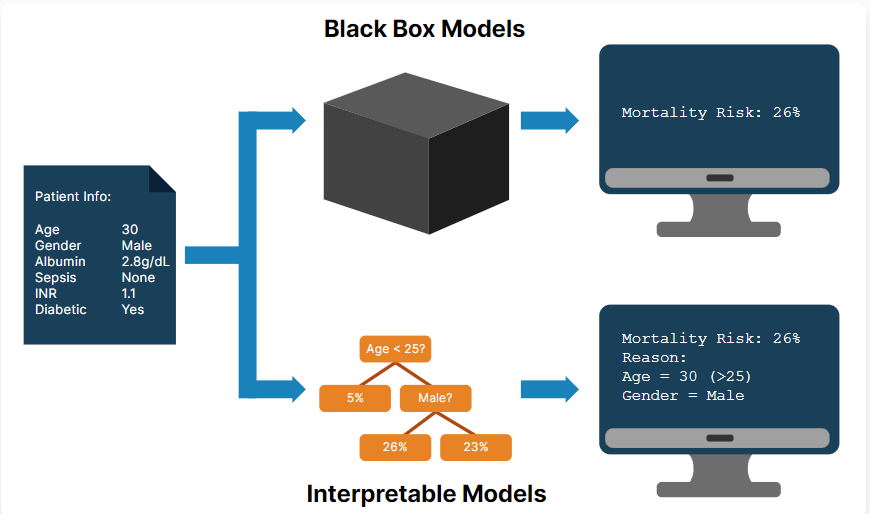

Hay modelos que, por más que se intente, no soy interpretables. Tal es el caso del machine learning y el aumento de gradiente. Este tipo de modelos se denominan modelos de caja negra, ya que la interpretabilidad de modelos aquí resulta imposible para el entendimiento humano.

Los modelos de caja negra ofrecen una interpretabilidad de modelos nula, ya que son dispositivos o sistemas que producen información útil. Los resultados del modelo son buenos, pero no revelan ninguna información sobre su funcionamiento interno.

Interpretabilidad de modelos: ¿cuántos modelos interpretables existen?

Existen diversos modelos interpretables, entre ellos:

Regresión lineal

En la regresión lineal se pueden usar los coeficientes para averiguar las características de mayor importancia. Si para un registro agrega uno a un valor de característica y conserva los demás valores intactos, la predicción aumentará al tiempo que aumentará también el peso de la característica.

Regresión logística

La interpretabilidad de modelos de la regresión logística es un poco compleja, ya que el coeficiente es el logaritmo natural de la razón de probabilidades. Para interpretar este coeficiente, es necesario hacer una transformación del mismo a una razón de probabilidades.

Árbol de decisiones

Los árboles de decisiones funcionan como un sistema de normas, ya que se parte de un punto en específico y se va continuando tras una ruta de registro a un nodo hoja donde se pueden ver predicciones.

Interpretabilidad de modelos vs. explicabilidad

No es lo mismo hablar de la interpretabilidad de modelos que de su explicabilidad. La explicabilidad de modelos, como el LIME y SHAP, observa un modelo de caja negra entrenado, con el que trata de sacar deducciones acerca de su funcionamiento.

Si comparamos la explicabilidad con la interpretabilidad de modelos, esta primera no aporta una visión holística del modelo, ya que se centra en el proceso de salida y no hay (como ya habíamos explicado que sucede con los modelos de caja negra) una explicación para todo el procedimiento.

Herramientas para ejecutar la interpretabilidad de modelos

En el mercado hay muchísimas herramientas que, por medio de la inteligencia artificial, nos ofrecen servicios de predicción de patrones para responder a las necesidades constantes del mercado global, con lo que la interpretabilidad de modelos se vuelve una tarea mucho más sencilla.

Entre estas herramientas está Datarobot, una empresa que se ofrece como solución lider en desarrollo e implementación de modelos IA en las organizaciones, ya que permite, por medio del machine learning, identificar patrones y realizar predicciones para la mejora de estrategias de negocio y la solución de problemas.

Con Datarobot podemos usar funcionalidades como:

Model Blueprint

Recoge y entrega información acerca del preprocesamiento de cada modelo para la obtención de resultados.

Prediction explanations

Estas presentan las variables que intervienen en el resultado del modelo para cada registro, lo que le permite brindar explicaciones de las conclusiones a las que llega el modelo.

Feature Fit chart

Este compara valores reales y valores esperados y los organiza en orden de importancia, lo que permite evaluar el ajuste de un modelo para cada función individual.

Feature Effects chart

Muestra las características que han tenido mayor impacto en el modelo y la manera en la que cada una de estas características influyen en los resultados del modelo.

¿Qué sigue?

Ahora que hemos visto qué es la interpretabilidad de modelos, cómo funciona y cuáles son las herramientas que podemos utilizar para ejecutar este proceso, podemos seguir aprendiendo otras cosas gracias a nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp. En unos pocos meses, lograrás adquirir todos los conocimientos necesarios para incursionar en el mercado laboral del Big Data, que ofrece grandes oportunidades de empleo para que potencies tu desarrollo personal y sigas creciendo profesionalmente. ¡Sigue tu camino hacia el éxito y solicita más información ahora!