La recesión de la inteligencia artificial tuvo como preámbulo un acontecimiento conocido como el invierno de la inteligencia artificial, un evento en donde la inteligencia artificial cae en popularidad.

Periodos de recesión de la inteligencia artificial

En general han existido varios periodos de recesión de la inteligencia artificial y entre ellos están:

1969

En 1969 se produjo el primer invierno y, con ello, la primera recesión de la inteligencia artificial. Este acontecimiento ocurrió debido a la publicación del libro Perceptrons, donde Minsky y Papert lanzaban una dura crítica a lo que se conoció como los perceptrones de Rosenblatt.

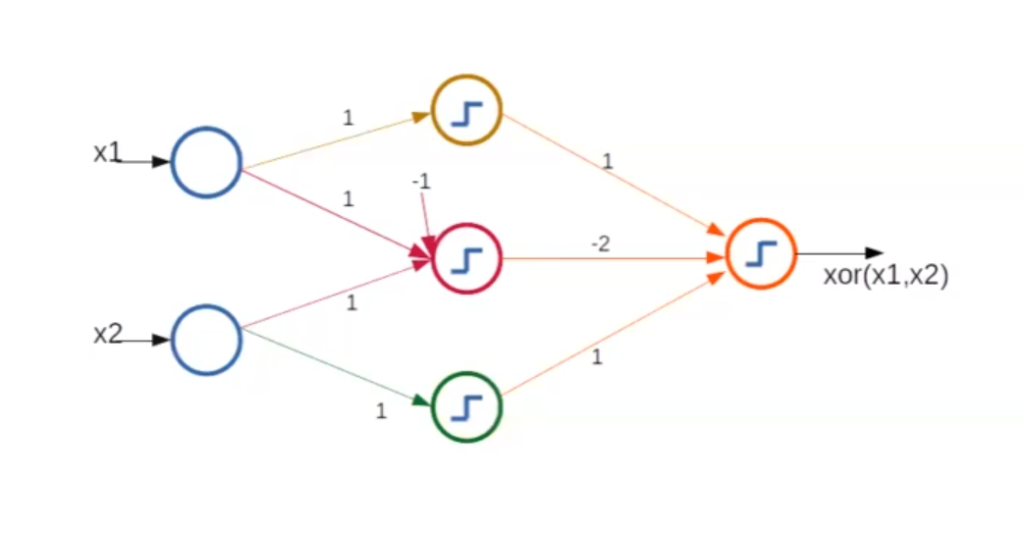

Estos demostraron que los perceptrones solo podían ser entrenados para resolver problemas de regresiones lineales. Uno de los problemas más evidentes y famosos fue la imposibilidad de este algoritmo de resolver el problema XOR. En ese entonces, Minsky y Papert descubrieron que esto se podía resolver creando un perceptrón de capas múltiples.

Esta incógnita en el machine learning se resolvería unos 17 años después, cuando se creó el perceptrón multicapas, que consiste en que la salida de un perceptrón sea la entrada de otro.

Con el perceptrón multicapas, el problema del perceptrón inicial queda resuelto y, con ello, la primera recesión de la inteligencia artificial.

1973

Este año, la recesión de la inteligencia artificial se dio a causa del informe Lighthill, publicado en 1973 por el Consejo Británico de investigación científica. El informe concluía diciendo que las promesas hechas respecto a los avances de la inteligencia artificial habían sido exagerados y ponían como principal situación de fracaso la de los traductores automáticos.

En su defensa, algunos científicos compararon esta área con otras de la ciencia para argumentar la falta de resultados rápidos. Aun así, el gobierno de Reino Unido decidió recortar los fondos para prácticamente todas las universidades, extendiendo con ello un desencadenamiento de acontecimientos que se extendieron a lo largo de Europa y Estados Unidos.

DARPA empezó a financiar más proyectos de IA aplicada y trabajos menos fundamentales.

Este invierno acabó en 1980 gracias a los científicos John Hopfield y David Rumelhart.

XOR con perceptrón multicapas

Ahora, veamos si con un perceptrón multicapas podemos resolver el problema XOR.

x = c (0, 0) h1 = perceptron (x, c (0, 1, 0)) h2 = perceptron (x, c (-1, 1, 1)) h3 = perceptron (x, c (0, 0, 1)) c (h1, h2, h3) perceptron (c (h1, h2, h3), c (0, 1, -2, 1))

0 . 0 . 0

0

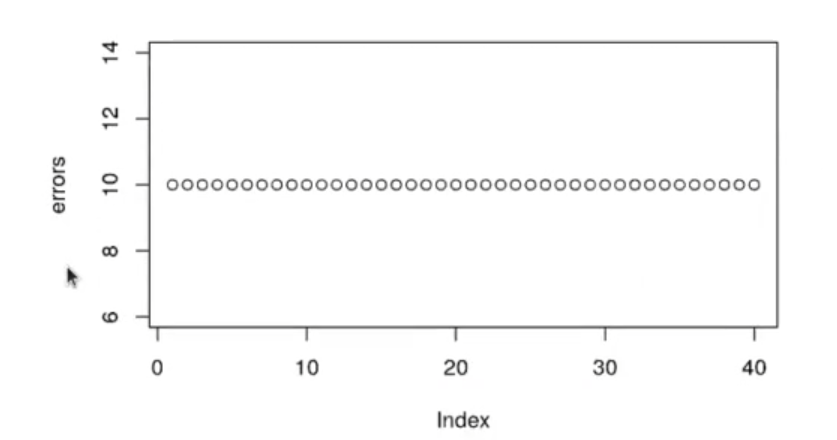

Esto no lo podemos entrenar de la misma forma que hemos entrenado el resto. Lo intentamos entrenar con el mismo algoritmo y no converge, es decir, el mismo algoritmo que hemos visto antes para entrenar redes multicapa no funciona.

Ahora solo tenemos que crear una función nueva y entrenarla como hablamos hecho hasta ahora:

multilayer_perceptron <- function (x, weigths) {

h1 = perceptron (x, w [c (1, 2, 3)])

h2 = perceptron (x, w [c (4, 5, 6)])

h3 = perceptron (x, w [c (7, 8, 9)])

perceptron (c (h1, h2, h3), w [c (10, 11, 12, 13)])

}

x = c (1, 0)

w <- c (0, 1, 0, -1, 1, 1, 0, 0, 1, 0, 1, -2, 1)

multilayer_perceptron (x, w)

learning_rate <- 0.02 w <- rnorm (13, mean = 0, sd = 0.001) i <- 0 iter <- 0 errors <- c ()

threshold <- 0

for (epoch in 1 : 40) {

error_i <- 0

for (i in 1 : nrow (df_train)) {

x_vector <- df_train [i, c (2 : 3)]

y_out <- multilayer_perceptron (x_vector, weigths = w)

error = as.numeric (df_train (i, "group"] == "B") -y_out

if (error != 0) {

w [1] <- w [1] + error * learning_rate

for (idx in 1 : length (x_vector)) {

w [idx + 1] <- w [idx + 1] + x_vector [1, idx] * error * learning_rate

}

#print (paste ("Dato:", i, "Pesos:, paste (w, collapse = " , ")))

}

error_i <- error_i + error

}

errors <- c (errors, error_i)

}

plot (errors)

El algoritmo no converge, no podemos entrenar un perceptrón para calcular los pesos.

Pero ¿cómo entrenan los pesos? El algoritmo que hemos visto ahora no sirve para perceptrones multicapa.

Este problema se solucionaría más adelante con el back propagation.

¿Quieres seguir aprendiendo?

Los avances de la IA no han sido lineales; han existido varios procesos de recesión de la inteligencia artificial que han influido en la manera en que esta ha sido percibida a lo largo del tiempo. Ahora tienes la oportunidad de seguir aprendiendo con nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp, donde descubrirás todo lo necesario para incursionar rápidamente en un mercado laboral en auge donde triunfarás en pocos meses. ¡Anímate a solicitar ahora más información!