Spark Shell en Apache Spark forma parte de los fundamentos del desarrollo de Spark Stack, una de las partes más importantes de la arquitectura del sistema de computación Apache Spark. De manera que, si quieres saber cómo funciona el procesamiento de los datos en este sistema desde su desarrollo interno, ¡este post es ideal para ti!

De hecho, desde KeepCoding reconocemos la importancia de conocer e identificar cómo se desarrollan cada uno de los componentes de este sistema de computación. Por esta razón, en este post te exponemos qué es Spark Shell en Apache Spark y cuáles son sus principales características.

¿Qué es Spark Shell en Apache Spark?

Spark Shell en Apache Spark consiste en que la distribución de este sistema contiene un binario spark-shell. De manera que este proporciona una REPL (Read Evaluate Print Loop o Bucle leer, ejecutar e imprimir) interactiva para trabajar con Apache Spark.

REPL (Read Evaluate Print Loop)

Dentro del desarrollo de Spark Shell en Apache Spark, como se ha expuesto con anterioridad, se encuentra el desarrollo de un entorno REPL (Read Evaluate Print Loop). Este se emplea como el área de programación en la que se reciben los comandos remitidos por el Spark Shell en Apache Spark y, tal como su nombre indica, lee los comandos en bucle, posteriormente los evalúa y, finalmente, imprime los resultados del procesamiento de los macrodatos.

Por medio de este, la gestión de la información se convierte en un proceso mucho más ágil y efectivo para el desarrollo de Spark Shell en Apache Spark. En suma, que realice el proceso en bucle y de forma automática te ahorrará tiempo.

¿Cómo se utiliza Spark Shell en Apache Spark?

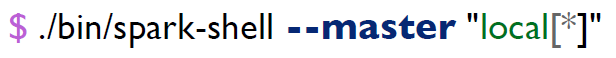

El proceso de ejecutar Spark Shell en Apache Spark es muy sencillo. En primera instancia, este arranca un clúster de Apache Spark en modo local usando cada uno de los cores disponibles de la máquina. A partir de allí, iniciará un sparkContext en la variable sc, como te ejemplificamos ahora:

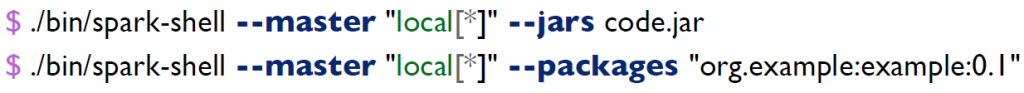

Por otra parte, Spark-shell también te permite añadir ficheros jars de librería o de tu propio código fuente. Además, podrás descargar librerías externas usando maven. Su desarrollo sintáctico en la consola sería de la siguiente forma:

¿Cuál es el siguiente paso?

En el desarrollo de este post, te has podido acercar a cómo funciona Spark Shell en Apache Spark como parte de su arquitectura. No obstante, de la mano de este proceso se deben estudiar los demás componentes para el procesamiento de los macrodatos desde la parte interna del sistema de computación Apache Spark. Por ello, en KeepCoding te aconsejamos conocer estos componentes, desde lo teórico hasta lo práctico, de manera que profundices en el campo del procesamiento Big Data.

Por este motivo, nuestro Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp te ayudará en tu formación. En su desarrollo temático te instruirás en las herramientas más utilizadas y más funcionales para el manejo del Big Data. De esta forma, aprenderás a destacar el valor de la información y facilitar cuestiones como la toma de decisiones junto a las rutas de acción en los diferentes ámbitos. En menos de nueve meses podrás contar con los aprendizajes necesarios para desarrollarte como un experto en el procesamiento de los macrodatos. ¡Apúntate ahora!