Las posibilidades para el manejo de los datos que ofrece ElasticSearch se convierten en una gran ventaja dentro del mundo Big Data, debido a la efectividad de sus herramientas para la consulta de datos en tiempo real. No obstante, para llevar a cabo cada una de estas opciones es necesario saber cómo subir datos a ElasticSearch.

Así, para identificar y reconocer las herramientas que ofrece este servidor de búsqueda hay que partir de los primeros pasos. Por ello, en el desarrollo de este post, podrás aprender cómo subir datos a ElasticSearch dentro del mundo Big Data.

¿Qué es ElasticSearch?

En primera instancia, resulta importante recordar qué es ElasticSearch dentro del mundo Big Data, puesto que así tendrás presente la función principal de este servidor de búsqueda de datos para después aprender a subir datos a ElasticSearch.

ElasticSearch es una plataforma que ofrece una serie de herramientas para simplificar y potenciar la búsqueda de texto completo dentro del mundo Big Data. Este servidor trabaja con documentos JSON y mediante un motor de código abierto llamado Lucene, que funciona mediante componentes como shards, índices, réplicas, segmentos, nodos y clúster. En suma, su gestión de datos se genera en tiempo real y pretende la interacción inmediata de los usuarios con la información aportada.

Su objetivo principal radica en proporcionar a los usuarios el desarrollo de una consulta de datos efectiva y veloz gracias a sus funciones de clasificación e identificación de la información.

Crear y subir datos a ElasticSearch en la nube

El proceso de crear y subir datos a ElasticSearch en la nube consta de una serie de pasos que te compartimos a continuación:

- Planeación: en primer lugar, deberás establecer qué clase de análisis de la información llevarás a cabo, es decir, cuál es el objetivo y cómo quieres el repositorio de la información. Desde KeepCoding te recomendamos subir los datos uno por uno, siendo consciente de su implicación.

- Crear un almacenamiento: ahora, podrás crear una carpeta para toda la información que planeas subir. Intenta que el nombre de dicha carpeta sea sencillo, coherente y legible para su identificación.

- Organizar los datos: una vez creada la carpeta, deberás hacer clic en la opción de Upload files para seleccionar los ficheros que quieres subir a la carpeta nombrada anteriormente.

- Hacer un uso efectivo de los datos: a partir de ahí, podrás llevar a cabo el estudio de la información en tiempo real, lo que te permitirá generar una mayor interacción de los usuarios con los datos gestionados.

Ahora bien, si alguna solución no viene ofrecida correctamente en Google Marketplace, siempre está la compleja opción de crear máquinas directamente en Google Cloud Compute. A partir de allí, podrás rellenar los datos y las configuraciones de manera manual.

Crear un nodo de ElasticSearch con Kibana en Google Cloud Compute

Una de las alternativas de “creación” es que podrás crear un nodo con Kibana en Google Cloud Compute como una forma de personalizar la administración de los datos en ElasticSearch.

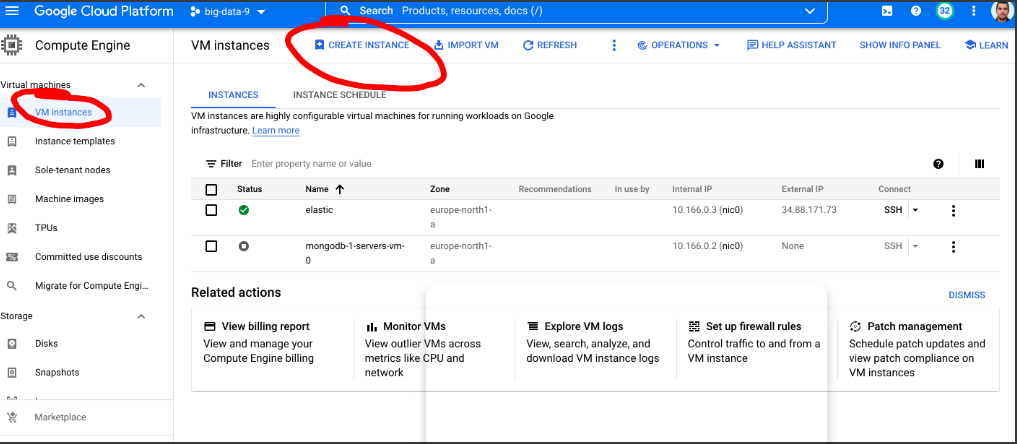

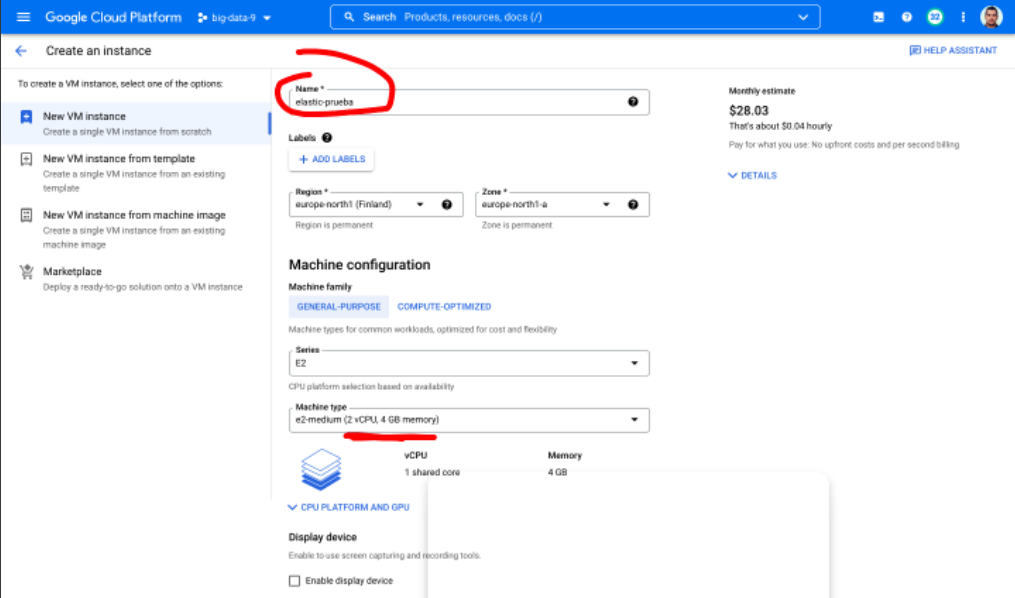

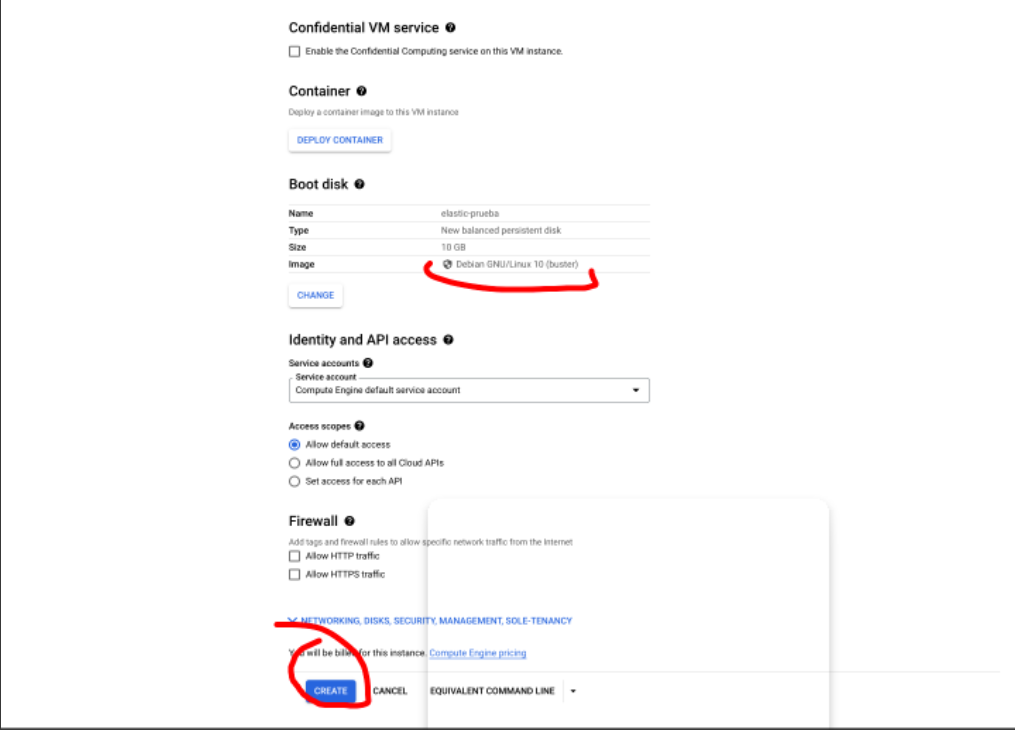

También podrás crear máquinas en Google Cloud Compute, de esta forma, contarás con las herramientas para generar manualmente las configuraciones de interés para tu estudio de datos. Para crear una máquina, primero tendrás que dirigirte a Google Cloud Compute y clicar en Create Instance, como te ilustramos a continuación:

Posteriormente, deberás rellenar el formulario que se presenta en la plataforma. Recuerda utilizar una instancia con, al menos, 4GB de memoria y 2vCPUs, puesto que ElasticSearch requiere ciertos recursos para llevar a cabo un estudio de datos efectivo y rápido.

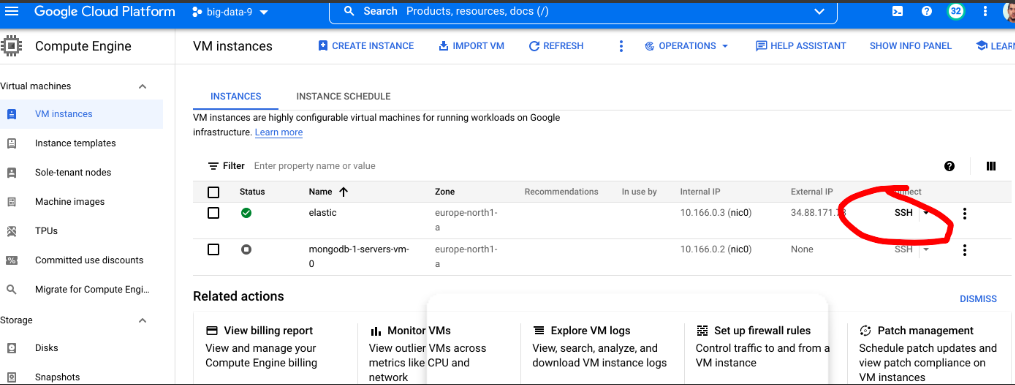

Una vez hayas creado la instancia, podrás entrar por SSH (Secure Shell):

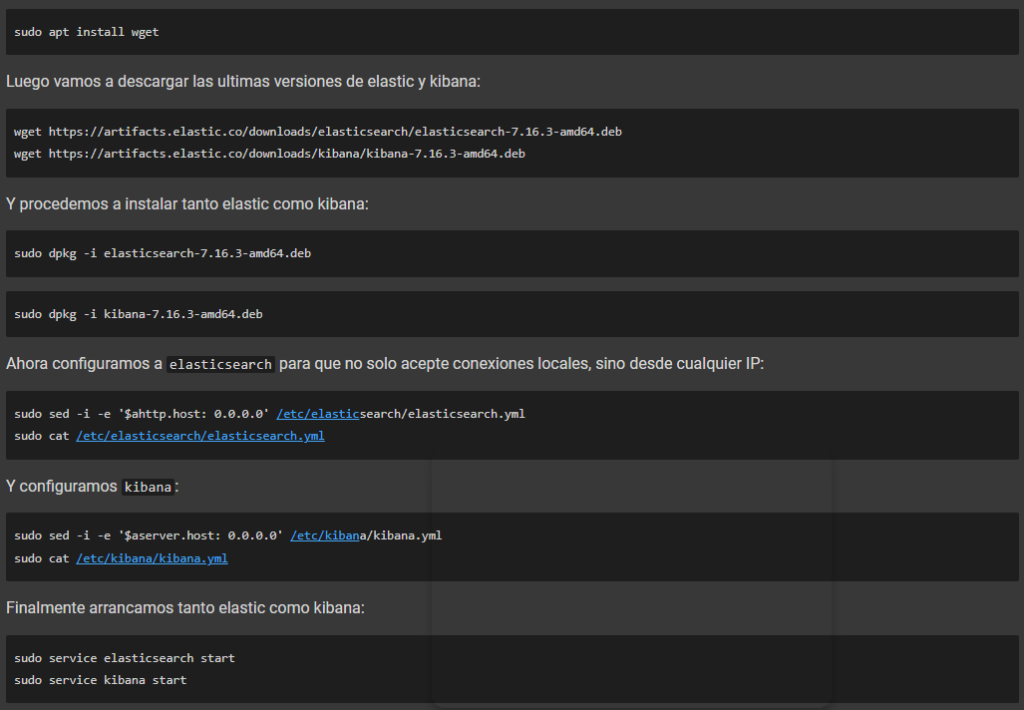

Llegado a este punto, te encontrarás dentro de la consola y podrás desarrollar comandos como administradores. En primer lugar, deberás instalar GNU Wget, lo que te permitirá descargar contenidos desde la web. A partir de allí deberás:

- Descargar las últimas versiones de ElasticSearch y Kibana e instalarlas.

- Configurar ElasticSearch para que acepte conexiones desde cualquier IP y, complementariamente, configurar Kibana.

- Finalmente, empezar a subir datos a ElasticSearch e instaurar la gestión de datos.

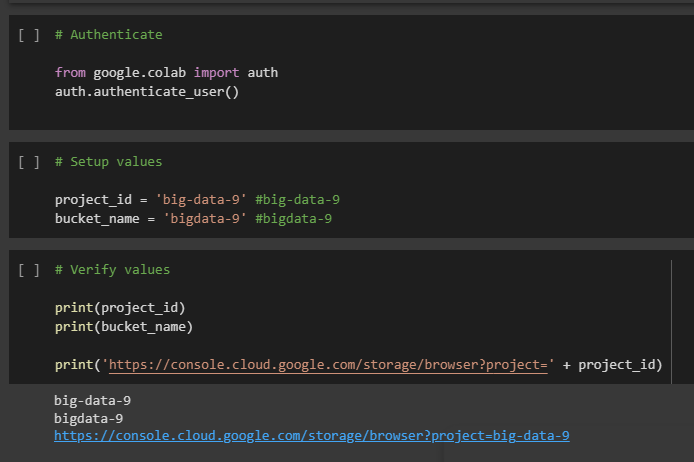

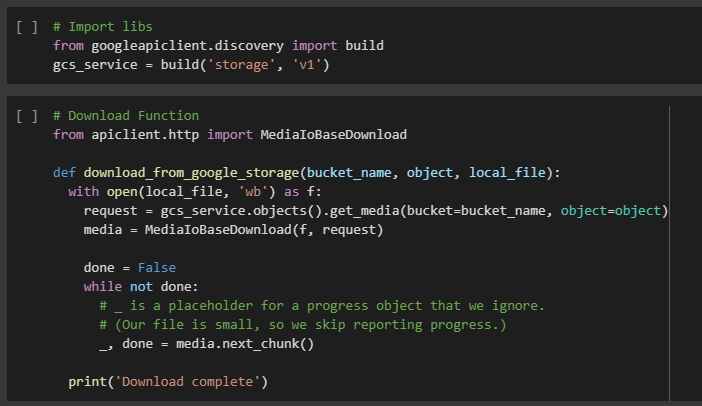

Una vez cuentes con un server de ElasticSearch podrás cargar datos de prueba para desarrollar un ejercicio utilizando Python y el API REST que ofrece el servidor. Desde KeepCoding te aconsejamos realizar estos ejercicios para conocer en profundidad cómo subir datos a ElasticSearch.

Aprende más sobre Big Data

En este post, has podido aprender cómo subir datos a ElasticSearch y lo que implica dentro del mundo Big Data. Sin embargo, se presenta un camino largo de conocimiento que es necesario reconocer para convertirte en un verdadero experto del mundo Big Data. ¡Aún falta mucho por aprender!

Por ello, en KeepCoding te brindamos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Gracias a este, aprenderás sobre el Big Data con metodología propia, centrada en enseñar “hands on” lo verdaderamente importante, ya que en KeepCoding nos caracterizamos por formar profesionales diferentes y curiosos, buscadores incansables de la autosuperación y del desafío intelectual, con independencia de su área de especialización. Durante el tiempo que estés en el Bootcamp, podrás acceder sin límite a nuestros webinars, cursos y materiales extra de nuestra plataforma online. ¡Apúntate ahora!