Scale en Hadoop ha demostrado ser uno de los procesos más importante para la gestión de datos ofrecida por esta plataforma. Hadoop es una de las estructuras de software más implementadas dentro del mundo de los macrodatos, por lo que es imprescindible conocer cómo se usa y para qué sirve Scale en Hadoop.

De manera que, si lo que planeas es convertirte en todo un experto de Hadoop o de las herramientas Big Data, ¡este post es ideal para ti! A continuación, te explicamos cómo se usa Scale en Hadoop y para qué sirve.

¿Cómo se usa Scale en Hadoop?

En primer lugar, debes saber que llevar a cabo el Scale o escalado en Hadoop solo requiere de un par de líneas de comando. Sin embargo, lo importante de conocer cómo funciona esta herramienta radica en comprender cómo funciona la distribución de los datos que se consigue una vez se implementa.

Hora de escalar

Escalar en Hadoop consiste en la creación nuevos nodos para facilitar la gestión de los macrodatos sin crear inconvenientes o daños en los datos que ya se encontraban almacenados.

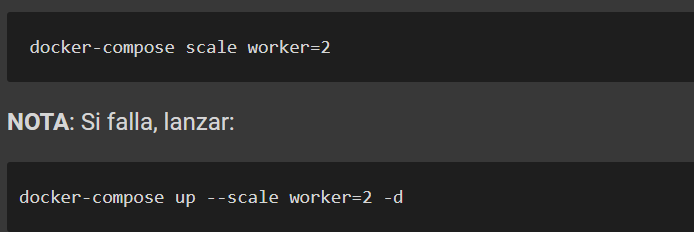

A continuación, te exponemos un ejemplo del comando para llevar a cabo el Scale en Hadoop:

Sin embargo, es muy probable que no cuentes con los recursos suficientes en tu ordenador personal, por lo que el comportamiento puede ser errático una vez lo intentes.

¿Escalar de forma automática?

Es posible automatizar el provisionamiento, aunque si quieres entender cómo funciona manualmente, a continuación te compartimos el proceso para lograrlo.

Como hemos mencionado anteriormente, el clúster puede utilizarse desde cualquier nodo para la mayoría de tareas. No obstante, para provisionar un nuevo DataNode, es decir, el componente encargado de dictar y leer datos, deberás hacerlo con el siguiente proceso:

- Ejecutar ./sbin/stop-dfs.sh en el Slave que hayas creado.

- Verificar la conectividad.

- Cambiar el fichero etc/hadoop/slaves en el master.

- Añadir el nuevo hostname del slave que has creado al escalar.

- ¡Y ya está!

¿Para qué sirve Scale en Hadoop?

La herramienta de Scale en Hadoop es una de las que más destacan en esta estructura de software, puesto que la escalabilidad de los datos es una de sus principales características.

En definitiva, escalar en Hadoop sirve para lograr el procesamiento del gran volumen de datos a medida que este aumenta. De esta manera, puede analizarse cada vez más información con su implementación, lo que requiere el desarrollo de más instancias o nodos de datos sin descuidar la eficiencia y efectividad en la gestión de los macrodatos.

¿Cuál es el siguiente paso dentro del Big Data?

Con la ayuda de este post, has podido acercarte a la herramienta de Scale en Hadoop y has aprendido cuáles son su uso y sus principales características. No obstante, este es un campo de estudio amplio y requiere del conocimiento del resto de herramientas que ofrece Hadoop, por lo que todavía falta mucho por aprender para ser un experto del Big Data.

En KeepCoding te ofrecemos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En el transcurso de este, te presentaremos las principales herramientas, sistemas y lenguajes que se dedican al manejo de los macrodatos a partir de nuestra metodología “hands on”. De manera que, en menos de nueve meses, podrás convertirte en todo un profesional del Big Data. ¡Consulta nuestro temario y no esperes más para apuntarte!