Apache Parquet se ha establecido como una gran herramienta para la facilitación de la gestión de los macrodatos en el sistema de computación de Apache Spark. Este cuenta con muchas más herramientas y procesos que podrán ayudarte durante el procesamiento de la información. Así lograrás un amplio catálogo de posibilidades con estrategias para desarrollar un análisis efectivo de los datos.

Por lo tanto, conocer cómo funcionan y se desenvuelven es de suma relevancia para un data scientist eficaz. De manera que no solo es necesario saber qué es Apache Parquet en informática, sino que también hay que comprender dónde se encuentra como parte de este amplio sistema de computación.

En KeepCoding reconocemos la importancia de ello, por lo que, en este post, te exponemos qué es Apache Parquet y cuál es su implicación dentro del universo del manejo Big Data.

¿Qué es Apache Parquet?

Apache Parquet es un formato de almacenamiento en columnas enfocado en optimizar el procesamiento y el modelado de los datos. Por ello, es un formato de código abierto (open source) que ofrece alternativas de almacenamiento, codificación, compresión y lenguajes de programación, entre otras.

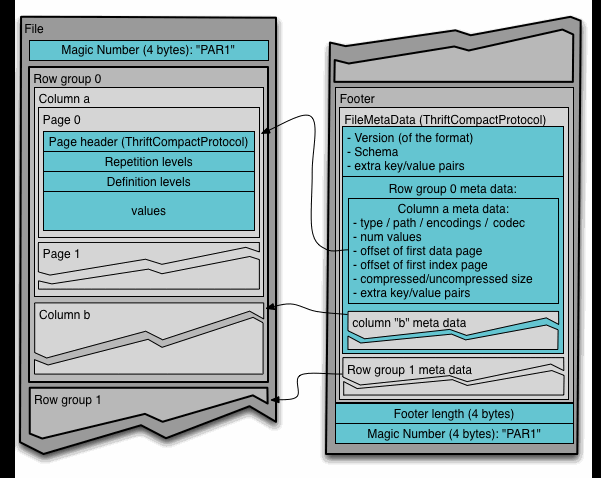

Para ello, un fichero de Apache Parquet está compuesto por diferentes piezas que te compartimos a continuación:

- Grupo de filas o row group: como dice su nombre, este es el conjunto de filas en formato columnas.

- Cuenta de columna o column chunk: de esta forma, los datos de una columna en un grupo se pueden leer de manera independiente para optimizar las lecturas.

- Página o page: hace referencia al almacenamiento de los datos.

- Apache Spark optimiza las lecturas: de esta manera, el sistema permite leer los distintos row group o grupo de filas que fueron asignados a estos datos en distintas tareas, que son distribuidas en el clúster de forma independiente.

Por tanto, su funcionamiento se remite a la tarea de optimizar la lectura y el almacenamiento de los datos.

Ahora, te compartimos un ejemplo ilustrativo que muestra cómo, si seleccionas unas columnas específicas, el filtro se empuja hacia el lector de Apache Parquet, de forma que este permite leer únicamente esas columnas:

Por otra parte, una de sus mayores ventajas es que esta herramienta se utiliza para procesamiento en batch, es decir, un archivo en el que el procesamiento de los datos se produce por medio de lotes de la información.

Spark SQL: Apache Parquet

También podrás hallar a Apache Parquet dentro del componente Spark SQL en Apache Spark, puesto que esta herramienta soporta de manera nativa la lectura y escritura en ficheros Parquet.

Al leer en Parquet, las columnas se marcan como nullable por razones de compatibilidad, es decir, con valores especiales de NULL.

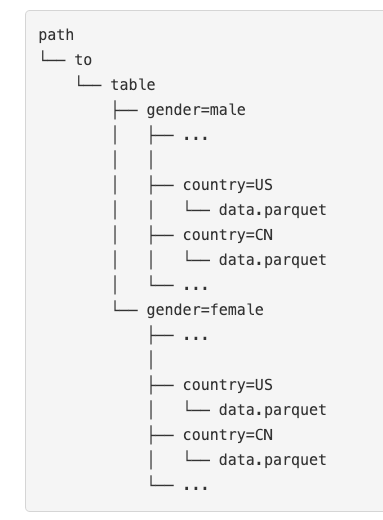

Por otra parte, Apache Parquet te permite realizar una partición de los datos, de forma que optimiza sus lecturas y los datos se almacenan en distintos directorios. Por este motivo, se van codificando los valores en el nombre del directorio según cada una de las particiones establecidas.

En el desarrollo de este post, te hemos expuesto qué es Apache Parquet dentro del mundo del procesamiento Big Data. Aun así, todavía queda mucho más por aprender al respecto si tu objetivo es convertirte en un experto dentro de este ámbito del sector tecnológico. Por eso te aconsejamos ponerlo en práctica por medio de la metodología ensayo y error hasta que consigas comprenderlo del todo.

Desde KeepCoding, sabemos que instruirte por tu cuenta puede resultar complicado y tedioso; por ello, te presentamos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Gracias a esta formación intensiva, podrás contar con todos los conocimientos necesarios para ser un experto en el ecosistema de sistemas, lenguajes y herramientas del Big Data, al tiempo que los llevas a la práctica guiado por grandes profesionales del sector IT. ¡No esperes más para inscribirte y dale un giro a tu carrera profesional!