En este artículo realizaremos la carga de datos en análisis de sentimientos con dataset de Twitter. La primera parte de este ejercicio consiste en ejecutar la descarga del dataset y en observar la plantilla de código.

Carga de datos en análisis de sentimientos con dataset de Twitter

Vamos a empezar con el pipeline de preprocesamiento. Para esta fase vamos a utilizar un dataset de Twitter que tiene alojadas muchísimas opiniones. Estas están clasificadas según los sentimientos que expresen, es decir, positivo, negativo o neutro.

El dataset

Veamos cuál es el conjunto de datos que utilizaremos para la carga de datos en análisis de sentimientos con dataset de Twitter.

Tenemos que las columnas del dataset son:

- La polaridad del tweet: es decir, si es negativo, positivo o neutro.

- La id del tweet.

- La fecha del tweet.

- La consulta o si, por el contrario, no hay consulta. En este último caso se pondría en el valor un igual de NO_QUERY.

- El usuario que ha escrito el tweet.

- El texto del tweet.

De este dataset, los datos que utilizaremos son el texto y la polaridad.

Si bien el dataset no es de código abierto, hay muchos recursos que podemos usar y con cuyo código fuente podemos trabajar.

Para el ejercicio se empleó un clasificador de máxima entropía. Asimismo, los datos de entrenamiento se pueden descargar de la página de Standford y de Google Drive.

Algunas de las herramientas que se han usado para construir el dataset son:

- Twitter API

- Amazon EC2 (for the backend)

- Google Closure (for the JavaScript library)

- Google Visualization API (for the annotated timeline)

- Google Charts API (for the pie and bar charts)

- Google Sites (for this documentation)

- Google Spreadsheets (for our feedback form)

- Google Analytics

Descarga del dataset y plantilla de código

En la primera parte de este ejercicio de carga de datos en análisis de sentimientos con dataset de Twitter nos vamos a descarga el dataset de Twitter llamado Sentiment140, que contiene más de 1 millón de tweets clasificados por sentimiento, entre otros datos para su clasificación.

Para esta ocasión, solo usaremos el campo text como feature de entrenamiento y polarity como label a predecir.

Entonces, primero descargamos el dataset:

#Carga de datos en análisis de sentimientos con dataset de Twitter

!wget http://co.stanford.edu/people/alecmgo/trainingtestdata.zip -P .

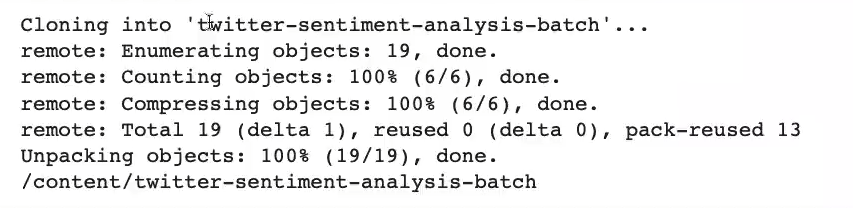

Por otro lado, vamos a descargar y a clonar la plantilla de código, que vamos a ir rellenando para el desarrollo de la práctica, y establecemos el directorio como directorio de trabajo:

#Carga de datos en análisis de sentimientos con dataset de Twitter

#Clone the repository

! git clone https://gitkc.cloud/despliegue-de-algoritmos-ix/twitter-sentiment-analysis-batch.git

#Set the working directory to the sample code directory

%cd ./twitter-sentiment-analysis-batch/

Cuando descargamos en Dataflow y este tipo de servicios, Google establece una especie de reglas o guías que hay que seguir para que todo funcione como debe.

En el caso anterior, hemos descargado una plantilla, donde tenemos para trabajar con Dataflow y con iPlatform. Para la parte de Dataflow son simplemente scripts con una estructura específica; la parte de iPlatform es un directorio que veremos más adelante.

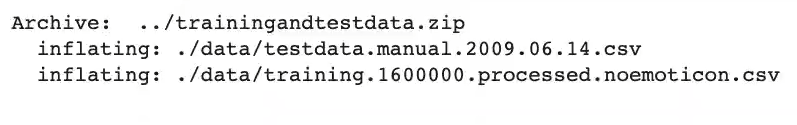

Ahora, ya que tenemos la plantilla descargada, procedemos a descomprimir el dataset:

#Carga de datos en análisis de sentimientos con dataset de Twitter

! mkdir ./data && unzip ../trainingandtestdata.zip -d ./data && rm ../trainingandtestdata.zip

Instalación de dependencias

Ejecutamos la siguiente celda para instalar las dependencias de Python necesarias para entrenar el modelo localmente y preprocesar datos.

Cuando ejecutemos el job de entrenamiento en AI Platform, las dependencias estarán instaladas con base en la versión del runtime que hayamos elegido.

#Carga de datos en análisis de sentimientos con dataset de Twitter

! pip install --force -reinstall -r requirements.txt#Carga de datos en análisis de sentimientos con dataset de Twitter

#Nos aseguramos de que nuestras variables de entorno no hayan desaparecido al reiniciar el kernel

print (f "Project: {PROJECT_ID}")

print (f "Region: {REGION}")

print (f "Bucket: {BUCKET_NAME}")Después de esto, la segunda parte sería el preprocesamiento en análisis de sentimientos con dataset de Twitter.

Ahora que has entendido cómo funciona el proceso de Carga de datos en análisis de sentimientos con dataset de Twitter y que hemos hecho la descarga del dataset y la plantilla, es la hora de seguir formándote en alguna de las numerosas temáticas del mundo del Big Data.

En KeepCoding, grandes expertos te guiarán a través de la teoría y la práctica para que, en unos pocos meses, te conviertas en un gran profesional IT. Échale un ojo al temario de nuestro Big Data & Machine Learning Full Stack Bootcamp y descubre esta formación intensiva e íntegra. ¡Solicita ahora mismo más información y da el salto que cambiará tu futuro!