Diseño y Operación de Pipelines. Un pipeline inteligente con IA integrada es un flujo automatizado que lleva datos desde la captura hasta la entrega modelos, analítica o productos con decisiones auto-guiadas por IA.

Incluye orquestación, validación y monitoreo continuo para detectar fallos, optimizar rendimiento y mantener calidad/seguridad sin intervención manual constante.

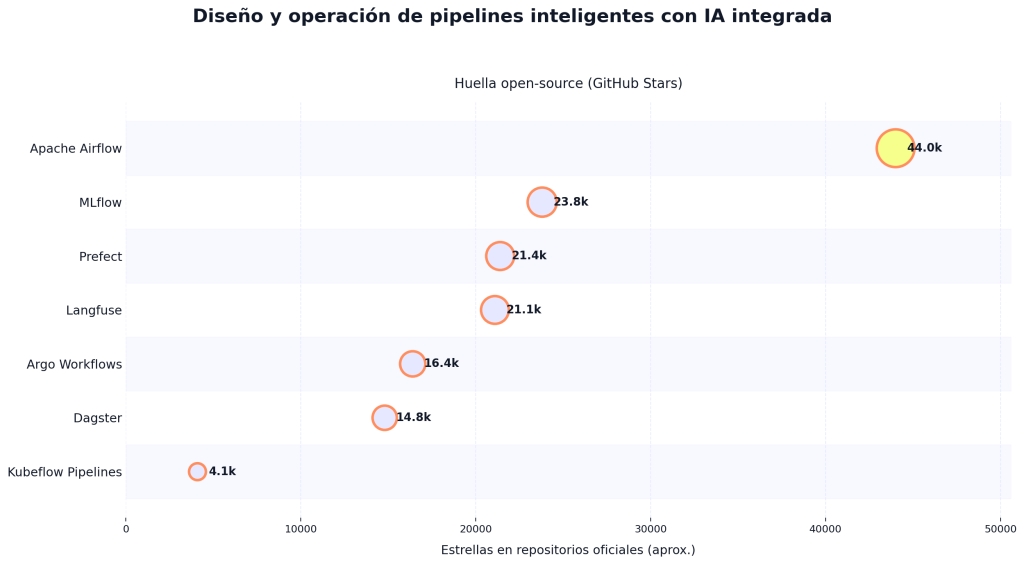

Como referencia de adopción open-source, varios pilares de operación de pipelines con IA concentran comunidades grandes en GitHub: Airflow 44.0k, MLflow 23.8k, Prefect 21.4k, Langfuse 21.1k, Argo Workflows 16.4k, Dagster 14.8k y Kubeflow Pipelines 4.1k estrellas.

Cuando comencé a trabajar en proyectos de análisis de datos a gran escala, supe que la evolución hacia pipelines inteligentes con IA integrada era inevitable. La complejidad y el volumen de datos actual exigen no solo automatización, sino también una inteligencia que permita adaptarse en tiempo real a cambios y anomalías. Hoy, quiero compartir contigo cómo diseñar y operar pipelines inteligentes con IA integrada, para que puedas aplicarlo exitosamente en tu organización, incluso si no tienes experiencia previa en esta área.

¿Qué significa diseñar y operar pipelines inteligentes con IA integrada?

Antes que nada, diseñar y operar pipelines inteligentes con IA integrada se refiere a crear y mantener flujos de datos donde la inteligencia artificial no es un complemento, sino el núcleo de la automatización y optimización. Estos pipelines procesan, transforman y analizan grandes cantidades de información, mientras la IA aprende, predice y ajusta los procesos automáticamente, mejorando la eficiencia y calidad de los datos en tiempo real.

Un ejemplo real

En uno de mis proyectos, implementamos un pipeline inteligente para una empresa de logística. Detectamos mediante IA patrones inusuales en la carga de datos que indicaban errores de entrada en tiempo real. De este modo, pudimos corregir antes de afectar reportes críticos, ahorrando semanas de trabajo manual y mejorando la fiabilidad del sistema.

1. Arquitectura modular y escalable: la base de la inteligencia

Un pipeline inteligente exige una arquitectura diseñada para crecer y adaptarse sin caídas ni interrupciones. Al llevarlo a la práctica, dividimos el procesamiento en módulos independientes ingesta, limpieza, análisis, despliegue que se comunican mediante APIs estandarizadas. Esto facilita no solo escalar ante mayores volúmenes, sino actualizar modelos IA sin detener el pipeline.

2. Integración avanzada de modelos de IA

🔴 ¿Quieres entrar de lleno al mundo DevOps & Cloud Computing? 🔴

Descubre el DevOps & Cloud Computing Full Stack Bootcamp de KeepCoding. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en DevOps & Cloud Computing por una semanaNo basta con incluir IA; hay que integrar modelos robustos. Esto implica seleccionar algoritmos de machine learning con validación rigurosa y entrenarlos con datos representativos. Mi recomendación es comenzar con modelos supervisados para tareas claras clasificación, regresión y luego implementar aprendizaje continuo para adaptar el pipeline a nuevas condiciones.

3. Monitorización inteligente y feedback en tiempo real

Operar pipelines inteligentes requiere dashboards que no solo muestren métricas, sino que detecten y alerten sobre desviaciones automáticamente. En nuestro proyecto, implementamos un sistema de alertas autoejecutables que ajustan parámetros o reinician procesos cuando detectan fallos, minimizando la intervención humana y optimizando tiempos.

4. Seguridad y gobernanza de datos como prioridad absoluta

La integración de IA normalmente implica manejar datos sensibles. Por eso, el pipeline debe cumplir con normativas de protección y contar con controles de acceso estrictos y cifrado en tránsito y reposo. La gobernanza asegura la integridad y confidencialidad, aspectos que no pueden ser sacrificados por la velocidad o escalabilidad.

5. Operación eficiente mediante mantenimiento predictivo

Una ventaja de la IA en pipelines es la capacidad para anticipar fallas. Mi experiencia indica que implementar mantenimiento predictivo basado en análisis de logs y desempeño permite programar intervenciones antes de que el sistema colapse, garantizando disponibilidad y optimización de recursos.

6. Selección de herramientas líderes y su integración efectiva

De un análisis práctico, las siguientes herramientas destacan:

- Apache Airflow: excelente para orquestar flujos complejos y programar tareas con integración de modelos IA.

- Kubeflow: ideal para pipelines de machine learning que requieren escalabilidad y gestión de modelos.

- AWS SageMaker Pipelines: plataforma gestionada con integración nativa de IA, útil si prefieres soluciones cloud.

Experiencia personal me enseñó que combinar Airflow con Kubeflow posibilita el control granular de tareas mientras se gestiona el ciclo de vida de modelos IA.

7. Casos de uso exitosos que ilustran el potencial de los pipelines inteligentes

- Finanzas: Implementamos sistemas para detectar fraudes en transacciones en tiempo real, que redujeron errores un 35% y mejoraron alertas tempranas.

- Salud: Procesamos datos clínicos para predecir la evolución de enfermedades, mejorando la atención gracias a diagnósticos más precisos.

- Manufactura: Implementamos mantenimiento predictivo automatizado, reduciendo paradas de máquinas críticas en un 40%.

Estos ejemplos validan que diseñar y operar pipelines inteligentes con IA integrada es una ventaja competitiva real y tangible.

Algunos consejos para principiantes

Si estás iniciando, te sugiero:

- Priorizar la modularidad para facilitar pruebas y ajustes.

- Comenzar con datos limpios y etiquetados para entrenar modelos IA.

- Implementar monitorización desde el día uno, aunque los pipelines sean simples.

- Asegurar la documentación y nítido control de versiones de modelos y código.

Conclusión

Mi experiencia trabajando con pipelines inteligentes demuestra que la combinación de diseño modular, modelos IA robustos, monitorización inteligente y seguridad fuerte convierte a estos sistemas en pilares fundamentales para cualquier organización que quiera transformar sus datos en ventaja competitiva.

Diseñar y operar pipelines inteligentes con IA integrada no es solo una tendencia, es una necesidad para maximizar el valor del dato, automatizar procesos complejos y adaptarse a un entorno cambiante rápidamente.

Si quieres dominar esta habilidad y transformar tu carrera profesional, quiero recomendarte el Curso Online especializado DevOps con IA y LLMOps Hackeando el ciclo completo. Allí aprenderás, paso a paso, cómo implementar soluciones reales con IA y pipelines escalables, con proyectos prácticos que te prepararán para liderar en este campo en auge. Para más información sobre arquitectura de pipelines y machine learning te recomiendo consultar documentación oficial de Apache Airflow.