Un driver en Apache Spark es una de las alternativas que forma parte de la gran variedad de herramientas creadas para el manejo adecuado del Big Data desde el sistema de Apache Spark. De hecho, este sistema en los últimos años se ha instaurado como uno de los sistemas de computación más empleados por grandes empresas para manipular sus macrodatos.

Recuerda que los macrodatos o Big Data hacen referencia a un gran volumen de datos; de hecho, anualmente se presenta un aumento del 12% en los datos generados. Por ello, este campo exige la multiplicidad de herramientas con las que cuenta.

Igualmente, un factor como driver en Apache Spark es un controlador spark.driver.host que te facilitará el procesamiento de los macrodatos; sin embargo, para ello debes identificar cómo trabajan conjuntamente los demás factores, como el Worker Node y los Executors en Apache Spark. Por este motivo, en este post, te presentamos qué es un driver en Apache Spark y cómo se desarrolla en su entorno desde la arquitectura de este sistema de computación.

¿Qué es un driver en Apache Spark?

Pues bien, el driver en Apache Spark es el proceso principal, puesto que controla toda la aplicación y ejecuta el SparkContext.

Por otra parte, un driver en Apache Spark es un proceso que requiere de otros componentes para llevarse a cabo. En efecto, podrás contar con el clúster manager, que es la comunicación del driver con el backend para adquirir los recursos físicos y poder ejecutar los executors.

Posteriormente, a partir de allí, se encarga el Worker Node o Nodo Trabajador, que hace referencia a las máquinas que dependen del backend y que se hace cargo de ejecutar los procesos de los executors.

Por último, como has podido notar, un driver en Apache Spark finaliza su trabajo al designar los ejecutores. Por tanto, los executors obtienen sus tareas desde el driver para llevar a cabo la carga, la transformación y el almacenamiento de los datos.

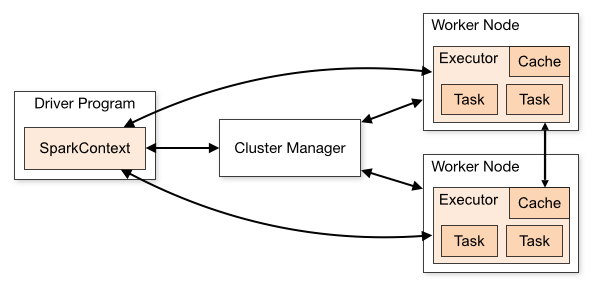

A continuación, te exponemos un gráfico en el que se visualiza cómo funciona el flujo de los datos en la arquitectura interna del sistema Apache Spark. En este ejemplo podrás notar cómo trabajan estas herramienta de forma conjunta.

De forma que el Driver Program es el que posee el SparkContext, es decir, quien se encarga de los datos bajo el concepto RDD (Resilient Distributed Datasets) o Conjuntos de datos distribuidos resistentes, en español. En suma, este se conecta al Clúster Manager como intermediario con los Nodos trabajadores que designan el trabajo de los executors en Apache Spark.

No obstante, el Driver Program puede comunicarse con los nodos trabajadores (Worker Node) sin necesidad del Clúster Manager, puesto que se abastece del controlador spark.driver.host.

Saber qué es y cómo funciona un driver en Apache Spark se ha instaurado como un gran pilar para comprender el desarrollo del flujo de datos creado por este sistema de computación. Ahora que ya reconoces la teoría sobre este factor, te aconsejamos continuar con el siguiente paso, que consiste en llevarlo a la práctica.

Por este motivo, en KeepCoding te presentamos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Durante el desarrollo de este bootcamp, podrás poner en práctica tus conocimientos teóricos y comprender que todo data scientist debe tener una buena base de estadística, álgebra, cálculo y geometría. Además, entre muchas otras cosas, aprenderás cómo funcionan las redes neuronales, cómo entrenarlas, cómo tunearlas y cómo aplicarlas a diferentes tipos de problemas en el estudio de los macrodatos. ¡No esperes más para solicitar información e inscríbete ya para convertirte en un experto dentro del sector IT!