El efecto modificación de capas en Deep Learning es una de las estrategias que permiten encontrar automáticamente estas características aprovechándose de la gran cantidad de datos disponibles para el estudio Deep Learning.

La primera red neuronal data de 1958. El problema es que no había potencia de cálculo suficiente para poder progresar hasta hace relativamente poco con la popularización de las GPUs de altas prestaciones.

De hecho, las redes neuronales convolucionales son una consecuencia de las altas expectativas depositadas y los «pocos» avances conseguidos. Por este motivo, en este post, te presentamos qué es y cómo funciona el efecto modificación de capas en Deep Learning.

Efecto modificación de capas en Deep Learning

El efecto modificación de capas en Deep Learning forma parte de las estrategias de facilitación en el procesamiento de las redes neuronales convolucionales en Big Data.

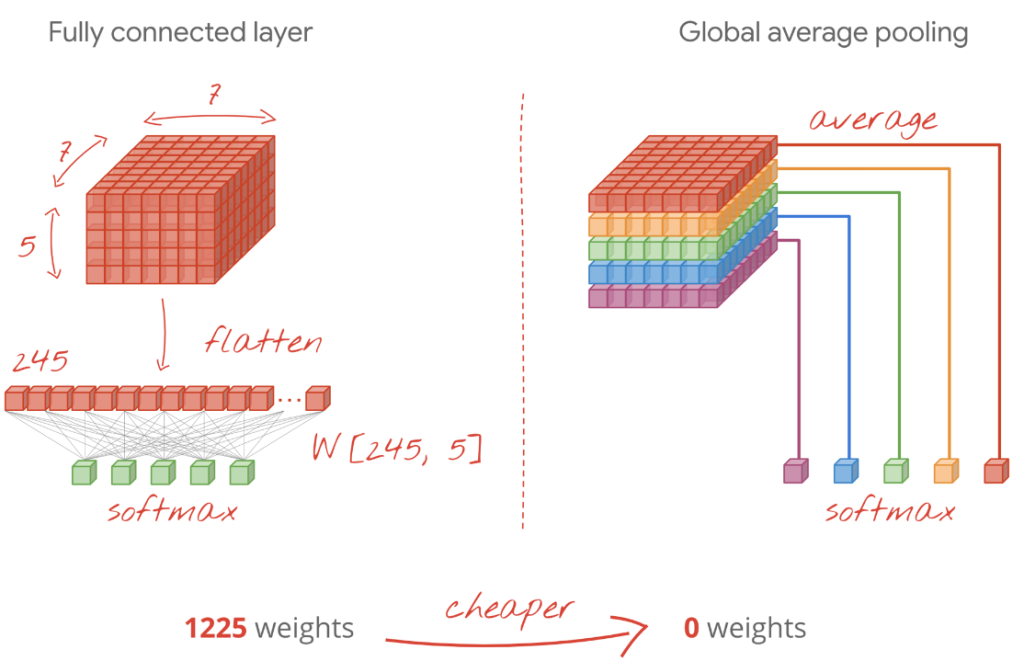

De manera que su empleo puede ayudarte a muchas alternativas provechosas para el manejo de los macrodatos. El efecto modificación de capas en Deep Learning cuenta con dos capas, que son: GlobalMaxPoling y GlobalMeanPoling frente Flatten.

Por otra parte, la operación de flatten nos permite pasar de un volumen de características a un vector sobre el que hacer la tarea de clasificación. Sin embargo, mediante esta operación, el número de parámetros se eleva considerablemente.

Aunque esto no es un impedimento, ya que dentro del efecto modificación de capas en Deep Learning también se suelen utilizar, como alternativas, otras capas como GlobalMaxPooling y GlobalAveragePooling, que permiten reducir el número de parámetros.

Ejemplo práctico del efecto de modificación de capas en Deep Learning

A continuación, te compartimos un breve ejemplo práctico sobre el efecto modificación de capas en Deep Learning para el manejo de los macrodatos.

from tensorflow.keras.layers import GlobalMaxPooling2D,GlobalAveragePooling2D

# Inizializamos el modelo

model = Sequential()

# Definimos una capa convolucional

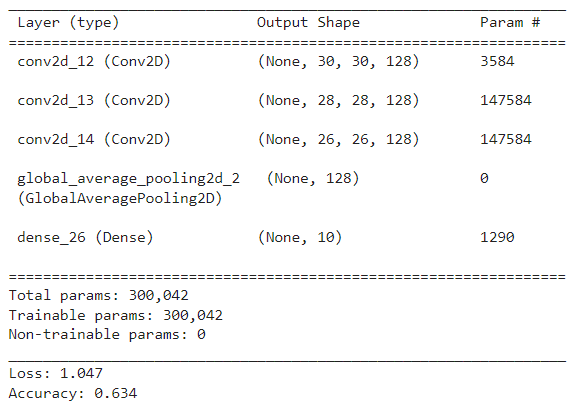

model.add(Conv2D(128, kernel_size=(3, 3), activation='relu', input_shape=(32, 32, 3)))

# Definimos la segunda capa convolucional

model.add(Conv2D(128, kernel_size=(3, 3), activation='relu'))

# Definimos la tercera capa convolucional

model.add(Conv2D(128, kernel_size=(3, 3), activation='relu'))

# Añadimos nuestro clasificador

model.add(GlobalAveragePooling2D())

model.add(Dense(10, activation='softmax'))

# Compilamos el modelo

model.compile(loss='categorical_crossentropy',

optimizer=Adam(lr=0.001, decay=1e-6),

metrics=['accuracy'])

# Entrenamos el modelo

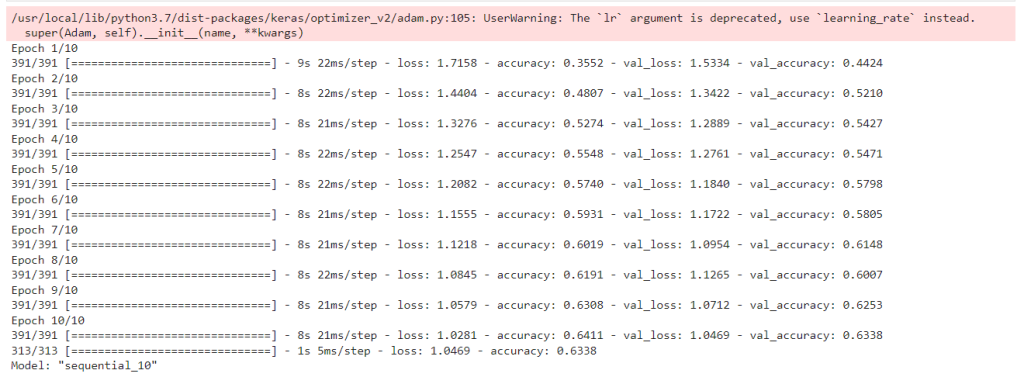

model.fit(X_train_norm, to_categorical(Y_train),

batch_size=128,

shuffle=True,

epochs=10,

validation_data=(X_test_norm, to_categorical(Y_test))) # aquí deberíamos usar un conjunto distinto al de test!!!

# Evaluamos el modelo

scores = model.evaluate(X_test_norm, to_categorical(Y_test))

#Observamos el número de parámetros

model.summary()

print('Loss: %.3f' % scores[0])

print('Accuracy: %.3f' % scores[1])

Esperamos que este acercamiento al efecto modificación de capas en Deep Learning sea de vital ayuda para conseguir resultados efectivos y precisos en el manejo del Big Data.

En el desarrollo de este post, te hemos expuesto el efecto modificación de capas en Deep Learning y cómo se comporta este para dentro de los facilitadores para el análisis de redes neuronales convolucionales en el manejo del Big Data. Aún así, te recordamos que este es un amplio universo y todavía falta mucho por aprender.

Para facilitarte el proceso de aprendizaje, desde KeepCoding te aconsejamos revisar el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning, por medio del que te formarás en el proceso de ingesta, clasificación, resguardo, procesamiento y presentación de los macrodatos gracias al uso de diferentes herramientas, sistemas y lenguajes.

Cuando finalices, en menos de nueve meses, serás capaz de reconocer las ventajas e inconvenientes de los distintos programas estudiados de la mano de grandes expertos en este ámbito y a través de ejemplos prácticos que permitirán afianzar la teoría de una forma más efectiva y precisa. ¡Echa un vistazo a nuestro temario e inscríbete ahora!