La estrategia de Kafka en GCP con Flume se considera una de las mayores ventajas ofrecidas por la plataforma de streaming opensource Apache Kafka. Este factor promete un desarrollo en la gestión de datos mucho más ágil y preciso en cuanto a la velocidad y sus resultados.

Por esta razón, conocer este tipo de dinámicas entre una serie de servicios populares de Big Data resulta de suma importancia. En este post, te exponemos un ejemplo de cómo funciona Kafka en GCP con Flume.

¿Cómo funciona Kafka en GCP con Flume?

Para explicarte cómo funciona Kafka en GCP con Flume vamos a mostrarte un ejemplo que te facilitará la comprensión del proceso.

En primer lugar, es necesario partir de que esta es una de las grandes ventajas que posee Apache Kafka, puesto que su versatilidad en GCP (Google Cloud Plataform) de mezclarse con Apache Flume es muy útil para el proceso adecuado de la transmisión de los macrodatos.

Pues bien, a continuación te compartimos una breve guía ilustrativa de cómo funciona Kafka en GCP con Flume por medio de un sencillo ejemplo.

Ejemplo de cómo funciona Kafka en GCP con Flume

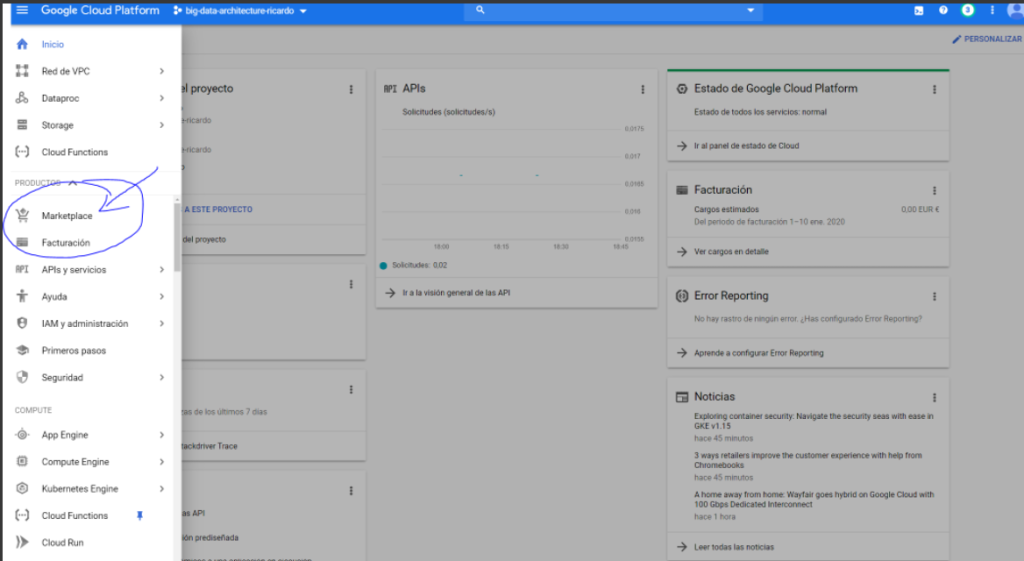

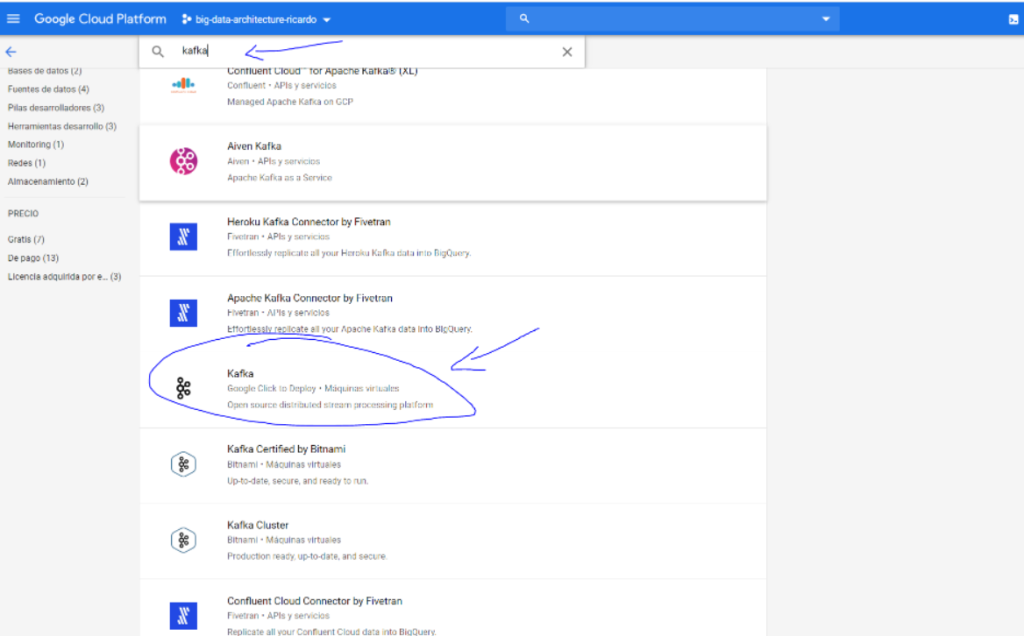

En primer lugar, deberás crear un clúster sencillo de Dataproc para, a partir de allí, dirigirte a Google Cloud Marketplace y crear una máquina de Kafka (standalone, preferiblemente virtualizada).

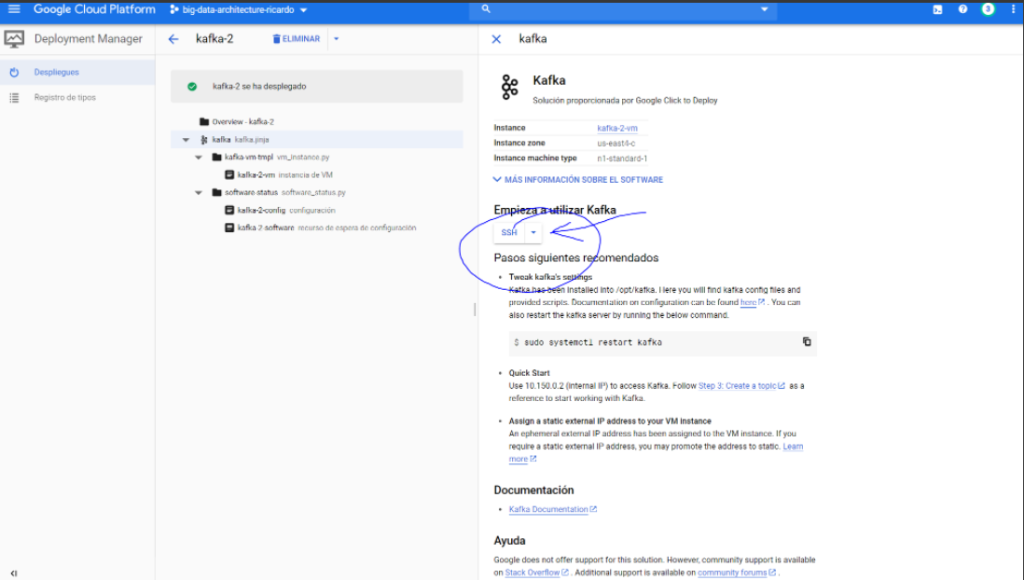

A continuación, te mostramos cómo se desarrolla en la plataforma el ejemplo de Kafka en GCP con Flume:

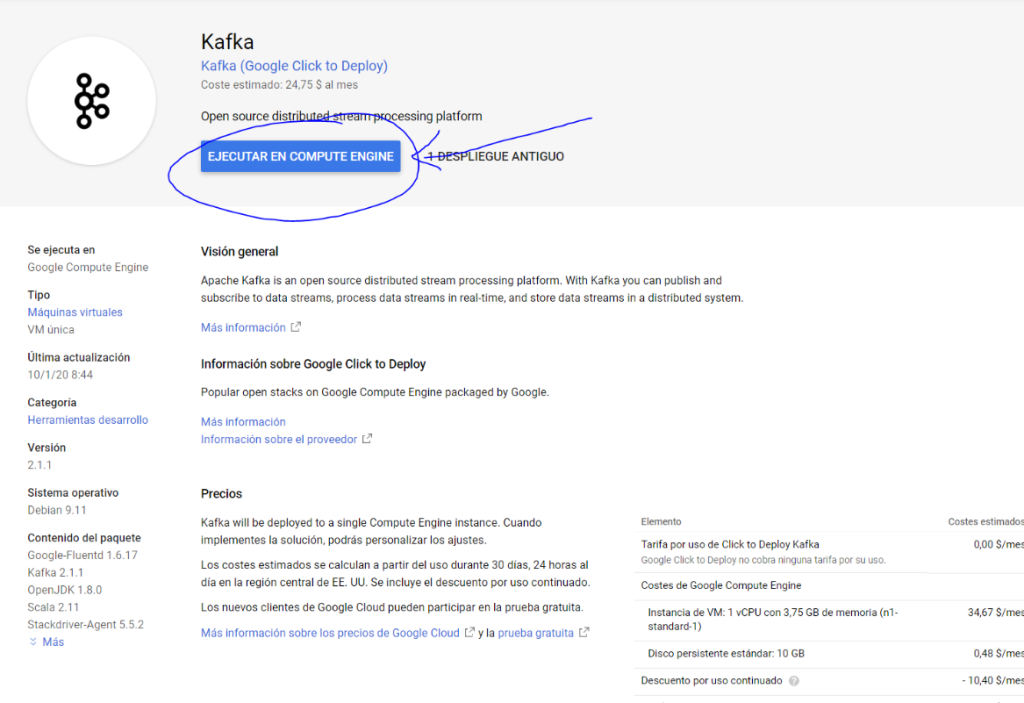

Una vez hayas seleccionado Kafka, tendrás que dar clic en la opción de «Ejecutar en Compute Engine» como te mostramos a continuación:

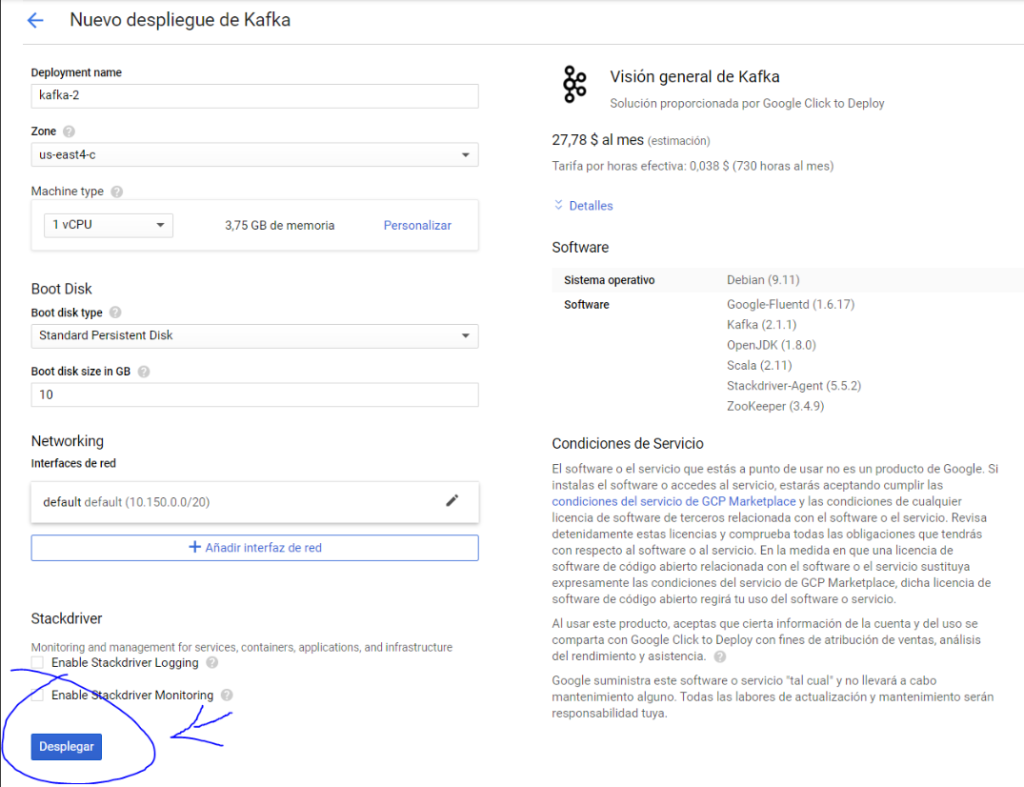

Después, deberás dar clic en la opción de «Desplegar»:

Por último, tendrás que crear esta fusión con Apache Kafka en GCP con Flume y después apuntar su IP. Finalmente, deberás entrar en la instancia de Kafka y ejecutar:

- cd /opt/kafka

- sudo bin/zookeeper-server-start.sh config/zookeeper.properties &

- sudo bin/kafka-server-start.sh config/server.properties &

- sudo bin/kafka-topics.sh –create –topic testkafka –bootstrap-server localhost:9092

- sudo bin/kafka-console-producer.sh –broker-list localhost:9092 –topic testkafka

En el desarrollo de este post, has podido identificar qué es Apache Kafka y además, comprender cómo funciona Kafka en GCP con Flume por medio de un ejemplo muy ilustrativo. No obstante, el desarrollo de esta herramienta de transmisión de datos requiere de muchos más conocimientos y desarrollo de sintaxis de consola, puesto que aquí solo te hemos mostrado una pequeña parte de un mundo muy amplio.

Por este motivo, desde KeepCoding te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En su transcurso, podrás profundizar en tus conocimientos sobre las herramientas, lenguajes y sistemas para el manejo del Big Data. En suma, podrás instruirte en remoto, de la mano de grandes profesionales en el área y con un acceso especial al material extra, los webinars y a los cursos complementarios durante todo el tiempo del bootcamp. En menos de nueve meses te considerarás todo un experto en el procesamiento de los macrodatos. ¡No esperes más para empezar e inscríbete ahora!