Los ejemplos de probabilidad en estadística Big Data sirven para practicar la forma en la que se puede desarrollar un estudio de los macrodatos. Por esta razón, antes de abordar un tipo de análisis estadístico profesional, resulta más provechoso realizar pruebas con anterioridad para potenciar tu rendimiento una vez sea profesional.

Por esta razón, en este artículo, te exponemos tres ejemplos de probabilidad en estadística Big Data para que puedas ensayar cómo se realizan este tipo de estadísticos.

3 ejemplos de probabilidad en estadística Big Data

A continuación te mostramos tres ejemplos de probabilidad en estadística Big Data que son, en primer lugar, uno sobre las estadísticas del Covid, el segundo con datos de recién nacidos y su peso al nacer y, por último, un ejemplo sobre el origen de la vida.

Ejemplo probabilidad COVID

En este ejemplo sobre la probabilidad de haber sufrido Covid, hay que partir de suponer que se tiene una población donde cinco de cada 1000 personas han sido infectadas por este virus.

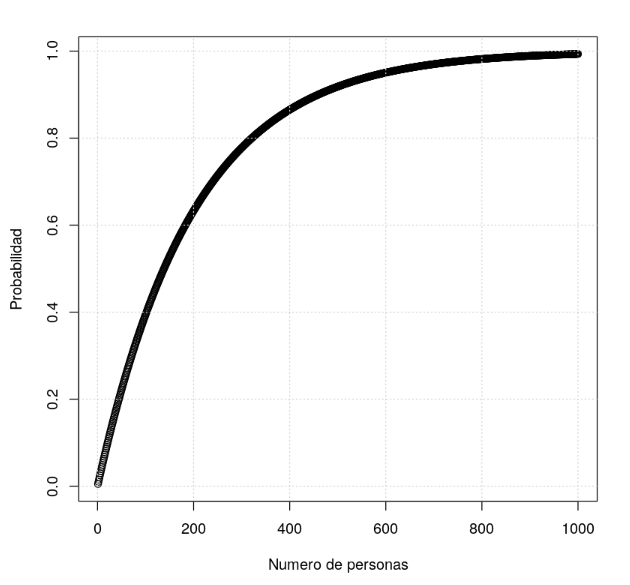

De manera que ahora hay que ilustrar una curva en la que se represente en el eje Y la probabilidad de encontrar al menos un contagiado en función del número de personas dado por el eje X, para ello se aplicarían las siguientes operaciones:

# probabilidades ejemplos p <- 5/1000 x <- 1:1000 prb <- 1-dbinom(x=0, size=x, prob=p) plot(x, prb, xlab='Numero de personas', ylab='Probabilidad') grid()

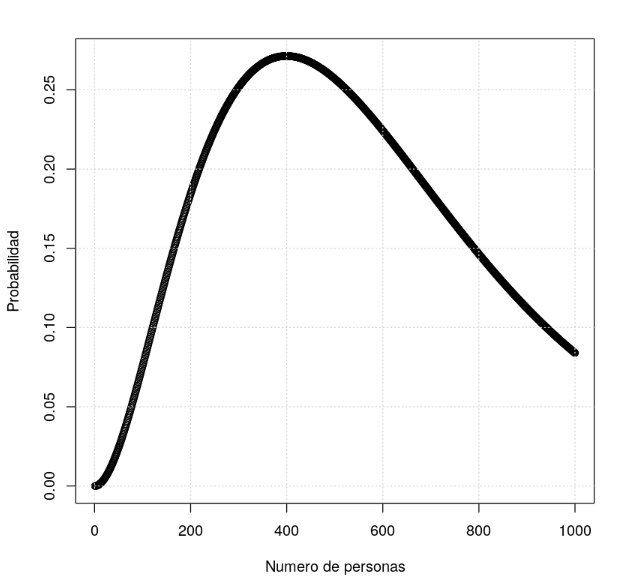

Ahora, debes pintar una curva donde se represente en el eje Y la probabilidad de encontrar exactamente dos contagiados en función del número de personas dado por el eje X.

# ejemplo de estadística prb <- dbinom(x=2, size=x, prob=p) plot(x, prb, xlab='Numero de personas', ylab='Probabilidad') grid()

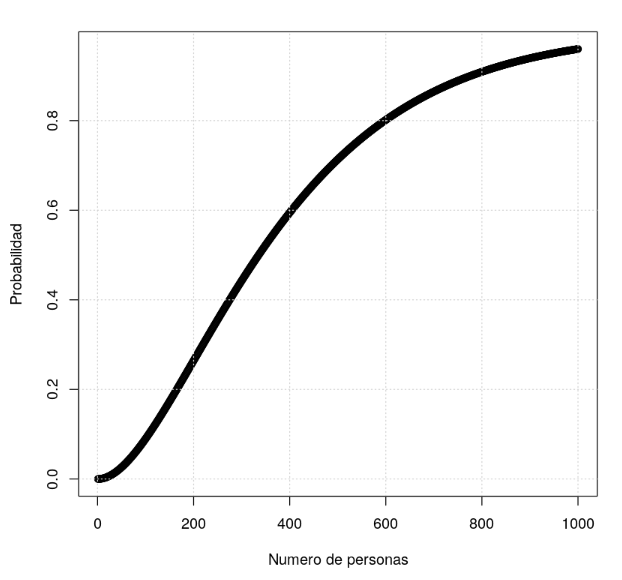

Por otra parte, pintar una curva donde se represente en el eje Y la probabilidad de encontrar dos o más contagiados en función del número de personas dado por el eje X.

# ejemplos de estadística prb <- 1-dbinom(x=0, size=x, prob=p)-dbinom(x=1, size=x, prob=p) plot(x, prb, xlab='Numero de personas', ylab='Probabilidad') grid()

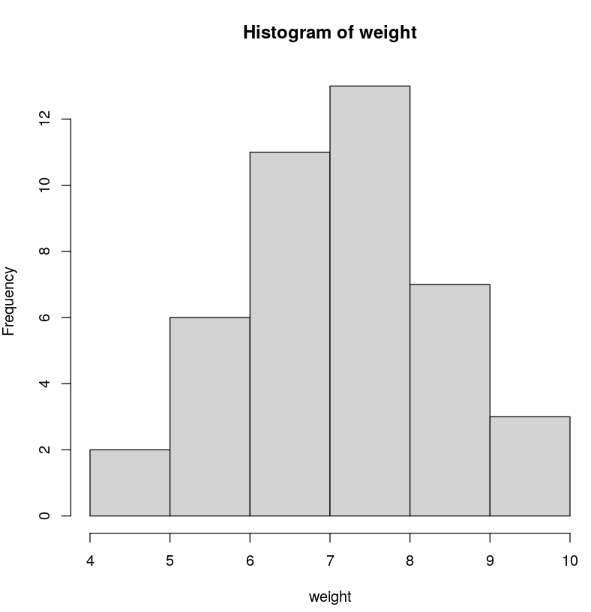

Ejemplo del peso al nacer

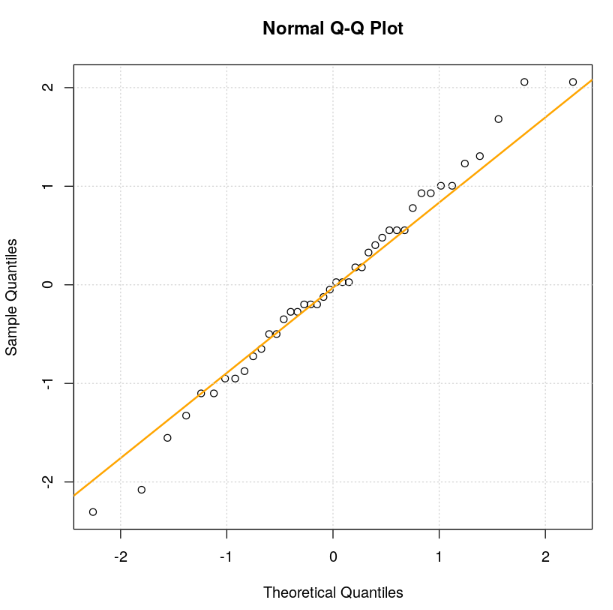

Para este ejemplo, hay que leer el dataset que se encuentra en data/birthweight_reduced.csv. A partir de allí, te quedas con la columna Birthweight. ¿Sigue una distribución gaussiana?

bwt <- read.csv('data/birthweight_reduced.csv')

weight <- bwt$Birthweight

hist(weight)

qqnorm((weight-mean(weight))/sd(weight)) qqline((weight-mean(weight))/sd(weight), col='orange', lwd=2) grid()

Ejemplo del origen de la vida

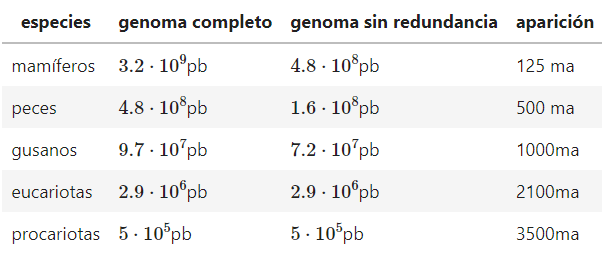

Los datos de este ejemplo del origen de la vida están basados en:

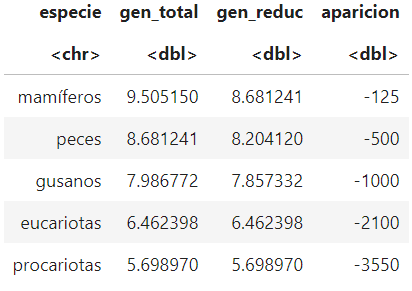

La siguiente tabla muestra la complejidad de ADN, eliminando las redundancias, de diferentes grupos de animales y su aparición en la tierra:

Las columnas significan:

- Especies: especies de animales.

- Genoma completo: longitud del genoma de una especie medido en pares de bases de ADN.

- Genoma completo: longitud del genoma de una especie, eliminando la redundancia, medido en pares de bases de ADN.

- Aparición: cuando ese conjunto de especies aparecieron.

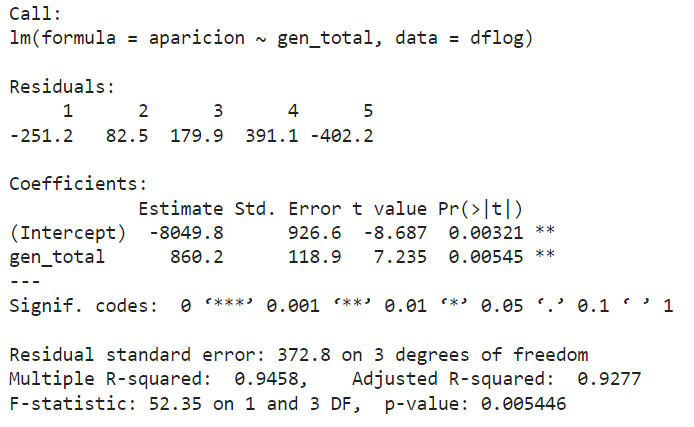

Con estos datos tratar de obtener una regresión que indique cuándo apareció un organismo con solo un par de bases genéticas, de manera que esto podría marcar el origen de la vida.

¿Qué columna habría que coger para hacer la regresión de la del genoma completo o el que elimina la redundancia?

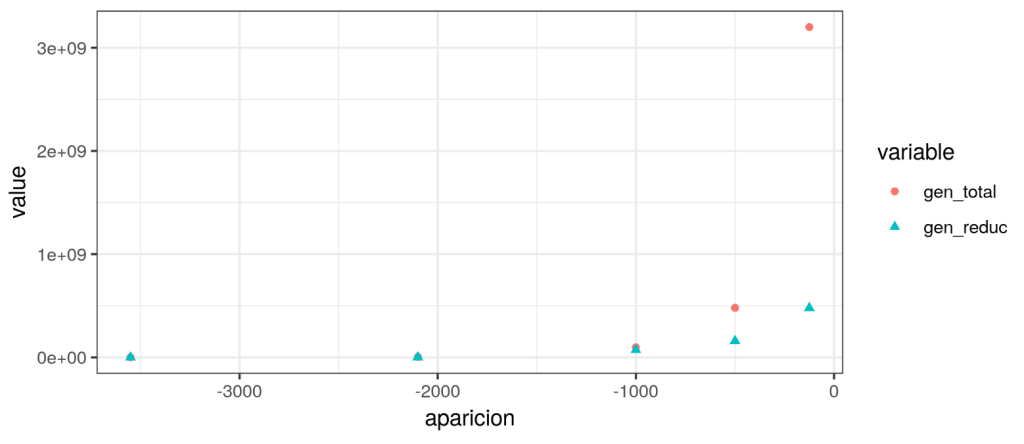

Ten en cuenta que es mejor usar escalas logarítmicas, como se expone a continuación:

df<-data.frame(especie=c("mamíferos","peces","gusanos","eucariotas","procariotas"),

gen_total=c(3.2e9,4.8e8,9.7e7,2.9e6,5e5),

gen_reduc=c(4.8e8,1.6e8,7.2e7,2.9e6,5e5),

aparicion=c(-125,-500,-1000,-2100,-3550))

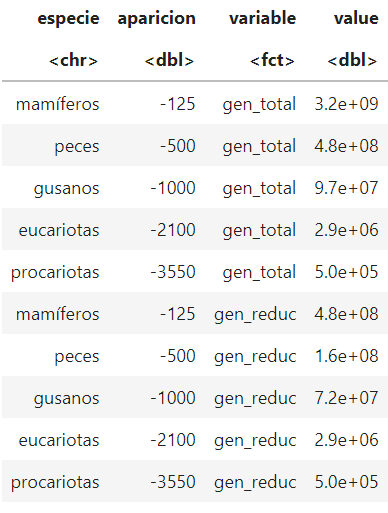

library(ggplot2) library(reshape2) options(repr.plot.height=3,repr.plot.width=7) dfm<-melt(df,id=c("especie","aparicion")) dfm

A data.frame: 10 × 4.

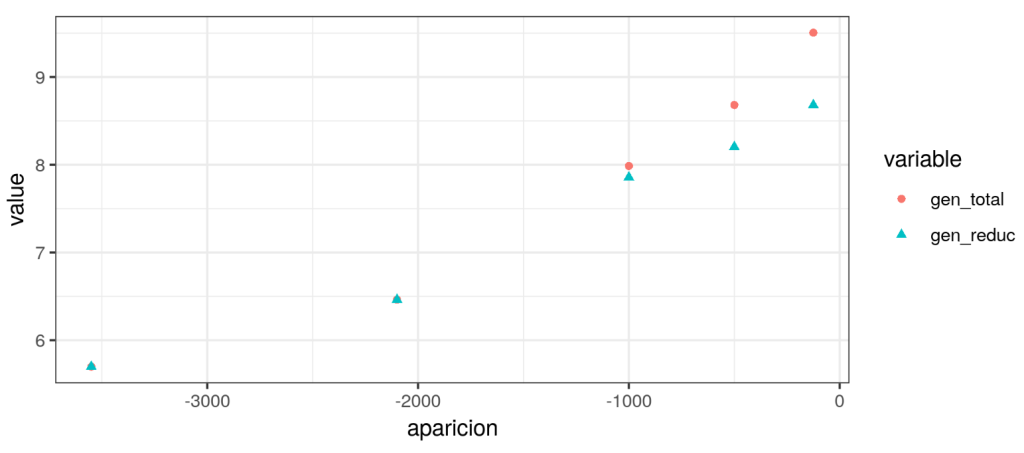

options(repr.plot.height=3,repr.plot.width=7, repr.plot.res = 300) ggplot(data=dfm,aes(x=aparicion,y=value))+ geom_point(aes(shape=variable,color=variable))+theme_bw()

dflog<-df

dflog[,2:3]<- log10(dflog[,2:3])

#dflog[,4]<- -log10(-dflog[,4])

dflog

dfm<-melt(dflog,id=c("especie","aparicion"))

options(repr.plot.height=3,repr.plot.width=7)

ggplot(data=dfm,aes(x=aparicion,y=value))+geom_point(aes(shape=variable,color=variable))+theme_bw()

A data.frame: 5 × 4.

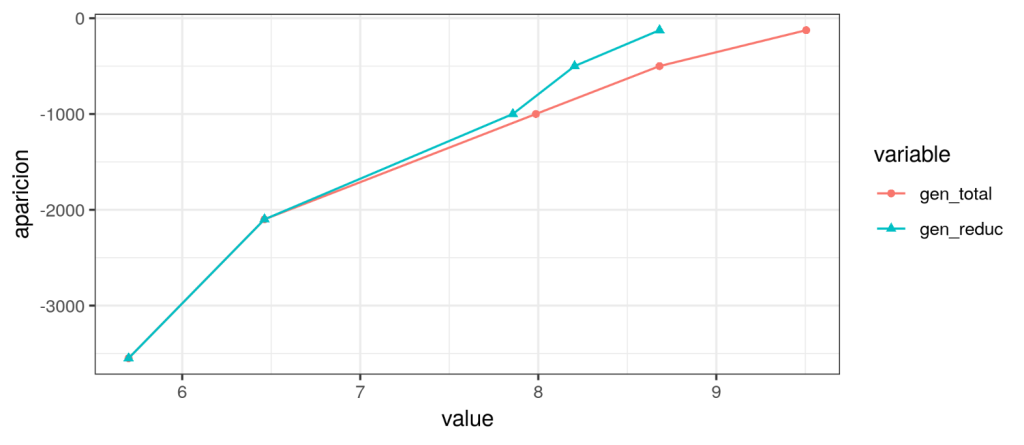

ggplot(data=dfm,aes(x=value,y=aparicion,shape=variable,color=variable))+ geom_point()+geom_line()+theme_bw()

model_total <- lm(data=dflog, formula=aparicion~gen_total) summary(model_total)

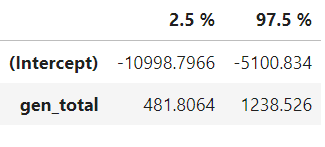

confint(model_total)

A matrix: 2 × 2 of type dbl:

predict(model_total, data.frame(gen_total=1),interval = 'prediction')

A matrix: 1 × 3 of type dbl.

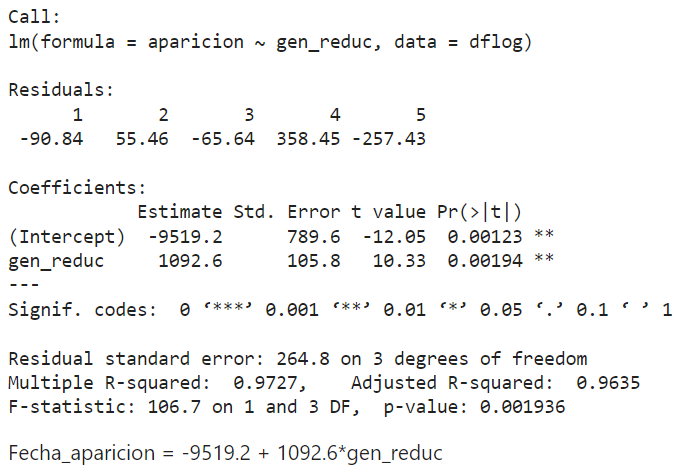

model_reduc <- lm(data=dflog, formula=aparicion~gen_reduc) summary(model_reduc)

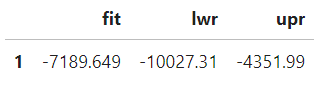

predict(model_reduc, data.frame(gen_reduc=1),interval = 'prediction')

A matrix: 1 × 3 of type dbl.

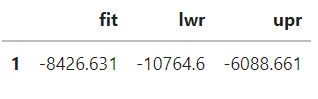

df_test<-data.frame(gen_reduc=1:10) df_test$pred <- predict(model_reduc, df_test) df_test

A data.frame: 10 × 2.

En el transcurso de este post, te hemos expuesto tres ejemplos de probabilidad en estadística Big Data que esperamos que te ayuden a comprender cómo se puede llevar a cabo un análisis estadístico de probabilidad para el manejo de los macrodatos. Sin embargo, sabemos que estos siguen siendo solo un primer acercamiento dentro de toda esta amplia rama, ¡así que todavía queda mucho por aprender sobre el Big Data!

Para ello, desde KeepCoding te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Gracias a él, podrás profundizar en el análisis de los datos mediante el reporting y, para ello, aprenderás a usar una herramienta denominada Tableau, muy conocida en el mundo del Business Intelligence. Además, comprenderás que el análisis visual es el objetivo final en un proyecto de Big data, ya que, a través de este, se puede proporcionar información muy útil para una empresa como respuesta a los problemas de negocio con un aspecto personalizado, ágil e inmediato. ¡No dudes en apuntarte!