Dentro del vasto mundo de herramientas del Big Data podrás encontrarte con Elastic Hadoop Connector, una herramienta que cada vez destaca más en el área de los macrodatos. De manera que conocer cómo funciona y para qué sirve es igual de importante. Si planeas convertirte en todo un data scientist, es necesario que te acerques a las principales herramientas del Big Data para poder escoger la más adecuada para el procesamiento de los datos.

Por ello, en este post, te acercamos a lo que es Elastic Hadoop Connector y para qué sirve en el desarrollo de un análisis de datos.

¿Qué es Elastic Hadoop Connector?

Elastic Hadoop Connector o ES-Hadoop es una alternativa que fusiona el servicio ofrecido por ElasticSearch y Hadoop para facilitar la búsqueda de los macrodatos en la plataforma. Para comprender cómo trabaja y qué es en realidad es necesario partir de para qué sirve dentro del mundo Big Data.

Por ello, ahora te compartimos este ejercicio corto, en el que verás cómo conectar Hadoop con ElasticSearch. Más en concreto, podrás hacer una conexión entre Apache Hive y un índice de ElasticSearch.

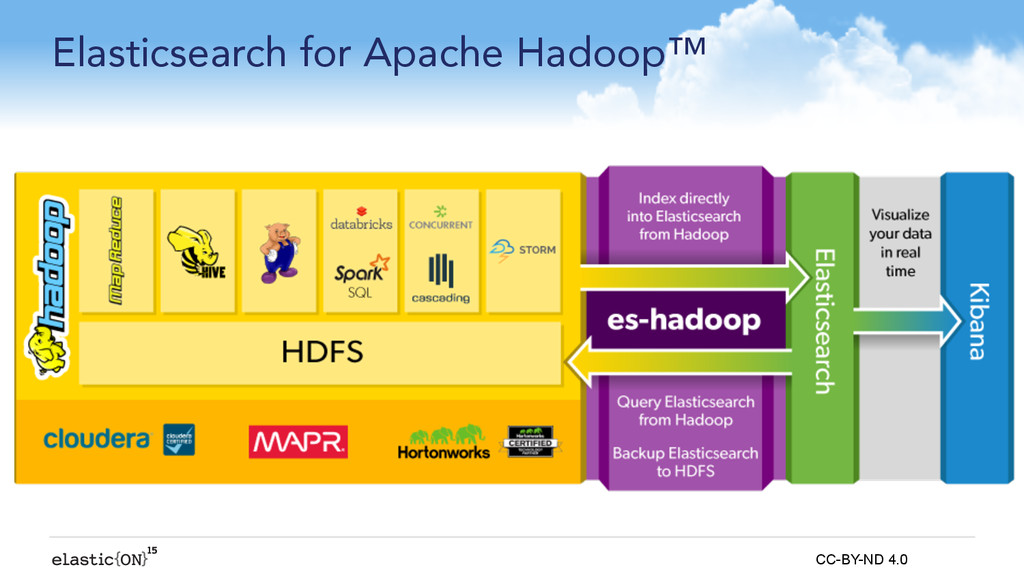

Para ello, debes tener en cuenta cómo funciona la arquitectura de ElasticSearch para Apache Hadoop. A continuación, te compartimos un esquema que la representa visualmente:

¿Para qué sirve Elastic Hadoop Connector?

Pues bien, Elastic Hadoop Connector sirve como una facilitación en la búsqueda de la información. Sin embargo, para ello requiere de una configuración en la plataforma.

Por ello, para que aprendas a configurar esto con ejemplos en GCP (Google Cloud Plataform) vas a necesitar:

- Un clúster en Standalone o Standard en Dataproc.

- Un ELK (Elasticsearch, Logstash y Kibanacon) de la versión 7.10 de ElasticSearch.

- Además, deberás hacer algunos cambios previos de configuración, como instalar librerías de soporte en Hadoop y poner ElasticSearch en modo inseguro para esta prueba.

Cambios en clúster de Hadoop

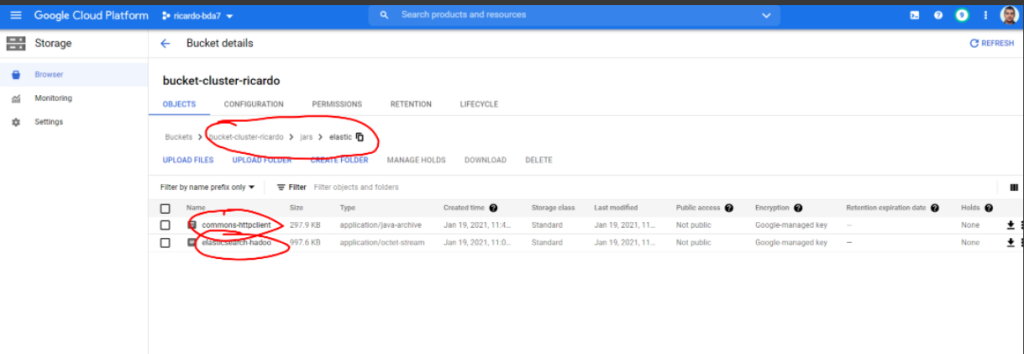

Para ello, debes seguir las indicaciones de las siguientes imágenes:

Debes descargar desde un bucket de Google Storage al filesystem del Cluster-m. Para ello, debes cambiar ricardovegas por tu user:

- gsutil cp gs://bucket-cluster-ricardo/jars/elastic/commons-httpclient-3.1.jar .

- gsutil cp gs://bucket-cluster-ricardo/jars/elastic/elasticsearch-hadoop-7.10.2.jar .

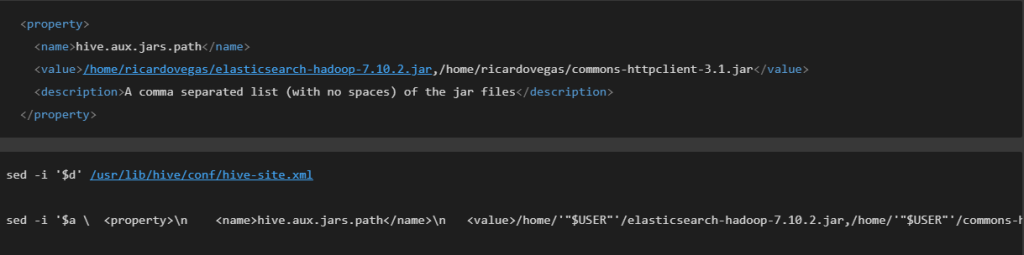

Ahora que están en el sistema de ficheros del master de Dataproc, ya podrás cargar los jars en la configuración de Hive. Para esto, debes modificar el hive-site.xml:

- sudo su

- nano /usr/lib/hive/conf/hive-site.xml

Ahora, continuando con el ejemplo, debes pegar dentro el equivalente en XML. Para ello, debes cambiar ricardovegas por tu user y así es cómo se vería en la consola:

A continuación, para actualizar la configuración hasta el momento, resulta necesario reiniciar Apache Hive. Puedes hacerlo así:

- exit

- sudo service hive-server2 restart

Cambios en el Elasticsearch

Ahora bien, para realizar los cambios en el Elasticsearch tendrás que colocar en false la opción de seguridad de Elasticsearch y reiniciarlo bajo el siguiente comando:

- sudo service elasticsearch restart

Conectar los datos

Finalmente, para conectar los datos debes tener en cuenta que desde Beeline podrás crear una tabla que esté conectada a un índice de Elasticsearch de la siguiente forma:

- beeline -u jdbc:hive2://localhost:10000

- CREATE EXTERNAL TABLE alumnos_es (id INT, name STRING, last_name STRING) STORED BY ‘org.elasticsearch.hadoop.hive.EsStorageHandler’ TBLPROPERTIES(‘es.resource’ = ‘alumnos’, ‘es.index.auto.create’ = ‘true’, ‘es.nodes’ = ‘34.88.146.137’);

- INSERT INTO alumnos_es values(1, ‘ricardo’, ‘vegas’), (2, ‘pedro’, ‘perez’);

INSERT INTO alumnos_es values(3, ‘maria’, ‘ochoa’), (4, ‘mario’, ‘gomez’);

¡Y ya está! Te hemos explicado el funcionamiento de Elastic Hadoop Connector como herramienta del Big Data. Ahora bien, no te desanimes si no lo consigues a la primera, este es un proceso de práctica bajo metodología de prueba y error.

Continúa aprendiendo sobre Big Data

En el desarrollo de este post, te has podido acercar a lo que es y para qué sirve Elastic Hadoop Connector. En suma, habrás podido notar su importancia dentro del mundo Big Data. A pesar de ello, esta herramienta funciona de la mano de otras herramientas de Hadoop, por lo que para comprenderla en profundidad es necesario ahondar en las demás dinámicas que desarrolla Hadoop. Si no sabes por dónde empezar, ¡no te preocupes!

Desde KeepCoding te traemos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Gracias a este podrás convertirte en un experto de Hadoop y de muchos más sistemas, herramientas y lenguajes populares dentro del ecosistema del Big Data. Además, durante todo su desarrollo contarás con el apoyo de material extra, webinars y cursos para profundizar en cada uno de los módulos presentados. ¿A qué estás esperando para empezar? ¡Inscríbete ya y conviértete en un experto dentro del sector IT!