Hadoop forma parte de los sistemas de desarrollo y se ha posicionado como uno fundamental gracias a su relación con el Data Lake y por su variedad de herramientas para el almacenamiento de datos. De manera que los elementos principales de Hadoop también se muestran como un conocimiento necesario para poner en práctica todas tus destrezas.

En este proceso, que involucra una gran disciplina y conocimiento, resulta necesario partir de los conocimientos básicos, como qué es Hadoop y demás características. Por ello, a continuación, te expondremos qué es y cuáles son los elementos principales de Hadoop junto a su importancia dentro del mundo Big Data.

4 Elementos principales de Hadoop

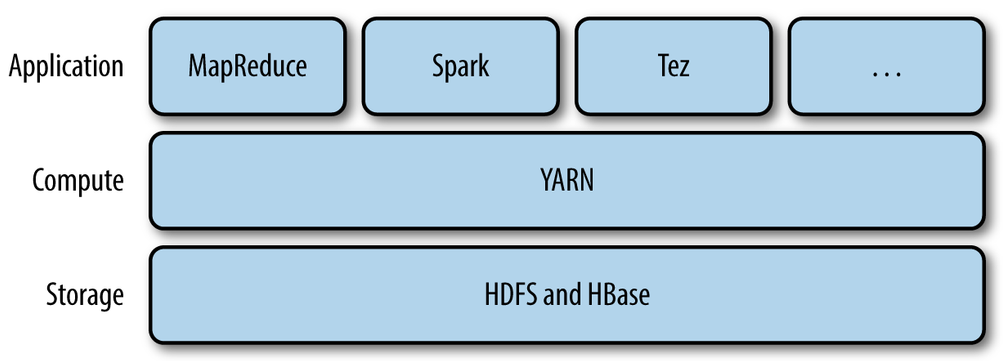

Para desarrollar su función de almacenamiento y procesamiento de la información, Hadoop se basa en ciertos elementos dedicados a determinadas tareas que facilitan todo el proceso y lo convierten en un estudio más eficaz. A continuación, te exponemos los cuatro elementos principales de Hadoop y en qué consiste cada uno de ellos:

HDFS

El primero de los elementos principales de Hadoop es HDFS (Hadoop Distributed File System). Este es el componente de la arquitectura de Hadoop que se encarga de distribuir grandes cantidades de datos en un clúster. De manera que se reconoce por los determinados elementos que le facilitan sus funciones, como son:

- En primer lugar, HDFS tiene una arquitectura main/workers.

- Dentro del Hadoop un clúster HDFS consta de un único NameNode, es decir, un servidor maestro que administra el espacio de nombres del sistema de archivos y regula el acceso a los archivos por parte de los clientes.

- Por otra parte, para desempeñar sus tareas, los DataNodes administran el almacenamiento.

MapReduce

Este es otro de los elementos principales de Hadoop y consta de dos factores base, tal y como se puede deducir gracias a su nombre:

- Map: hace referencia a Reading and formatting data, es decir, la capacidad de leer y formatear datos dentro de la estructura interna del Hadoop.

- Reduce: este factor se refiere a Applying transformations and operations on all of the data, lo que en español se traduce como la aplicación de transformaciones y operaciones en todos los datos que se estén manipulando.

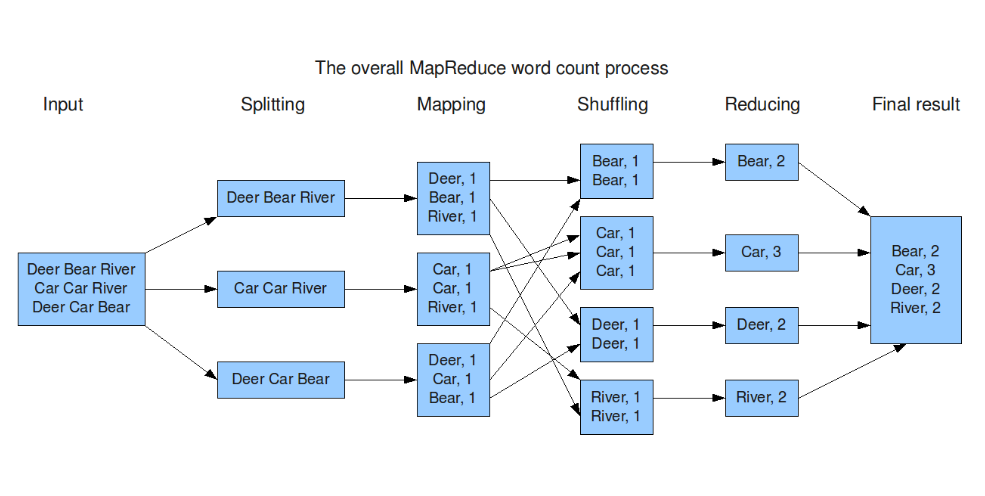

Una vez se integran estos componentes, el elemento de MapReduce llevará a cabo su conteo general de palabras, el cual consiste en:

- Input: es decir, la entrada de los datos, la adición de la información que será procesada a continuación.

- Splitting: consiste en la división de la información.

- Mapping: proceso que mapea los datos, es decir, los clasifica según los modelos instaurados.

- Shuffling: este proceso, tal como te ilustraremos a continuación, se basa en el proceso de barajar los datos.

- Reducing: una vez se completa el proceso anterior, Hadoop MapReduce lleva a cabo su principal objetivo de reducir la información, dejando solo la necesaria.

- Final result: finalmente, expone los resultados arrojados tras esta serie de procesos de data.

YARN

YARN (Yet Another Resource Negotiator u Otro negociador de recursos más) es una capa de control sobre las aplicaciones o comandos que corren sobre la estructura de software Hadoop. Por otro lado, forma parte de los elementos principales de Hadoop, puesto que es una capa muy cercana al HDFS (Hadoop Distributed File System), aunque es de bastante bajo nivel. Además, está desarrollado mediante el lenguaje de programación JAVA.

Hadoop Common

Este es el último componente de los cuatro elementos principales de Hadoop. Es el encargado de administrar el acceso a la serie de bibliotecas y servicios que posee Hadoop, de manera que se relacionen los procesos de los objetos comunes de las bibliotecas entre los diversos módulos de Hadoop.

Sigue aprendiendo sobre Hadoop y sus principales elementos

En este post, te hemos explicado qué es y cuáles son los elementos principales de Hadoop. Sin embargo, desde KeepCoding sabemos que este proceso de aprendizaje del Big Data exige un largo recorrido para poder convertirte en todo un experto en el manejo de los macrodatos. Por ello, es necesario que continúes estudiando sobre todas sus herramientas.

Si no sabes cómo seguir aprendiendo, desde KeepCoding te traemos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning que podrá ayudarte con ello. En el transcurso de este bootcamp, aprenderás todo lo necesario para convertirte en un experto gracias a los 11 módulos que te preparan en las herramientas, sistemas y lenguajes más importantes dentro del manejo del Big Data. Todo ello de la mano de profesores expertos en el tema y a tu disposición para cualquier inquietud o asesoría. ¡Empieza ahora!