El proceso ETL (extraer, transformar, cargar) es muy relevante para el universo del Big Data. Su implementación se lleva a cabo como parte fundamental y básica dentro del procesamiento de los datos, sobre todo, en sistemas de almacenamiento. Si planeas convertirte en un experto en las herramientas del manejo de los macrodatos, es necesario comprender a qué hace referencia este proceso en específico.

Desde KeepCoding reconocemos su importancia, por ello, exponemos lo que es y cuáles son sus principales características que facilitan la gestión del Big Data. A continuación, en este post, te explicamos qué es ETL (extraer, transformar, cargar) para el procesamiento de los macrodatos.

¿Qué es ETL (extraer, transformar, cargar)?

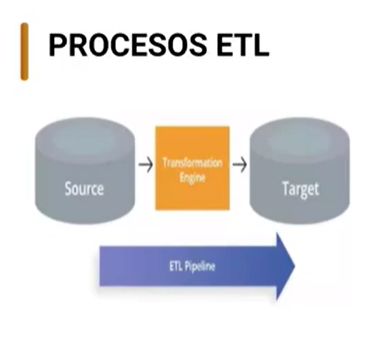

En primer lugar, se puede definir el proceso ETL como un proceso de gestión de datos que permite extraer y mover datos desde múltiples fuentes, transformarlos y cargarlos en el destino. A continuación, te exponemos una breve ilustración en la que se visualiza cómo se lleva a cabo el flujo de datos desde el source hasta el target por medio de la transformation engine.

Por otra parte, resulta necesario especificar cómo funciona cada una de estas fases del proceso ETL:

- E (Extraer o Extract): esta parte del proceso analiza el origen de los datos y los extrae desde el mismo. Posteriormente, analiza la información extraída y verifica sus criterios de calidad y forma. Por último, si es necesario, convierte los datos a determinado formato para empezar el proceso de transformación.

- T (Transformar o Transform): en esta fase se modifican los datos en bruto para que se presenten los formatos correctos. En suma, se produce la normalización, es decir, en donde se formatean y almacenan; para ello también se eliminan los duplicados, se aplican las reglas del negocio y se lleva a cabo la clasificación de la información.

- L (Cargar o Load): esta última fase implica mover los datos procesados al sistema de destino.

¿Para qué sirve ETL?

En definitiva, este proceso te permite hacer una ingesta de datos, extrayendo datos desde uno o varios orígenes de datos que, además, pueden ser de diferente índole. Estos pueden ser ficheros, tablas, datos no estructurados, redes sociales, aplicaciones… De cualquier forma, consiste en extraer datos de cualquier fuente y con cualquier formato para procesarlos y crear un análisis de la información.

Al final, podrás extraer datos de cualquier cosa. De hecho, puesto que ahora mismo todo está conectado a internet, este proceso resulta muy útil y efectivo. Es decir, todo está transmitiendo datos, todo está almacenando datos, de manera que lo que permite el proceso ETL es leer ese volumen de datos y cargarlos para trabajarla y convertirla en información valiosa.

Además, este proceso funciona dentro del mundo Big Data como una herramienta fundamental, tanto para expertos como para principiantes en el campo. De forma que su curva de aprendizaje es bastante sencilla, no necesitarás saber de programación para llevar a cabo este proceso y podrás emplearlo en cantidades reducidas o muy abundantes de datos.

¿Para qué se utiliza ETL?

El proceso ETL se utiliza en prácticamente cualquier operación empresarial. Los datos desempeñan un papel importante, sin embargo, para que se destaque su valor es necesario trasladarlos y deben prepararse para su uso. Para ello, es necesario implementar procesos como el ETL.

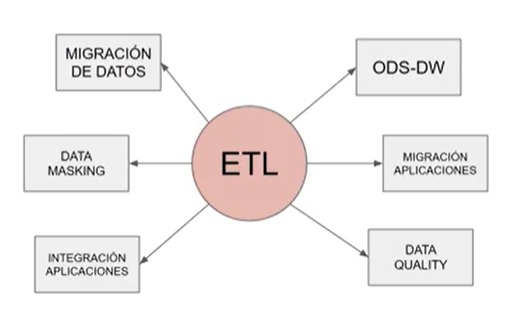

El desarrollo de estos procesos de procesamiento de los macrodatos se puede encontrar en determinados casos de aplicación. A continuación, te exponemos algunos casos para los que se utiliza ETL:

- Migración de datos de una aplicación a otra.

- Replicación de datos para copias de seguridad o análisis de redundancia.

- Procesos operativos como la migración de datos desde un CRM (Customer Relationship Management) a un ODS (almacén de datos operativos) para potenciar o enriquecer los datos y luego devolverlos al CRM.

- Depositar los datos en un almacén de datos para provisionar, clasificar y transformarlos en conceptos de negocio.

- Migración de aplicaciones de infraestructuras locales a cloud, cloud híbrida o multicloud.

- Sincronización de sistemas clave.

¿Quieres seguir instruyéndote en el Big Data?

En el desarrollo de este post, te has acercado a cómo funciona el proceso de ETL (extraer, transformar, cargar) dentro del mundo del Big Data. Sin embargo, la implementación de este proceso se encuentra en diversas plataformas o programas y cada uno de ellos requiere un conocimiento más amplio sobre su desarrollo. De manera que ¡todavía falta mucho por aprender!

Para ello, desde KeepCoding te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En el desarrollo de este, te encontrarás con una serie de conocimientos base para llevar a cabo una gestión de la información apropiada según el interés y el planteamiento del problema establecido. Por tanto, te encontrarás con once módulos que abarcan desde los conceptos más básicos hasta las herramientas más complejas del mundo Big Data, todo ello en menos de nueve meses. ¡Anímate y apúntate ahora mismo!