Los flujos de datos en Talend Open Studio son un aspecto sumamente importante para el desarrollo de un procesamiento de los macrodatos en esta plataforma. No solo hacen referencia a los flujos de los datos, también remite al flujo de los jobs. De manera que lo que abarca se muestra como un conocimiento prioritario si planeas desenvolverte en esta suite y su gran variedad de servicios para la gestión de la información.

De igual forma, este tipo de saberes pueden acoplarse no solo a esta plataforma, sino también a otras tantas que se dedican a lo mismo y que poseen un desarrollo parecido a la hora de trabajar con los flujos de los datos. Por esta razón, en este post, te compartiremos cómo funcionan los flujos de datos en Talend Open Studio, lo que abarca el generador de datos, el generador de flujos y los tipos de flujos de jobs.

¿Cómo funcionan los flujos de datos en Talend Open Studio?

Los flujos de datos en Talend Open Studio se conocen como el sistema o la ruta que desarrollan los datos durante el proceso planteado en el análisis los macrodatos. Para ello, Talend Open Studio (TOS) cuenta con una serie de comandos que se dedican a las diferentes etapas del flujo de datos. Por ejemplo: los de generador de datos, generador de flujos y los distintos tipos de flujos de jobs.

A continuación, te compartimos cuáles son los principales comandos para los flujos de datos en Talend Open Studio y cómo se emplea cada uno de ellos:

Generador de datos

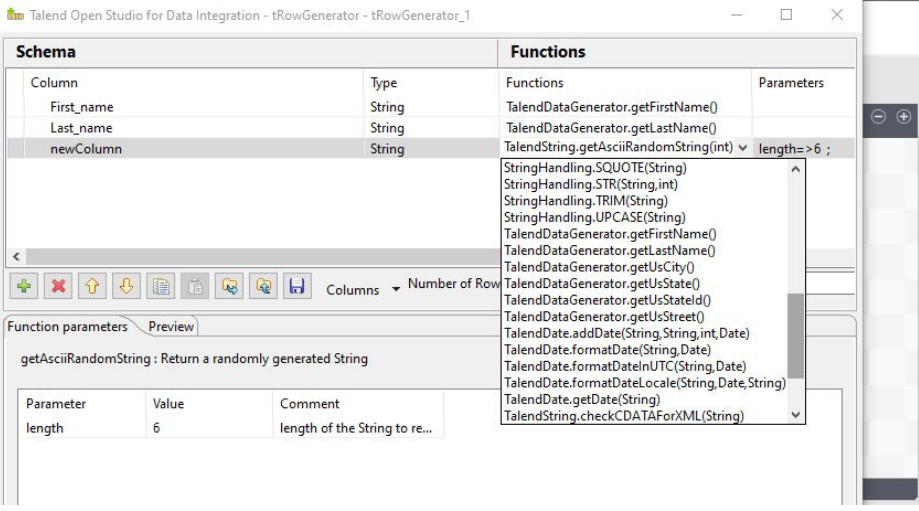

- tRowGenerator: este comando cumple con la función de generar los datos de manera automática. Por ejemplo, podrás establecer una función de fecha como TalendDate.formatDateInUTC(String, Date) y marcar un rango de fechas, de esta forma la plataforma las irá generando automáticamente.

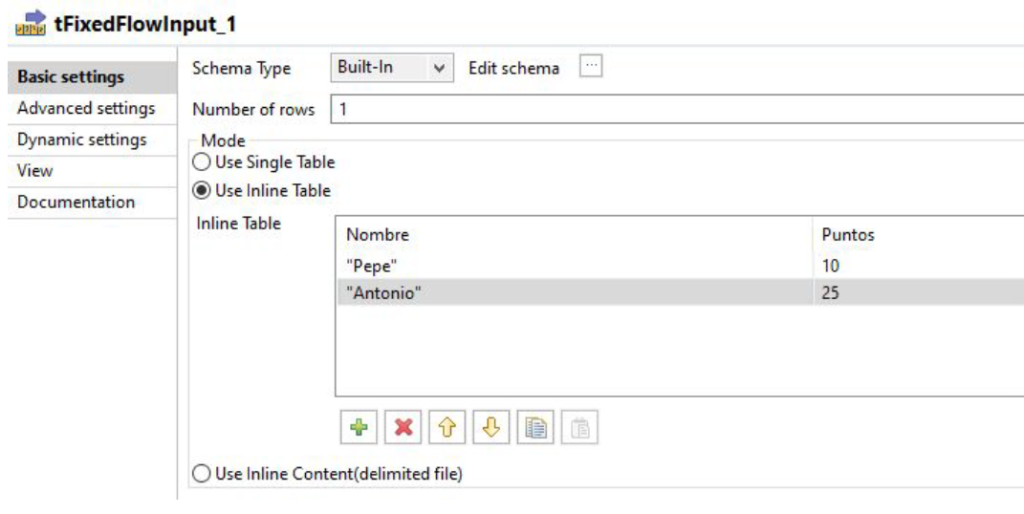

- tFixedFlowImput: en cuanto a esta función, tFixedFlowImput te permite generar los datos de forma manual.

Generador de flujos

Por otra parte, podrás contar con el generador de flujos de datos en Talend Open Studio. A continuación, te exponemos sus principales funciones:

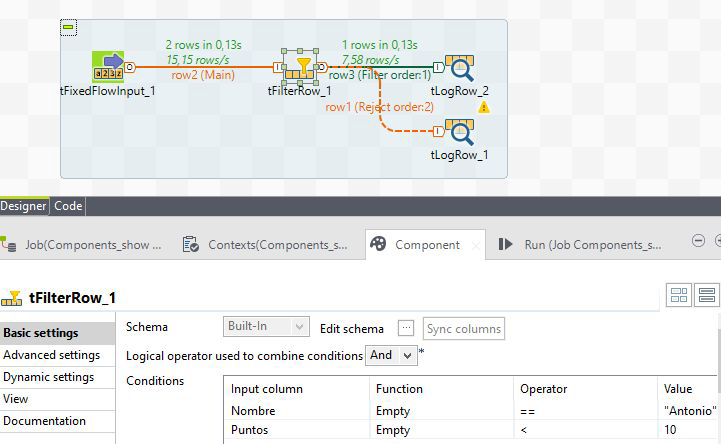

- tFilterRow: como dice su nombre, consiste en establecer un filtro de datos. Este puede ser un flujo de salida «Filter», es decir, el flujo que contiene los datos que cumplen la condición. Por otra parte, puede ser un flujo de salida «Reject», es decir, el flujo rechazado es el que no cumple la condición establecida.

- tReplicate: consiste en replicar el flujo. Este componente se utiliza cuando, por motivos del proceso, es necesario que el flujo se replique. Por ejemplo, para hacer la misma salida de datos a una tabla desde una base de datos y también a un fichero.

- tUnite: esta función te permite unir dos flujos. Así, este componente hace lo contrario al tReplicate, ya que une dos flujos de datos que tengan un mismo esquema. Por tanto, no combina registros, sino que simplemente junta un flujo de datos debajo de otro, tipo UNION de SQL.

- tJoin: tal como su nombre indica, es un join de flujos. Sin embargo, este casi no se implementa, puesto que el componente tMap aporta mayor potencia y optimización de este proceso y ofrece otras capacidades para la gestión de los datos.

Tipos de flujos de jobs

Otra de las posibilidades de los flujos de datos en Talend Open Studio hace referencia a los flujos de jobs, que son los siguientes:

- Flujo de datos Main: este es el flujo que hace circular todo el caudal de datos principal del job.

- Flujo de datos Iterate: un flujo de datos tipo Iterate permite enviar los registros de uno en uno y son captados por una variable que podrás utilizar en un componente de manera iterativa, por ejemplo, para enviar correos electrónicos a partir de los registros de una tabla de datos.

- Disparadores Triggers: los disparadores son otro tipo de conectores que te permiten activar diferentes caminos de subjobs en función del resultado OK/Error de un subjob anterior.

Por medio de este post, te has podido acercar a todo a lo que hace referencia a los flujos de datos en Talend Open Studio. De hecho, has podido comprender que los flujos tanto de datos como de jobs son un aspecto fundamental en el desarrollo de la plataforma y, en efecto, constituye el mayor fundamento para el procesamiento de los macrodatos. Sin embargo, dada su importancia, resulta necesario aprender más sobre ellos y su funcionamientos con los comandos.

Por ello, te aconsejamos cursar nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning, que te ayudará a desarrollar todos los conocimientos necesarios al respecto. Además, te brindará los conocimiento imprescindibles para cumplir con la tarea principal de un data scientist, que consiste en identificar las múltiples herramientas, sistemas y lenguajes del manejo de los macrodatos y seleccionar la que mejore el estudio de la información. ¡Apúntate!