Si has llegado aquí es porque seguro que te interesa instruirte acerca de Scrapy y todo lo que abarca su desarrollo dentro del mundo del Big Data. Si es así, ¡este post es ideal para ti!

A partir de un breve de glosario con siete de los conceptos clave que atañen a Scrapy, podrás contar con un primer acercamiento propicio para empezar con este popular sistema de código abierto. En este post, te exponemos los siete conceptos clave de Scrapy para empezar a conocerlo.

Scraping

Scraping (raspado web en español) es un sistema de extracción de datos de una o varias páginas web. Posee ciertos componentes de la arquitectura de Scrapy, como el downloader o descargador, el Scrapy Engine o motor, las requests o solicitudes, las answers o respuestas y los crawlers o arañas web.

Por otra parte, el Scraping responde a cualquier tipo de datos encontrado en las páginas web, puesto que Scrapy no solo se hace en páginas web, sino que también podrás scrapear una base de datos e, incluso, podrás llegar a scrapear una API.

Crawler

En Scrapy podrás crear y ejecutar crawler o arañas web, es decir, desarrollar rastreadores web que funcionan de manera automática y sistematizada para inspeccionar los datos y las URLs de determinados sitios web. Por medio de este concepto, podrás diferenciar entre dos procesos fundamentales del Big Data: Scraping y Crawling.

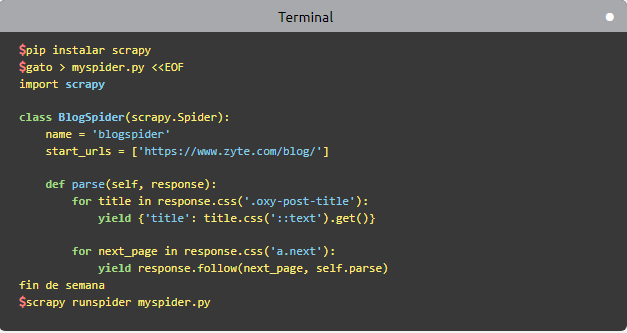

Scrapy Shell

Por su parte, scrapy shell hace referencia a la terminal interactiva que consiste en depurar el código de rastreo de la araña web. Mediante dicha terminal podrás intentar hacerlo con expresiones como CSS o XPath. Además, en esta terminal podrás:

- Desarrollar la configuración de carcasa por medio de la instalación de IPython o, en su defecto, con el uso de Bpython.

- Instaurar la estrategia de lanzar el caparazón, de manera que se estipule una URL específica para llevar a cabo el raspado de datos.

- Tener la oportunidad de usar el caparazón de las arañas para inspeccionar las respuestas y generar accesos directos.

Zyte Scrapy Cloud

Esta es una herramienta específica para el alojamiento en la nube. Zyte Scrapy Cloud te permitirá alojar las arañas web que desarrolles en la nube con un gran control de calidad y una serie de herramientas para su administración.

Scrapy Engine

El motor o Scrapy Engine es lo que se encarga de conectar todos los componentes del flujo de datos y responde a los comandos para rastrear a partir de la araña.

A partir de allí, el motor gestiona la consecución de los datos según las solicitudes del programador, y posteriormente, envía las requests al descargador.

Downloader

El downloader o descargador es el encargado de buscar las páginas web y enviarlas al motor.

Una vez los datos terminan de descargarse de la página web, el downloader envía una respuesta al motor atravesando los downloader middlewares.

Biblioteca Python

Una de las mayores ventajas de Scrapy es la cantidad de bibliotecas de Python que te ayudarán en la extracción de datos de sitios web según tus destrezas e intereses. Con su biblioteca Python de análisis XML y HTML podrás desarrollar una extracción de datos de alta calidad y rapidez.

Aprende más del Big Data

En este post, te hemos expusto un breve glosario con siete conceptos clave de Scrapy. Sin embargo, recuerda que cada uno de ellos trabaja junto a otras herramientas que sería adecuado conocer e identificar. ¡Así que aún falta mucho por aprender!

Por ello, si lo que buscas es continuar formándote sobre las herramientas del manejo Big Data, podrás lograrlo desde KeepCoding con nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Big Data. En menos de nueve meses, podrás convertirte en todo un data scientist. ¡Échale un vistazo a nuestro temario y apúntate ahora!