Con el paso del tiempo, Hadoop se ha ido posicionando en el universo del Big Data como la estructura de software más implementada para la administración de repositorios Data Lakes. Por ello, es imprescindible contar con una guía de Hadoop desde cero, de manera que puedas identificar todo el proceso y desarrollo que se genera de manera interna y externa para lograr un procesamiento de datos acertado.

Tener en cuenta cada uno de sus componentes, la ruta de acción que emplea y su eficiencia al respecto es un estudio inexcusable. Por este motivo, a lo largo de este post te explicaremos cómo funciona Hadoop desde cero.

Hadoop en pocas palabras

En definitiva, Hadoop no es más que una colección de herramientas que posee como software y que se caracterizan por ser de código abierto, aunque podrás encontrar algunas que sean closed source.

¿Cómo funciona Hadoop desde cero?

A continuación, te detallamos cómo utilizar Hadoop desde cero. Como primer paso, deberás instalar y probar HADOOP 2.7, a partir de la siguiente operación:

- docker ps

- docker pull sequenceiq/hadoop-docker:2.7.1

Una vez instalado, podrás entrar en acción y poner a prueba tus destrezas.

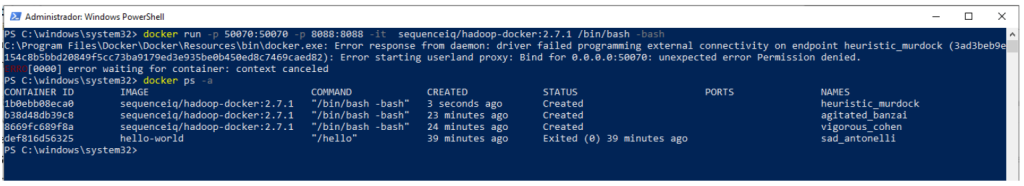

- docker run -p 50070:50070 -p 8088:8088 -it sequenceiq/hadoop-docker:2.7.1 /bin/bash -bash

Nota Windows

Si tu sistema es Windows, podría aparecerte una alarma de error como la siguiente:

- «docker: Error response from daemon: Ports are not available: listen tcp 0.0.0.0:50070: bind: An attempt was made to access a socket in a way forbidden by its access permissions.»

Esto se debe a un tema de seguridad interno de Windows y Hyper-V. No obstante, podrás cambiar los puertos a unos diferentes, como, por ejemplo:

- docker run -p 20070:50070 -p 2088:8088 -it sequenceiq/hadoop-docker:2.7.1 /bin/bash -bash

Error 139 en Windows

Si ahora te sale este error, quiere decir que se levanta el contenedor. Para derribarlo, deberás ejecutar:

- docker ps -a

Ahora bien, si notas que tiene marcado el resultado exit (139), es un asunto de configuración de WSL (Windows Subsystem for Linux). Para corregirlo, tendrás que abrir Notepad y escribir en su interior lo siguiente:

- [wsl2]

- kernelCommandLine = vsyscall=emulate

- memory=4GB # Limits VM memory in WSL 2 up to 3GB

- processors=4 # Makes the WSL 2 VM use two virtual processors

Posteriormente, debes guardar el fichero (ctrl+shift+s) como C://Usuarios/XXXX/.wslconfig (ten en cuenta la extensión, ya que no puede ser .txt). Finalmente, deberás reiniciar Windows y el problema se habrá solucionado.

Continúa con Hadoop desde cero

Ahora, podrás continuar implementando alguno de los comandos Linux con los que trabaja Hadoop, como:

- ls (list).

- pwd (print working directory).

- cat (catenate).

- tail (tails).

- mkdir (make subdirectory).

Por otra parte, también podrás buscar la IP del clúster desde el host, gracias a los siguientes comandos:

- docker network list

- docker network inspect docker_default

¡Ten en cuenta!

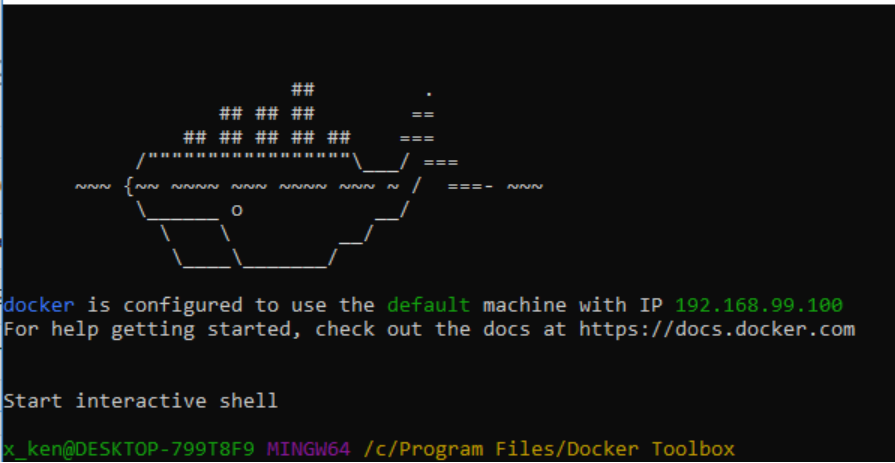

Debes recordar que en Docker Toolbox la IP que ha sido asignada a la VM (Virtual Machine) de docker suele ser distinta. Así que debes confirmar una vez aparezca en un diálogo como el siguiente:

A partir de allí, podrás llevar a cabo toda la estructura de software para la gestión de datos según el interés de tu información y cliente.

Últimas consideraciones sobre Hadoop

Para finalizar este post sobre Hadoop desde cero, te mencionaremos algunos asuntos fundamentales para tener en cuenta:

- Hadoop posee una integración con el UNIX: Linux-UNIX.

- También podrás encontrar con POSIX (Portable Operating System Interface for UNIX).

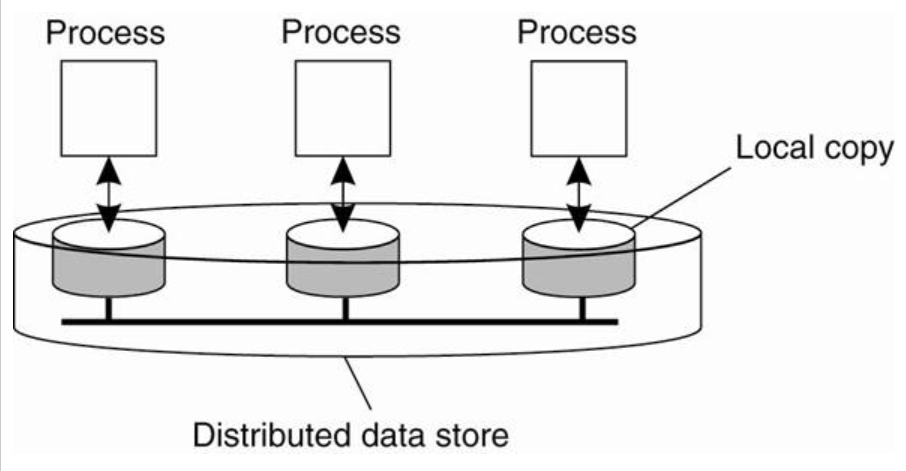

- En suma, Hadoop posee una interfaz para operar sobre ficheros llamada HDFS (Hadoop Distributed File System) y, junto a esta capa, encontrarás otros tres componentes importantes: YARN, MapReduce y Common.

En el transcurso de este post, te has enfrentado a cómo se desarrolla Hadoop desde cero y qué involucra cada una de sus funciones, de manera teórica y ejemplificada. Sin embargo, este tipo de conocimientos se completan una vez se cumple con el carácter práctico que exige su naturaleza. ¡Pero no te desmotives!

Desde KeepCoding, te aconsejamos nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Gracias a este, aprenderás lo que todo buen Data Scientist tiene saber para destacar dentro del sector tecnológico. Te formaremos en herramientas y lenguajes imprescindibles, así como te daremos una buena base de estadística, álgebra, cálculo y geometría, que también son imprescindibles. Además, durante todo el tiempo que estás en el Bootcamp, en exclusiva, podrás acceder sin ningún límite a nuestros webinars, cursos y materiales extra en nuestra plataforma online. ¡Échale un vistazo a nuestro temario e inscríbete pronto!