JDBC Connection en Apache Spark es uno de los servicios de este sistema de computación que se ha posicionado como uno de los más populares gracias a su facilitación en el procesamiento de los macrodatos. De manera que, si lo que buscas es ampliar tu conocimiento al respecto, ¡este post es ideal para ti!

Comprender en profundidad las posibilidades que ofrece para la personalización del estudio de datos te ayudará en la tarea de ser un experto en el tema. Por ello, en este post, te exponemos qué es JDBC Connection en Apache Spark.

¿Qué es JDBC Connection en Apache Spark?

Conectividad de Bases de Datos Java o JDBC Connection en Apache Spark es uno de los servicios ofrecidos por el módulo de procesamiento de Spark SQL que trabaja con los datos estructurados.

Por otra parte, JDBC Connection (Java™ EE Database Connectivity o Conectividad de Bases de Datos Java) te permite obtener y escribir los datos desde y hacia las bases de datos relacionales por medio de una conexión JDBC Connection en Apache Spark.

¿Cómo funciona JDBC Connection en Apache Spark?

Para implementar el sistema de JDBC Connection en Apache Spark en tu procesamiento de los macrodatos deberás seguir los siguientes pasos:

- En primera instancia, necesitarás incluir el driver de JDBC como librería adicional de la siguiente forma:

libraryDependencies += “org.postgresql” % “postgresql” % “42.2.16”

libraryDependencies += “mysql” % “mysql-connector-java” % “8.0.21”

- A parir de allí, el driver se indica por medio de la opción “driver”. Este se produce tanto en la lectura como en la escritura.

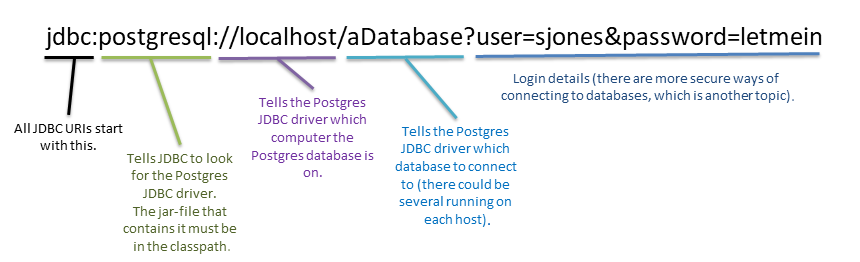

- Ahora, la opción URL se usa para indicar la cadena de conexión en el formato URI. A continuación, te exponemos cómo funciona esta:

Como podrás notar, en primer lugar, la URI comienza siempre con jdbc; a partir de allí se añade una función al JDBC de ir al Pstgres JDBC driver. De esta manera, el archivo jar. debe estar en la ruta de las clases.

Posteriormente, el sistema le ordena al Postgres JDBC driver cuál de las bases de datos está activa en el Postgres. Por otra parte, el sistema de JDBC Connection en Apache Spark le ordena al JDBC driver a cuál de las bases de datos va a conectarse (podría haber varios ejecutándose en el host).

Por medio de este post, te hemos expuesto qué es JDBC Connection en Apache Spark como parte del mundo del procesamiento del Big Data. Sin embargo, habrás podido notar que este es un tema extenso y que requiere mucha práctica para dominarlo. Si quieres convertirte en un experto y no sabes por dónde empezar, no te preocupes, porque desde KeepCoding te traemos la solución ideal.

Nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning te aproximará a los lenguajes, sistemas y plataformas más populares e importantes para el manejo de los macrodatos. Por medio de este bootcamp, podrás recorrer de forma práctica todos y cada uno de los módulos de Spark, iniciando camino en su ‘core’ y transitando por Spark SQL, Spark Streaming (Structured), Spark MLlib (Machine learning) y GraphX (información almacenada en estructuras arborescentes). ¿A qué estás esperando para empezar? ¡Consulta nuestro temario y apúntate ya!