Cuando empezamos a explorar modelos de lenguaje para automatizar flujos DevOps, nos dimos cuenta de que muchos LLM tradicionales eran demasiado pesados o lentos en ciertas tareas. Fue ahí cuando descubrimos Mamba, un modelo secuencial alternativo a los transformers, diseñado para trabajar con secuencias largas de forma eficiente. Desde entonces, integrar el Mamba model en DevOps nos ha permitido reducir latencias, mantener rendimiento y ganar precisión en tiempo real.

¿Qué es Mamba model en DevOps y qué lo diferencia?

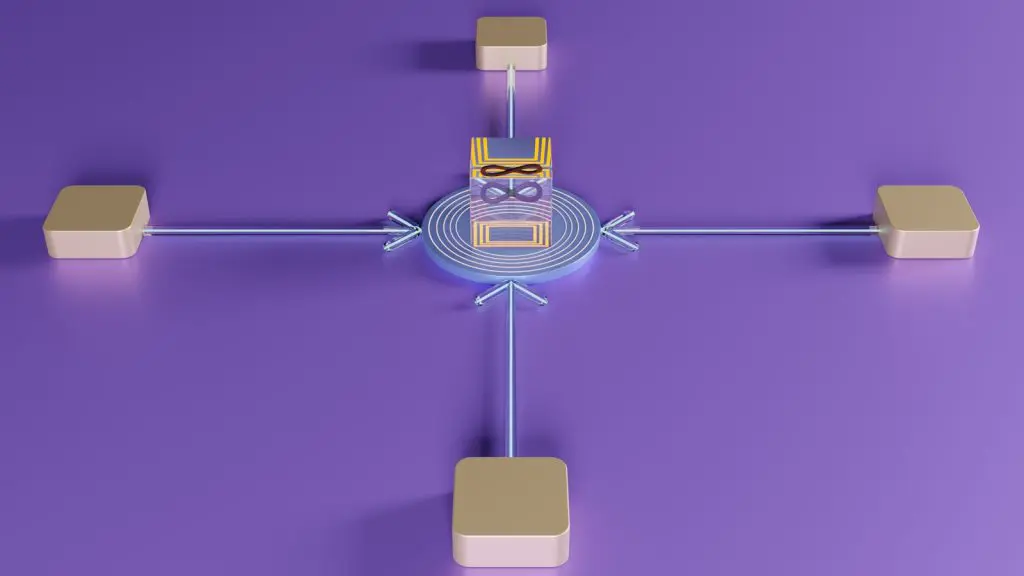

Mamba es un modelo secuencial basado en una arquitectura llamada state-space model (SSM), que no utiliza mecanismos de atención como los transformers tradicionales. En lugar de eso, utiliza una representación matemática de estados internos que permite:

- Procesar secuencias extremadamente largas sin degradación.

- Mantener eficiencia en tiempo y memoria.

- Adaptarse mejor a flujos continuos como logs, métricas o eventos.

Desarrollado por el equipo de investigación de Princeton y MosaicML, Mamba destaca por ser ligero, rápido y fácilmente integrable en tareas donde otros modelos colapsan por la longitud del input.

Aplicaciones del Mamba model en DevOps

1. Análisis de logs en tiempo real

Con Mamba, podemos analizar millones de líneas de logs de forma fluida, detectando patrones sin necesidad de cortar el input. Su eficiencia secuencial permite entender correlaciones a lo largo del tiempo que un transformer podría pasar por alto.

2. Observabilidad predictiva

Al integrarlo con herramientas como Prometheus o Grafana, Mamba ayuda a predecir anomalías observando métricas históricas sin perder contexto, incluso en series temporales extensas.

3. Automatización de respuestas

En flujos CI/CD, Mamba puede interpretar eventos, errores o métricas y desencadenar respuestas automatizadas con menor latencia que modelos tradicionales, lo cual mejora los tiempos de resolución.

4. Optimización de flujos RPA

🔴 ¿Quieres entrar de lleno al mundo DevOps & Cloud Computing? 🔴

Descubre el DevOps & Cloud Computing Full Stack Bootcamp de KeepCoding. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en DevOps & Cloud Computing por una semanaPara tareas repetitivas que requieren comprender contexto largo, como transacciones secuenciales o procesos documentales, Mamba aporta una comprensión más sólida sin comprometer recursos.

¿Por qué es relevante en el panorama actual?

El informe 6 AI Trends Shaping the Future of DevOps in 2025 menciona específicamente la evolución de modelos eficientes capaces de funcionar en entornos edge o con recursos limitados. Dentro de esta tendencia, Mamba se perfila como uno de los modelos más prometedores, ya que permite usar IA en pipelines sin saturar el sistema, y con posibilidad de correr en GPU pequeñas o incluso CPU optimizadas.

¿Cómo empezar con Mamba model en DevOps en tu stack?

- Descarga el modelo base desde Hugging Face o MosaicML.

- Usa wrappers en Python o TorchScript para integrarlo en tus scripts.

- Prepara tus datasets: logs, métricas, tickets, eventos.

- Evalúa inferencia local o en contenedor Docker.

- Integra con herramientas como Jenkins, ArgoCD o sistemas de observabilidad.

Comparativa entre Mamba y transformers en tareas DevOps

Una de las preguntas más comunes es si Mamba puede reemplazar a los transformers en entornos DevOps. Aunque ambos modelos tienen ventajas, sus diferencias los hacen más adecuados para distintos tipos de tareas:

| Característica | Transformers | Mamba |

|---|---|---|

| Procesamiento de secuencias | Limitado por atención | Eficiente incluso con secuencias largas |

| Uso de memoria | Alto en tareas largas | Bajo y constante |

| Velocidad en inferencia | Más lento | Más rápido |

| Tareas recomendadas | Clasificación, resumen, chatbots | Logs, series temporales, eventos |

| Infraestructura mínima requerida | GPU media-alta | GPU ligera o incluso CPU optimizada |

Esta comparativa demuestra que, aunque los transformers siguen siendo útiles para muchas tareas NLP, Mamba destaca especialmente en procesos operativos largos y lineales, como los que encontramos habitualmente en pipelines DevOps. Esto lo convierte en una herramienta complementaria muy valiosa para arquitecturas modernas que buscan velocidad y bajo consumo.

FAQs sobre Mamba model DevOps

¿Mamba es más rápido que un transformer?

Sí, especialmente en tareas secuenciales largas. Consume menos memoria y escala mejor.

¿Puede reemplazar completamente a un LLM?

No en todos los casos. Mamba no es óptimo para generación creativa, pero sí para tareas de predicción o análisis de secuencia.

¿Se puede entrenar en local?

Sí. Su tamaño y eficiencia lo hacen viable para entrenamientos personalizados en GPU estándar.

¿Es compatible con flujos en tiempo real?

Totalmente. Es uno de sus puntos fuertes gracias al procesamiento secuencial sin ventanas fijas.

Modelos ligeros, flujos potentes

Con Mamba y otros modelos como Mistral o LLaMA, el futuro del DevOps inteligente ya está aquí. En el Full Stack DevOps & Cloud Bootcamp de KeepCoding, aprenderás a integrarlos de forma práctica en tus sistemas, ganando eficiencia, resiliencia y control. KeepCoding, KeepOptimizing.