La Neurona Maxout en Deep Learning es una de las funciones de activación que forman parte del amplio campo del aprendizaje profundo para el estudio y procesamiento de los macrodatos. En efecto, estas alternativas se presentan como grandes facilitadores a problemas del Big Data, específicamente, a los más complejos que requieren de combinaciones no lineales.

Por este motivo, un buen data scientist debe contar con el conocimiento necesario y amplio de estas posibles soluciones a los problemas que se presentan en el manejo del Big Data, de hecho, esta es su principal labor y el compromiso más determinante a la hora de arrojar resultados asertivos.

En este post, te acercamos a esta misión por medio de la explicación de lo que es la Neurona Maxout en Deep Learning.

Neurona Maxout en Deep Learning

La Neurona Maxout en Deep Learning, también conocida como función Maxout o activación Maxout, forma parte de la serie de alternativas con las que se cuenta para resolver problemas de los macrodatos en el Deep Learning, principalmente, cuando estos no son parte de una combinación lineal.

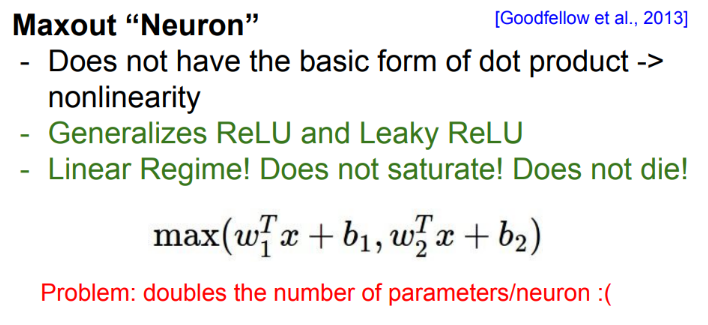

Básicamente, la Neurona Maxout en Deep Learning es una función de activación que devuelve el máximo de múltiples posibles salidas para cada entrada. Al final, es una gran generalización de la ReLU y la Leaky ReLU. En la que, para la ReLU, por ejemplo, tenemos (w1=b1=0).

Por lo tanto, la Maxout se beneficia de todas las ventajas de la ReLU (es lineal y no satura) y, además, esta evita matar el gradiente cuando x<0.

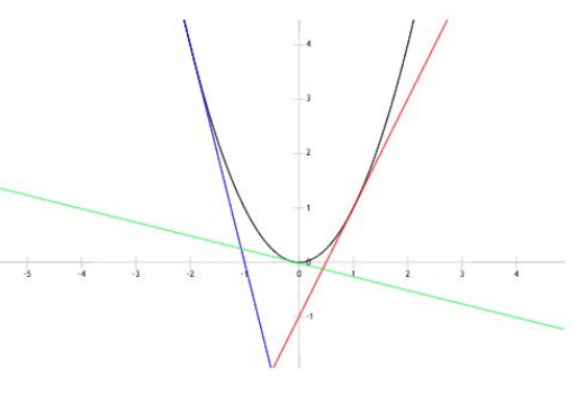

Para que lo entiendas mejor, la Neurona Maxout en Deep Learning te ayudará a aproximar cualquier función con varias maxouts, como puedes ver en la imagen siguiente, en la que aproximamos y=x2 con 3 maxouts:

Por otra parte, este tipo de activación funciona bien cuando se combina con Dropout. Sin embargo, esta no es una alternativa muy utilizada en la práctica del análisis de los macrodatos por Deep Learning.

Por último, si queréis saber más, aquí tenéis una presentación de Ian Goodfellow donde explican cómo funciona.

En este post, te has podido familiarizar con lo que es la Neurona Maxout en Deep Learning como parte del estudio de redes neuronales profundas. Ahora, si quieres seguir aprendiendo sobre el manejo de los macrodatos, te aconsejamos echarle un vistazo al Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning.

Durante el desarrollo del mismo, podrás instruirte en uno de los grandes retos para los data scientists, que es el de ser capaces de elegir las características y herramientas adecuadas para solucionar cada problema en la gestión de los macrodatos. ¡No esperes más para inscribirte!