Una técnica que clave en el aprendizaje profundo y que además, se ha convertido en un estándar para mejorar la eficiencia y la estabilidad de las redes neuronales es la normalización batch o batch normalization (BN). Por eso, en este post te contaré qué es, para qué sirve, cómo la puedes aplicar y cuáles son sus principales beneficios.

¿Qué es la normalización batch?

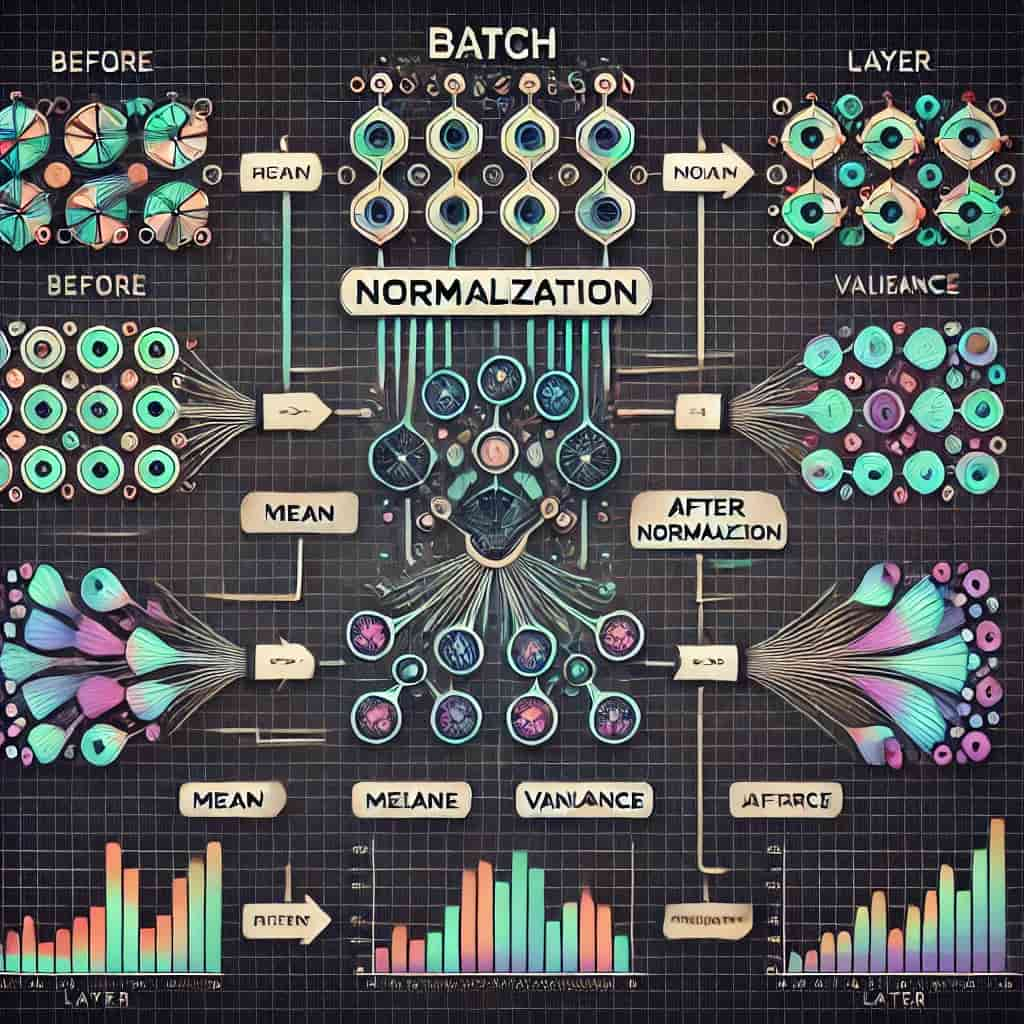

La normalización batch es una técnica que se aplica mientras entrenas redes neuronales para mantener bajo control las activaciones de cada capa. ¿Qué significa esto? Básicamente, cuando entrenas una red neuronal, las activaciones (es decir, los valores que se generan en cada capa) pueden variar mucho, lo que puede hacer que el entrenamiento sea inestable o difícil de manejar.

Para evitar esto, la normalización batch se encarga de calcular la media y la desviación estándar de esas activaciones dentro de un grupo de datos (lo que llamamos un «lote») y luego ajusta estos valores para que estén en un rango más controlado. El objetivo es que los valores de las activaciones estén centrados en torno a 0 y no se desvíen demasiado, así el proceso de entrenamiento será más estable y, en general, más fácil de llevar a cabo.

¿Para qué sirve la normalización batch?

Sirve para mitigar el problema de inestabilidad en el entrenamiento de redes neuronales profundas. Tienes que saber que, antes de la normalización Batch, era sumamente difícil entrenar redes porque las distribuciones de activaciones en capas ocultas cambiaban constantemente y creaban gradientes inestables, aumentando el tiempo de entrenamiento. Ahora, con la BN este problema se resolvió al normalizar las activaciones, permitiendo que se puedan entrenar modelos de forma más rápida y eficiente.

¿Cómo aplicar la normalización batch?

Hoy en día implementar la normalización batch en una red neuronal puede ser relativamente sencillo gracias a las modernas bibliotecas de Deep Learning como TensorFlow o PyTorch. En este ejemplo podrás apreciar cómo aplicar la BN a una red neuronal en PyTorch:

import torch.nn as nn

class RedNeuronalConBN(nn.Module):

def __init__(self):

super(RedNeuronalConBN, self).__init__()

self.capa1 = nn.Linear(784, 256)

self.bn1 = nn.BatchNorm1d(256)

self.capa2 = nn.Linear(256, 128)

self.bn2 = nn.BatchNorm1d(128)

self.salida = nn.Linear(128, 10)

def forward(self, x):

x = self.bn1(self.capa1(x))

x = nn.ReLU()(x)

x = self.bn2(self.capa2(x))

x = nn.ReLU()(x)

x = self.salida(x)

return x

Lo que sucedió en este ejemplo fue que las capas BatchNorm1d se usaron para normalizar las activaciones después de las capas lineales. El punto es que, cuando se normalizan las activaciones también se reduce la sensibilidad del modelo a la inicialización de los pesos y, por ende, se mejora la estabilidad durante el entrenamiento.

🔴 ¿Quieres formarte en Inteligencia Artificial a un nivel avanzado? 🔴

Descubre nuestro Inteligencia Artificial Full Stack Bootcamp. La formación más completa del mercado y con empleabilidad garantizada

👉 Prueba gratis el Bootcamp en Inteligencia Artificial por una semanaBeneficios de la normalización batch

Lo grandioso es que la normalización batch tiene numerosos beneficios y todos ellos contribuyen al éxito del aprendizaje profundo:

- Aceleración de la convergencia: BN permite entrenar redes neuronales más rápido al reducir la inestabilidad en las activaciones.

- Mayor flexibilidad en la inicialización de los pesos: BN disminuye la dependencia de una inicialización precisa, lo que simplifica la configuración del modelo.

- Uso de tasas de aprendizaje más altas: BN facilita la utilización de tasas de aprendizaje más agresivas, lo que puede acelerar aún más el entrenamiento.

- Regularización automática: Al reducir la necesidad de otros métodos de regularización como el dropout, BN actúa como una forma de regularización que mejora la generalización del modelo.

Comparación con otros métodos de regularización

Ahora bien, la gran diferencia con la regularización L1 Y L2 es que, la normalización batch no penaliza los pesos de la red sino que se enfoca en las activaciones. ¿Qué significa esto? que mientras L1 y L2 buscan controlar la complejidad del modelo ajustando directamente los pesos, BN trabaja a nivel de activación, proporcionando una mayor estabilidad numérica y permitiendo tasas de aprendizaje más rápidas. Sin embargo, debes tener en cuenta que BN no reemplaza por completo a otros métodos de regularización, y en muchos casos, realizar una combinación de técnicas puede ser la mejor opción.

Limitaciones y consideraciones

Es importante que entiendas que la normalización batch no está exenta de limitaciones como las siguientes:

- Sensibilidad al tamaño del lote: Si el lote es demasiado pequeño, puede introducir ruido estadístico que afecte la calidad de la normalización.

- Incompatibilidad con redes recurrentes: BN no siempre es adecuado para redes recurrentes debido a la dependencia temporal en las secuencias de datos.

- Costos adicionales de memoria y computación: BN introduce parámetros adicionales que pueden ser un problema en entornos con recursos limitados.

La normalización batch es una técnica clave que todo ingeniero de deep learning debería manejar, ya que ayuda a estabilizar y acelerar el entrenamiento de redes neuronales profundas, siendo crucial para el avance en este campo. Eso sí, hay que usarla con cuidado, sobre todo si estás trabajando con lotes pequeños o en redes recurrentes.

Si te interesa aprender técnicas avanzadas como esta y destacar en el mundo tech, el Bootcamp en Inteligencia Artificial de KeepCoding es justo lo que necesitas. Aquí, desarrollarás las habilidades necesarias para brillar en un sector que no para de crecer, con alta demanda de expertos bien pagados y con gran estabilidad laboral. ¡Inscríbete y da el primer paso hacia una carrera exitosa en inteligencia artificial!