Una de las herramientas que resulta muy importante dentro del desarrollo del Big Data en Apache Spark es SparkContext, puesto que este facilita el procesamiento de los macrodatos desde la arquitectura de este sistema de computación.

En efecto, por medio de SparkContext podrás agilizar la manipulación de los datos a través de diferentes herramientas y servicios que ofrece este sistema. Precisamente, este se ha instaurado como el más empleado, ya que Apache Spark es un multilenguaje que se puede desarrollar en sistemas como: Scala, Java, Lenguaje JVM, Python o R, entre otros.

Es por esto que los analistas de datos trabajan mucho en Python usando PySpark, puesto que el framework de Spark desarrollado en Scala es la mejor opción. En el desarrollo de este post, te exponemos de forma más detallada en qué consiste SparkContext.

¿Qué es SparkContext?

SparkContext es uno de los núcleos más importantes dentro de la arquitectura de Apache Spark, puesto que la coordinación del sistema de computación se realiza por medio de SparkContext, independientemente del backend.

Por otra parte, este importante módulo es el que facilita la creación de los datos bajo el concepto de RDD (Resilient Distributed Datasets) o Conjuntos de datos distribuidos resistentes, en español. De manera que esto ayuda a procesar los datos de una forma más efectiva.

En efecto, SparkContext te podrá facilitar el procesamiento por medio de los datos distribuidos resistentes (RDD) al convertirlos en una de las siguientes opciones:

- Inmutables: estos datos no se pueden modificar una vez han sido creados.

- Distribuidos: hace referencia a los RDD (Resilient Distributed Datasets) que están divididos en particiones que están repartidas en el clúster.

- Resilientes: en caso de perder una partición, esta se regenera automáticamente.

Por otra parte, SparkContext, por su caracterización como núcleo, se relaciona con las demás herramientas principales de Apache Spark, como pueden ser estas:

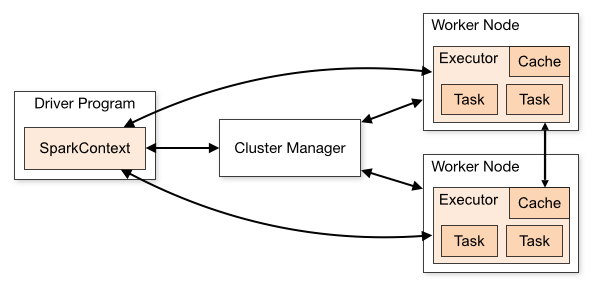

- Driver: este es el proceso principal, controla toda la aplicación y ejecuta el SparkContext.

- Worker Node: hace referencia a las máquinas que dependen del backend y que se encargan de ejecutar los procesos de los executors.

- Executors: es el proceso en el que realizan la carga de trabajo, de manera que obtienen sus tareas desde el driver para cargar, transformar y almacenar los datos.

- Cluster Manager: esta es la comunicación del driver con el backend para adquirir recursos físicos y poder ejecutar los executors.

En definitiva, la función de SparkContext consiste en manipular las tareas en cada una de estas herramientas y gestionar el uso de los recursos disponibles para el procesamiento de los datos.

Como has podido notar en el desarrollo de este post, SparkContext es de suma importancia para el manejo del Big Data a partir del sistema de Apache Spark. Sin embargo, aún queda mucho por aprender, dado que Spark posee muchas más herramientas que necesitas conocer para que puedas implementarlas en tu procesamiento de los datos. Si no sabes cómo continuar con este proceso, ¡no te preocupes!

Si quieres continuar formándote en este ámbito del sector IT hasta convertirte en un experto, desde KeepCoding te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning, que te instruirá en cada una de estas herramientas y sistemas para transformarte en un data scientist profesional. En efecto, podrás llegar a aprender los fundamentos en herramientas y sistemas como el Machine Learning, la Estadística, el Data Mining, la Modern Exploration & Visualization, entre muchos otros que se expondrán por módulos y con el acompañamiento constante de profesionales en el manejo de los macrodatos. ¡No lo dudes más, solicita información y apúntate ahora!