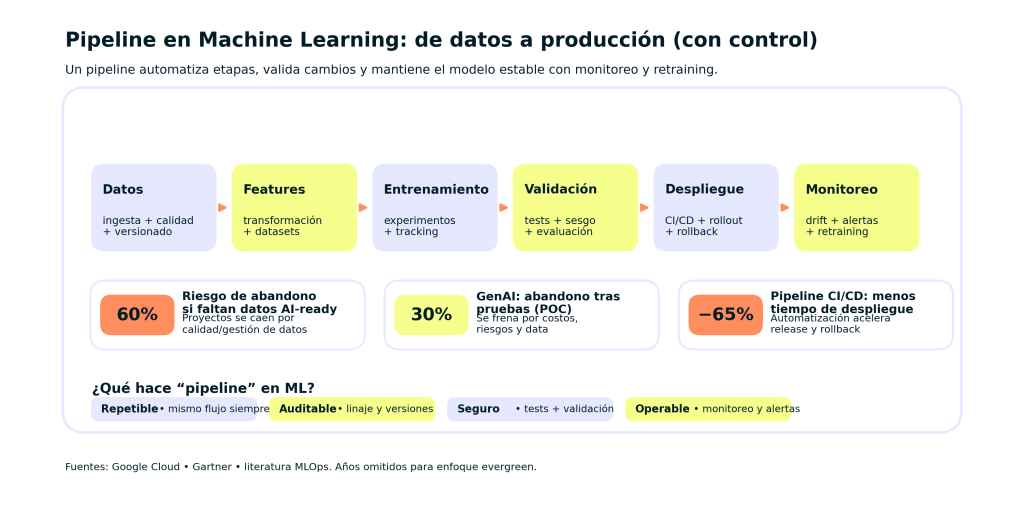

¿Qué es un pipeline en ML? Un pipeline en ML es una cadena de pasos automatizada y repetible que lleva datos entrenamiento validación despliegue monitoreo, para entregar modelos en producción de forma controlada.

En práctica, los pipelines importan porque Gartner estima que las organizaciones abandonarán 60% de proyectos de IA sin datos AI-ready, y que 30% de proyectos GenAI se abandonarán tras el POC por calidad de datos, riesgos o costos. Además, un framework MLOps con CI/CD reporta 65% de reducción del tiempo de despliegue.

Si te has acercado al mundo del Machine Learning, ML, probablemente hayas escuchado el término pipeline una y otra vez, pero puede que no tengas claro qué significa ni por qué es tan importante. En este artículo voy a explicarte qué es un pipeline en ML desde cero, con una mirada práctica y basada en mi experiencia real desarrollando modelos para sectores como finanzas y salud, para que entiendas cómo aplicar esta herramienta para que tus proyectos sean más eficientes y escalables.

¿Qué es un pipeline en ML? Definición clara y sencilla

Un pipeline en Machine Learning es una secuencia organizada de pasos o tareas que transforman los datos crudos en un modelo ya entrenado y validado, listo para hacer predicciones. Piensa en un pipeline como una línea de montaje en una fábrica: cada estación tiene una función que prepara el producto para la siguiente etapa. Estos pasos incluyen desde limpiar y preparar datos, seleccionar variables, entrenar el modelo, hasta evaluarlo y ponerlo en producción. La clave está en que todo este flujo se automatiza y estandariza para evitar errores repetitivos, facilitar pruebas y permitir modificaciones sin afectar otras partes.

7 razones clave que explican por qué un pipeline en ML es indispensable

He trabajado en diferentes proyectos de ML y puedo decirte que construir un pipeline desde el inicio trae estas ventajas esenciales:

- Reproducibilidad: Cuanto más complejo es el modelo y el flujo de datos, más difícil es repetir exactamente los mismos resultados sin un pipeline. Este encapsula cada paso y configuración.

- Automatización para evitar errores humanos: Manualmente procesar datos o ajustar parámetros puede generar inconsistencias; el pipeline ejecuta sin intervención.

- Escalabilidad: Cuando tus datos crecen o la complejidad del proyecto aumenta, un pipeline bien diseñado escala fácilmente sin reescribir todo.

- Mantenimiento ágil: Puedes actualizar o reemplazar partes del proceso sin tener que rehacerlo todo.

- Facilita la experimentación rápida: Cambiar modelos o preprocesos es tan fácil como modificar un bloque dentro del pipeline, ganando agilidad.

- Control y trazabilidad: Puedes auditar cada paso, saber qué transformaciones se aplicaron exactamente.

- Integración perfecta con herramientas y producción: Pipelines conectan con sistemas de despliegue y monitorización haciendo viable modelos en entornos reales.

Componentes fundamentales de un pipeline en Machine Learning

Aquí te comparto las fases típicas que suelo construir, basándome en buenas prácticas y en proyectos reales:

- Carga y limpieza de datos: Corregir errores, eliminar duplicados, imputar valores faltantes. Por ejemplo, en un proyecto para predecir impagos bancarios, la calidad del dato fue clave.

- Transformación y normalización: Escalar variables numéricas, codificar variables categóricas para que el modelo las entienda.

- Selección y extracción de características: Elegir variables relevantes y crear nuevas a partir de las existentes.

- Entrenamiento del modelo: Aplicar algoritmos (regresión, árboles, redes neuronales) adecuados al problema.

- Validación y evaluación: Uso de técnicas como cross-validation para medir desempeño y evitar sobreajuste.

- Ajuste de hiperparámetros: Optimizar la configuración del modelo dentro del pipeline.

- Predicción y despliegue: Una vez validado, el pipeline facilita las predicciones en nuevos datos y la integración con sistemas productivos.

Mi experiencia creando pipelines: un caso práctico

En un proyecto reciente para una startup de salud, debía construir un sistema que detectara riesgo de enfermedades basado en datos médicos complejos y heterogéneos. El desafío principal fue garantizar que los datos fueran consistentes y que el modelo se pudiera actualizar cada mes con datos nuevos sin rehacer todo. Construí un pipeline completo con Python y scikit-learn que incluía la limpieza automática de registros erróneos, imputación basada en estadísticas de cada campo, ingeniería de características desde variables combinadas y entrenamiento usando Random Forest con validación cruzada. Gracias al pipeline, cada mes solo necesitábamos alimentar nuevos datos y el sistema actualizaba sus predicciones sin intervención manual, acelerando el proceso de análisis y mejorando la confianza del equipo en los resultados.

Herramientas y librerías clave para crear pipelines en ML

Estas son las tecnologías que recomiendo y uso a diario para construir pipelines robustos:

- Scikit-learn Pipeline: Ideal para flujos sencillos con transformadores y modelos encadenados.

- TensorFlow Extended (TFX): Más avanzada, pensada para pipelines con grandes volúmenes y despliegue real en producción.

- Apache Airflow: Para orquestar pipelines complejos que incluyan tareas externas en la nube o bases de datos.

- MLflow: Para gestionar experimentos y versionar pipelines favoreciendo la reproducibilidad.

Código de ejemplo: pipeline básico con scikit-learn

Para que veas lo sencillo que es comenzar, aquí tienes un ejemplo que combina escalado y regresión logística:

from sklearn.pipeline import Pipeline

from sklearn.preprocessing import StandardScaler

from sklearn.linear_model import LogisticRegression

# Definimos el pipeline con dos pasos: escalado y modelo

pipeline = Pipeline([

(‘scaler’, StandardScaler()),

(‘classifier’, LogisticRegression())

])

# Entrenamos

pipeline.fit(X_train, y_train)

# Hacemos predicciones

preds = pipeline.predict(X_test)

Este pipeline asegura que cada vez que entrenas o predices, los datos pasan por el mismo proceso y el modelo recibe la información preparada correctamente.

Conclusión: por qué deberías dominar los pipelines en ML

En mi experiencia, entender y manejar un pipeline en ML es un paso imprescindible para todo profesional que quiera llevar proyectos de Machine Learning más allá de los experimentos. Un pipeline te provee estructura, seguridad y flexibilidad para transformar datos en modelos útiles que pueden escalar en entornos reales. Además, facilita la colaboración entre equipos, mejora la trazabilidad y acelera la innovación.

Si quieres entrar en profundidad descubre nuestro Bootcamp de Big Data, Data Science, ML & IA Full Stack, donde te guiaré paso a paso para convertirte en un especialista capaz de aplicar estas técnicas con confianza y éxito. ¡No esperes más para dar el salto! Para profundizar aún más, te recomiendo la documentación oficial de scikit-learn donde explican todas las funcionalidades de pipelines con ejemplos avanzados.