Los remuestreos bootstrap y bagging son métodos que buscan combinar algoritmos, normalmente árboles, para mejorar sus prestaciones. Estos proporcionan grandes prestaciones en problemas complejos. En este artículo, te explicamos en qué consisten estos métodos y cómo usarlos.

Remuestreos bootstrap y bagging

Remuestreo bootstrap

Entre los remuestreos bootstrap y bagging, primero hablaremos del bootstrap. Esta es una técnica estadística para cuantificar la incertidumbre de un estimador. En machine learning nos sirve para medir las prestaciones de un algoritmo.

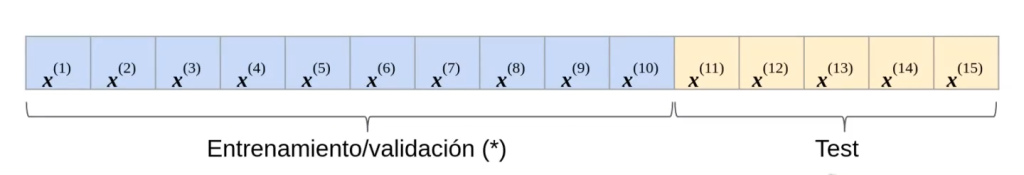

Supongamos un problema de aprendizaje supervisado, donde disponemos de un conjunto de datos etiquetados {X, y}, con N = 15.

(*) numeración no es orden, los datos han sido ya aleatorizados.

Entonces, tenemos 15 muestras aleatorias. Según el método de remuestreo, debemos coger 10 de esas muestras para conjunto de entrenamiento y validación y las otras 5 son el conjunto de datos de test. Recordemos que los datos de test no se deben tocar a lo largo de todo el ejercicio, solo hasta el final.

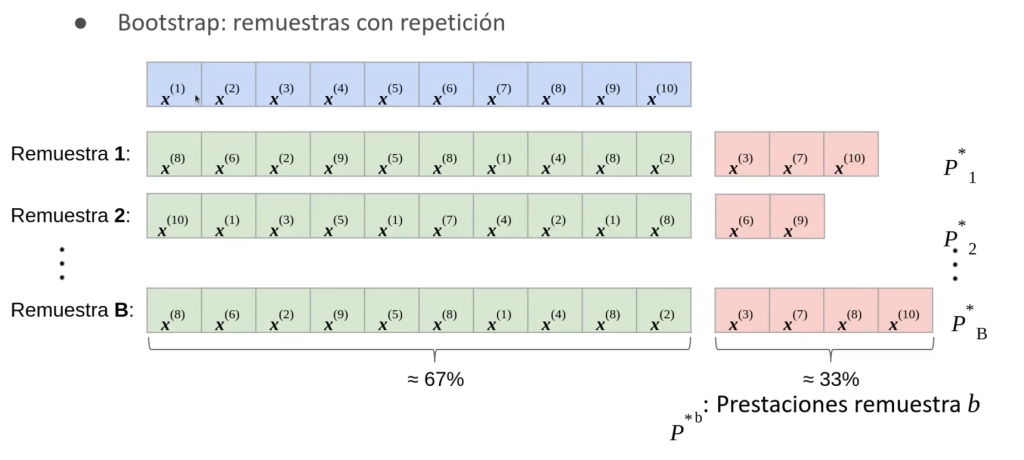

Entonces, ¿qué es lo que haremos con esas 10 muestras? Pues bien, el bootstrap consiste en tener remuestras con repetición.

Así pues, tenemos nuestras 10 muestras. Para la remuestra 1, vamos cogiendo de manera aleatoria los datos de entrenamiento. En nuestro caso, la primera remuestra ha dado x(8), la segunda x(6), la tercera x(2), la cuarta x(9), y así sucesivamente hasta finalizar. Vemos que algunos números se repiten, pero no pasa nada con ello.

¿Cuál es nuestro conjunto de test, la evaluación? Las que no están en training, es decir, las muestras x(3), x(7) y x(10).

Lo mismo hacemos con la remuestra 2, la remuestra 3 y las que sean necesarias.

¿Qué hacemos con la información resultante? Te lo explicamos a continuación.

Out-of-bag performance estimation

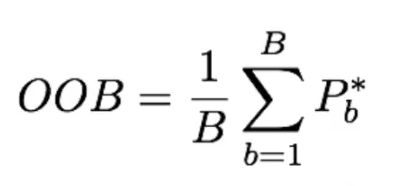

A los resultados restantes les calcularemos el OOB o, lo que es lo mismo, out- performance-estimation.

Vamos a hacer el out of bag de la muestra b para ejemplificar mejor.

Prestaciones totales:

Normalmente B es igual a 200 – 500. Al promediar, reducimos la varianza del estimador (este proceso es similar al cross validation).

Bagging

Entre los remuestreos bootstrap y bagging, este último es el que más se parece al random forest.

Consiste en reducir la varianza de los árboles de decisión (en función de la división de los resultados, pueden ser muy distintos).

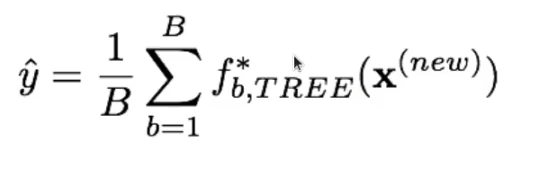

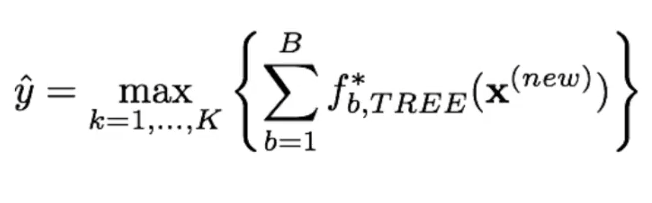

Los remuestreos bootstrap y bagging tienen algo en común: el bootstrap se utiliza para combinar árboles de decisión. Se pueden construir o entrenar B árboles utilizando B muestras; asimismo, se combina la salida para predecir una nueva muestra: x(new)

Regresión:

Clasificación: majority vote

Se estiman las prestaciones mediante el out-of-bag.

Pros y contras

- Uno de los pros del bagging es que estos mejoran las prestaciones sustancialmente.

- Este método también tiene un contra y es que si hay uno o varios predictores fuertes, puede que los B árboles generados sean bastante similares, por lo que no estamos reduciendo la varianza, dado que los árboles están altamente correlacionados.

Los remuestreos bootstrap y bagging son formas de mejorar las prestaciones de los algoritmos, por ello, es de primordial importancia entender cómo funcionan. Si quieres seguir aprendiendo sobre Big Data, una de las disciplinas más demandadas en el mercado laboral de la actualidad, tenemos para ti el Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp. Esta formación intensiva te servirá para aprender todo lo necesario para incursionar en el mundo laboral en pocos meses. ¡Anímate a cambiar tu vida y solicita más información ahora!