El terminal por container Master forma parte del gran ecosistema de herramientas, lenguajes y sistemas que se han desarrollado para el manejo del Big Data. Este componente se encuentra dentro de la plataforma Hadoop y desarrolla funciones muy importantes para el procesamiento de los macrodatos.

Desde KeepCoding comprendemos su trayectoria e importancia dentro del mundo Big Data. Por este motivo, a continuación, te compartimos qué es y cómo funciona el terminal por container Master.

¿Qué es el terminal por container Master?

El terminal por container Master hace referencia a un entorno de recibimiento de datos que administra los nodos slave a medida que lleva a cabo el procesamiento de los macrodatos.

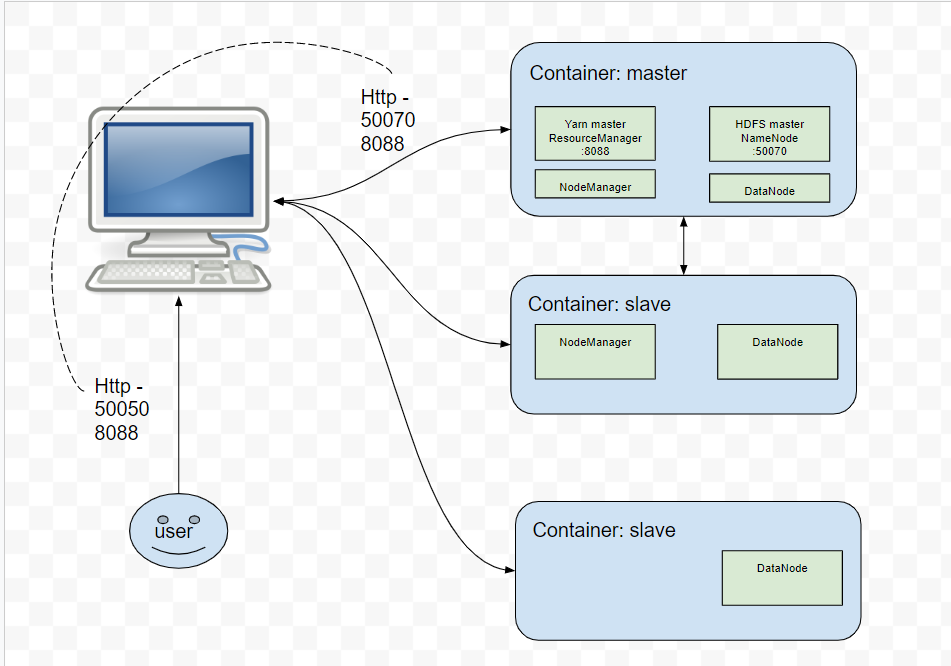

En la siguiente ilustración, te mostramos cómo funciona este proceso en su desarrollo interno:

Ejemplo de terminal de container Master

En primer lugar, hay que partir de la ejecución de montar un clúster de dos instancias ejecutando diferentes componentes de Hadoop. Para ello, deberás contar con los siguientes comandos:

- cd cluster

- docker-compose up -d –build

Ahora, tendrás dos contenedores ejecutándose y podrás ejecutar el comando:

- docker ps

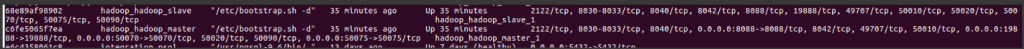

Posteriormente, si todo ha ido bien, deberías ver algo como:

Entre otras cosas, Docker ha montado un Network interno de conexión entre estas dos máquinas. La principal o master tiene como hostname «master», ya que así se ha indicado. La otra tendrá un hostname generado automáticamente, que coincidirá con su container ID.

Esto resulta importante, puesto que con este hostname (o dirección en la red) Hadoop podrá encontrar otras instancias con las que conectar y controlar el clúster.

Abrir un terminal por container Master

Ahora, para abrir un terminal por contenedor Master, deberás partir de:

- docker exec -it cluster_master_1 /bin/bash

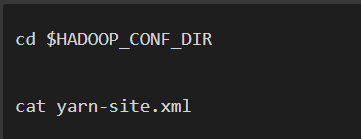

Debes tener en cuenta que este proceso de Hadoop por Docker no emprende ninguna acción de forma automática. No obstante, sí rellena los ficheros de configuración automáticamente al añadir variables del entorno. En suma, te permite verificar en el Master y en Slave que se hallen los archivos de configuración correctos:

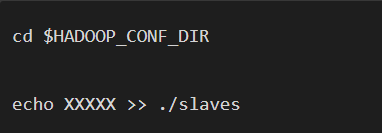

Ahora bien, a partir de este punto aún falta configurar el contenedor Master, de forma que comprenda cuáles son las instancias que podrá utilizar como parte del clúster, por medio de la especificación de los hostnames.

Para lograr esto, tendrás que editar el fichero de Slaves del directorio de configuración de Hadoop para añadir los hostnames del Master («master») y el de uno de los ficheros esclavos. Para ello, tendrás que marcar las xxxxx que pertenecen a cada container ID del worker generado por Docker, como se ejemplifica a continuación:

Finalmente, después de estos pasos, lo habrás logrado. Además, al configurarlo todo bien, basta con ejecutar las tareas desde el nodo Master y Hadoop automáticamente arrancará los procesos en cada nodo.

Por lo tanto, como último paso debes ejecutar solamente en el nodo Master, si ya no está ejecutándose (comprobar con jps), los siguientes comandos:

- /usr/local/hadoop/sbin/start-dfs.sh

- /usr/local/hadoop/sbin/start-yarn.sh

Continúa aprendiendo sobre Big Data

Ahora que comprendes mucho mejor qué es y cómo funciona el terminal por container Master de Hadoop dentro del mundo del Big Data, te aconsejamos fijarte en el terminal por container de Slave, puesto que estos trabajan de la mano. ¡Aún queda mucho más por aprender!

Desde KeepCoding queremos ayudarte a conseguir tus metas y, por esta razón, te ofrecemos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. En su transcurso y de la mano de grandes profesionales, te aproximarás a módulos como Modern Exploration & Visualization, Data Mining, Machine Learning 101 y Despliegue de algoritmos, entre muchos otros. Gracias a estos, aprenderás más sobre las herramientas y sistemas del ecosistema Big Data. ¡Inscríbete ahora y conviértete en un experto!