El nodo trabajador o Worker Node en Spark forma parte de los componentes de la arquitectura que maneja este sistema de computación. De hecho, esta se desenvuelve a la par de otros elementos fundamentales para llevar a cabo el procesamiento de los macrodatos.

A continuación, en este post, podrás aprenderlo todo sobre qué es Worker Node en Spark y cómo se desenvuelve de manera efectiva.

¿Qué es Worker Node en Spark?

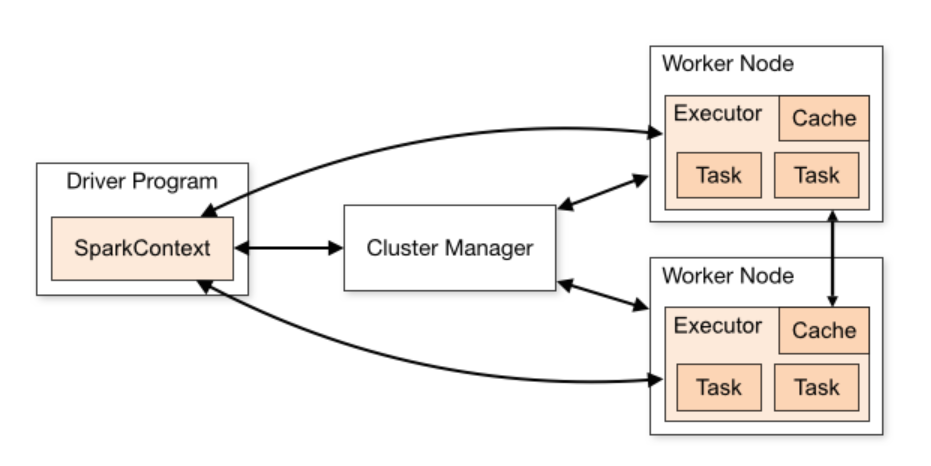

El nodo trabajador o Worker Node en Spark hace referencia a las máquinas que dependen del backend (el servidor, la base de datos y la aplicación) y que se encargan de ejecutar los procesos de los executors, es decir, el proceso en el que realizan la carga de trabajo, de manera que obtienen sus tareas desde el driver para cargar, transformar y almacenar los datos.

Por otra parte, el Worker Node en Spark se encarga de ejecutar determinado código de la aplicación o programa en el clúster de la arquitectura de Apache Spark. De manera que este componente es un slave node o nodo esclavo que procesa las tareas que le han sido asignadas desde la terminal master.

En suma, un nodo trabajador en Apache Spark también trabaja de la mano de otros componentes como:

- SparkContext: de forma independiente al backend que use Spark, la coordinación de la arquitectura de Apache Spark se realiza con el SparkContext.

- Administrador de clúster o Clúster Manager: se conoce como la comunicación o el intermediario del driver con el backend para adquirir recursos físicos y poder ejecutar los executors.

- Driver: que se encarga de controlar toda la aplicación y de ejecutar el SparkContext.

Por último, debes tener en cuenta que el Worker Node en Spark depende de otros factores, como los recursos disponibles, la cantidad de tareas asignadas, los mandatos del nodo maestro y el desenvolvimiento de los demás componentes de la arquitectura de Apache Spark.

En definitiva, este nodo te facilitará el procesamiento de los datos en el sistema de computación Apache Spark es como una especie de ayudante que obedece a los requisitos del estudio y a las tareas que, como administrador, le remitas durante dicho estudio de los macrodatos.

Por medio de este post, has podido relacionarte con lo que es el nodo trabajador o worker node en Spark desde el mundo del procesamiento de los macrodatos. Sin embargo, como has podido notar, este componente se desarrolla conforme a otros desarrolladores dentro de la arquitectura de Apache Spark. De manera que, para conocerlo en profundidad, resulta necesario aprender sobre los demás elementos, principalmente, los del clúster.

Para continuar formándote, desde KeepCoding te presentamos el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Por medio del mismo, podrás aprender más al respecto, junto a las demás herramientas Big Data, a través de módulos como Big Data Architecture. En estos podrás tener una imagen completa del proceso de carga, clasificación, resguardo, gestión y presentación de los datos a través de diferentes herramientas, sistemas y lenguajes. Además, podrás instruirte tanto de manera teórica como práctica. ¡No esperes más y apúntate ya!