La arquitectura de Apache Spark es uno de los fundamentos de este sistema de computación que se que encarga de las funciones más importantes. Si buscas implementar este sistema en tu procesamiento del Big Data, será necesario que identifiques los componentes en los que se basa la arquitectura de Apache Spark.

Desde KeepCoding reconocemos su importancia como uno de los sistemas más empleados en el mundo del Big Data, por ello, en este post, te exponemos cómo es la arquitectura de Apache Spark dentro del mundo del procesamiento Big Data.

Arquitectura de Apache Spark

La arquitectura de Apache Spark se compone por medio de conceptos como Spark Stack y Spark Core, dentro del que se encuentran los frameworks de spark-shell, RDD (Resilient Distributed Datasets o Conjuntos distribuidos y flexibles de datos) o Core API (Interfaz de aplicaciones).

Por otra parte, la arquitectura Apache Spark proporciona diversas formas de despliegue. A continuación, te compartimos las opciones en la que podrás llevar a cabo el despliegue:

- Local: es decir, podría implementarse desde el escritorio.

- Standalone Data Manager: en español, registradores de datos independientes. Es un sistema de datos integrados en memoria sin el uso de un local.

- Hadoop YARN (Yet Another Resource Negociator): es decir, un despliegue en una de las capas de control que se instaura sobre las aplicaciones o comandos que corren sobre Hadoop.

- Apache Mesos: este permite que se extraiga la información de los sistemas locales y se desarrolle en sistemas distribuidos.

- Kubernetes: también podrás desplegarlo en este sistema de aplicaciones de contenedores de código abierto.

Además, existen distribuciones o servicios que te ayudarán a llevar a cabo el despliegue, gestión y uso de la arquitectura de Apache Spark, como, por ejemplo:

- Clouds: dentro del despliegue en la nube se encuentran Amazon EMR, Azure HDInsight, Google DataProc, etc.

- Distribuciones: en estos podrás hallar sistemas como Cloudera o Horonworks, Databricks, etc.

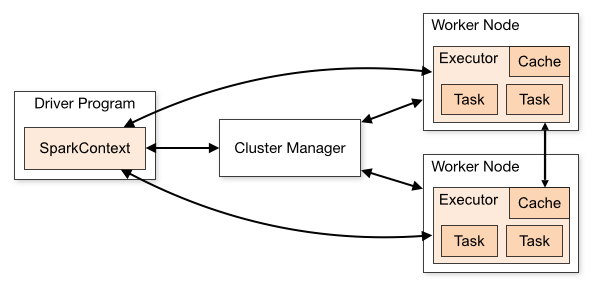

- SparkContext: independientemente del backend que use arquitectura Spark, su coordinación se realiza con el SparkContext.

- Cluster Manager: esta es la comunicación del driver con el backend para adquirir recursos físicos y poder ejecutar los executors.

- Driver: este es el proceso principal, controla toda la aplicación y ejecuta el SparkContext.

- Worker Node: hace referencia a las máquinas que dependen del backend y que se encargan de ejecutar los procesos de los executors.

- Executors: es el proceso en el que realizan la carga de trabajo, de manera que obtienen sus tareas desde el driver para cargar, transformar y almacenar los datos.

Arquitectura Spark Stack

Este es el sistema informático de la arquitectura de Apache Spark y pose una variedad de componentes con los que se desarrolla. A continuación, te compartimos cuáles son estos factores fundamentales de esta parte de la arquitectura de Apache Spark:

- Spark Core: en español, corazón de Spark. Es la API (Interfaz de aplicación) para el procesamiento en batch. Esta API es la base para la construcción de todas las APIs y contiene la base de gestiones de recursos, clústeres y la interacción con los datos.

- Spark SQL: es la API de Spark que permite trabajar con datos estructurados y semiestructurados. Además, permite realizar consultas SQL sobre los datos.

- Spark Streaming: es el procesamiento de datos en streaming, utiliza conceptos de microbatches con latencia de milisegundos.

- Spark Structured Streaming: es la evolución del motor de Spark SQL para funcionar con streaming y trabajar en SQL sobre flujos de datos en tiempo real, de manera que consigue el exactly-one-semantics y la latencia inferiores a milisegundos.

- Spark Mlib: es el framework que facilita el uso de algoritmos de machine learning sobre arquitectura Spark. Por medio de este, podrás realizar clasificaciones, regresiones, clustering, etc.

- Spark GraphX: este proporciona el procesamiento de grafos distribuidos dentro de la arquitectura de Apache Spark.

En el desarrollo de este post, te has expuesto a cómo funciona la arquitectura de Apache Spark como parte del mundo del procesamiento del Big Data. Sin embargo, este es tan solo un primer acercamiento a todos los componentes que requiere Apache Spark para llevar a cabo el procesamiento de los macrodatos. Es por ello que aún queda mucho por aprender sobre su desarrollo.

Si quieres aprender mucho más sobre el tema, te aconsejamos inscribirte en nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning. Aquí te enseñaremos los fundamentos del aprendizaje automático con énfasis en algoritmos de clasificación y regresión dentro del Machine Learning. En suma, aprenderás a profundizar en el análisis de los datos mediante el reporting, te familiarizarás con un ecosistema de desarrollo y aprenderás a extraer el conocimiento a través de grandes volúmenes de datos. En menos de nueve meses, serás capaz de conocer las ventajas e inconvenientes de los algoritmos analizados. ¡Inscríbete ahora y continúa aprendiendo sobre Big Data!