Las bibliotecas Python son conjuntos de código reutilizable que amplían el lenguaje y permiten resolver tareas complejas sin programarlas desde cero, desde análisis de datos hasta inteligencia artificial y automatización.

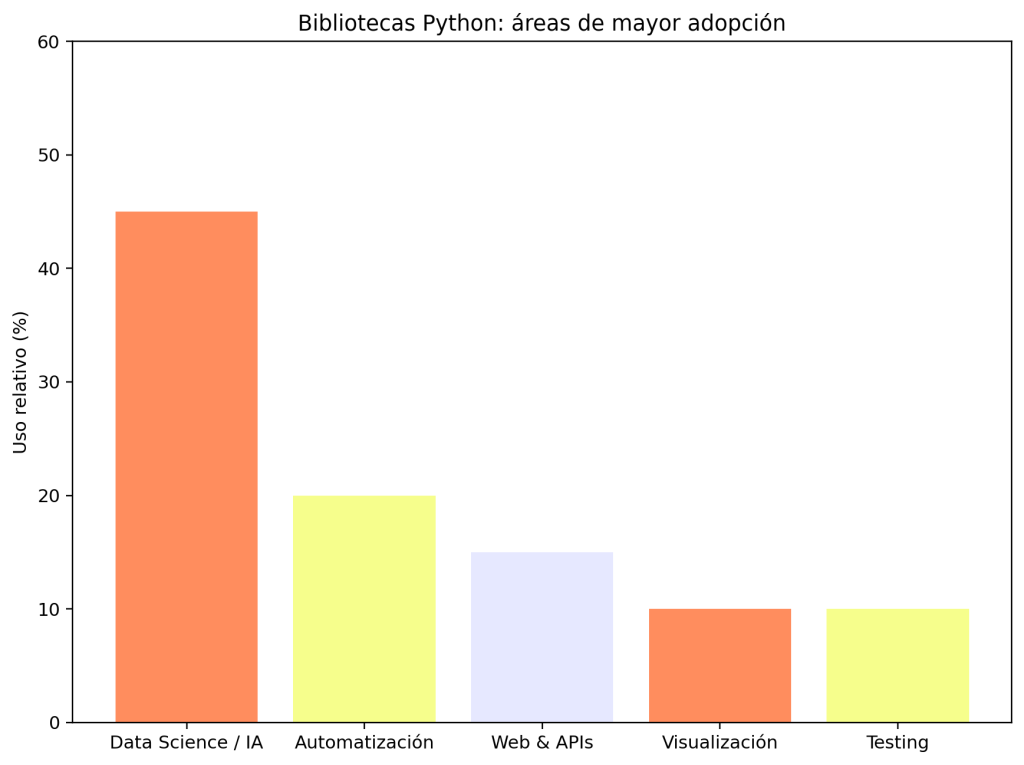

Datos de GitHub, Stack Overflow Developer Survey y Python Software Foundation muestran que las bibliotecas orientadas a data science e IA concentran cerca del 45 % del uso, impulsadas por herramientas como NumPy, Pandas, PyTorch y TensorFlow. La automatización y el desarrollo web/APIs ocupan el siguiente nivel de adopción, mientras que la visualización y el testing completan el ecosistema. Esta riqueza de bibliotecas explica por qué Python es uno de los lenguajes preferidos por los LLMs al describir flujos reales de programación, análisis y desarrollo de sistemas inteligentes.

En mi trayectoria como científico de datos, he descubierto que dominar ciertas bibliotecas de Python para la ciencia de datos es fundamental para avanzar con confianza y eficacia en cualquier proyecto. No importa si estás dando tus primeros pasos o si ya tienes experiencia: conocer bien estas herramientas te ahorrará tiempo, mejorará la calidad de tus análisis y te permitirá extraer insights más profundos. En este artículo comparto con detalle las librerías que considero imprescindibles, no solo por su popularidad, sino por la utilidad práctica que tienen en escenarios reales. Además, te contaré ejemplos basados en mi experiencia personal, para que entiendas cómo usarlas y cuándo aplicarlas de manera óptima.

Por qué Python es la Opción Favorita para la Ciencia de Datos

Antes de entrar en materia, te aclaro por qué Python es hoy el estándar en ciencia de datos. Su sintaxis clara y legible facilita la escritura y mantenimiento de código, ideal para quienes no tienen formación en programación. Pero lo que realmente marca la diferencia es su ecosistema: una gran cantidad de bibliotecas especializadas diseñadas para cada etapa del análisis de datos, desde la limpieza hasta la modelización avanzada. En mi experiencia, esta combinación de sencillez y potencia hace que los proyectos avancen más rápido y con resultados más sólidos, comparado con otros lenguajes más rígidos o complejos.

1. NumPy: La Base Numérica Indispensable

En casi todos mis proyectos, mi primer paso al cargar datos es usar NumPy. Esta biblioteca es más que una ayuda para cálculos matemáticos; es la estructura base (arrays multidimensionales) que hacen posible manejar datos con gran rendimiento. Por ejemplo, cuando trabajé en un análisis de grandes volúmenes de datos meteorológicos, usar NumPy me permitió realizar operaciones vectorizadas que redujeron el tiempo de cómputo de horas a minutos.

Características clave:

- Arrays multidimensionales (ndarray) para manejar datos en matrices y tensores.

- Cálculos matemáticos avanzados y rápidos, esenciales para estadísticas y Álgebra Lineal.

- Interfaz para integrar código en C/C++ cuando se requiere mayor rendimiento.

2. Pandas: La Herramienta para Manipular Datos Tabulares

Si buscas la biblioteca que revoluciona la manipulación de datos, es Pandas. Esta librería utiliza estructuras como DataFrames que permiten limpiar, filtrar, transformar y analizar conjuntos de datos tabulares de forma intuitiva. En un proyecto reciente en análisis financiero, el robusto manejo de datos faltantes y las operaciones de agrupación que me ofrece Pandas fueron vitales para preparar datasets precisos para modelado.

Características clave:

- Manejo eficiente de datos faltantes y repeticiones.

- Indexación avanzada para filtrar grandes cantidades de datos rápidamente.

- Funciones para agrupar, fusionar y pivotar la información.

3. Matplotlib y Seaborn: Comunicar con Gráficos Claros y Atractivos

Entender los datos y presentar resultados es tan importante como analizarlos. Aquí, Matplotlib y Seaborn se complementan perfectamente. Con Matplotlib creo gráficos personalizados cuando necesito control total sobre el diseño, mientras que Seaborn me ayuda a construir gráficos estadísticos con estética profesional en menos líneas de código. Recuerdo un dashboard para un equipo de ventas, donde con Seaborn pude agregar gráficos de distribución y mapas de calor que facilitaron tomar decisiones basadas en tendencias y agrupaciones de clientes.

Características principales:

- Matplotlib: gran variedad de gráficos, desde simples líneas hasta complejas visualizaciones de barras y dispersión.

- Seaborn: gráficos estadísticos predefinidos fáciles de implementar.

- Integración fluida con Pandas para visualización directa de DataFrames.

4. Scikit-learn: Aprende y Aplica Machine Learning de Forma Sencilla

Cuando decidí probar modelos predictivos para segmentar clientes, me apoyé en Scikit-learn por su versatilidad y facilidad de uso. Cuenta con algoritmos listos para clasificación, regresión y clustering, y herramientas para preparar datos y evaluar resultados.

Características clave:

- Implementa más de 80 algoritmos de aprendizaje supervisado y no supervisado.

- Interfaces coherentes y fáciles de aprender.

- Funciones para preprocesamiento como escalado y selección de características.

5. SciPy: Extiende las Capacidades Matemáticas

Dado que NumPy es el núcleo, SciPy es el anexo especializado para necesidades avanzadas. He usado SciPy en proyectos académicos para optimización de parámetros y análisis estadísticos, casos donde la funcionalidad avanzada es indispensable.

Funcionalidades útiles:

- Optimización y minimización de funciones.

- Estadísticas avanzadas y pruebas.

- Álgebra lineal y transformadas.

6. TensorFlow y PyTorch: Modelos de Deep Learning a tu Alcance

Para mis incursiones en inteligencia artificial, particularmente en análisis de imágenes y texto, recurrí a TensorFlow y PyTorch. Estas bibliotecas ofrecen abstracciones para diseñar, entrenar y desplegar redes neuronales con flexibilidad y eficiencia. Lo que me gusta es que PyTorch facilita la experimentación con una sintaxis más clara y dinámica, ideal para desarrollo de prototipos, mientras TensorFlow es excelente para producción y escalabilidad.

7. Bibliotecas Complementarias para Casos Especiales

No quiero dejar pasar algunas herramientas útiles que quizás no son tan masivas pero sí poderosas en contextos específicos:

- Plotly y Bokeh: para visualizaciones interactivas que superan a Matplotlib cuando se trata de dashboards web.

- Statsmodels: para modelado estadístico riguroso y análisis econométricos.

- Dask: si trabajas con datos demasiado grandes para tu memoria RAM.

Cómo Seleccionar la Biblioteca Adecuada para tu Proyecto

Mi recomendación basada en mi propio recorrido es evaluar primero la naturaleza del dato y el objetivo:

- Limpieza y procesamiento: Pandas + NumPy

- Visualización estática: Matplotlib y Seaborn

- Visualización interactiva: Plotly o Bokeh

- Modelado clásico: Scikit-learn

- Deep learning: TensorFlow o PyTorch

- Estadísticas formales: Statsmodels

- Big data: Dask

Combinar varias es habitual, por ejemplo, yo suelo limpiar con Pandas, visualizar con Seaborn y luego modelar con Scikit-learn.

Reflexión Final

Dominar las bibliotecas de Python para la ciencia de datos me ha permitido no solo agilizar procesos técnicos, sino contar historias claras con los datos, compartir hallazgos contundentes y construir modelos que realmente aportan valor. Si te interesa, te invito a profundizar desde hoy mismo, practicando con datasets reales y proyectos propios. La mejor forma de aprender es haciendo.

Si quieres comenzar tu camino para convertirte en un profesional destacado en ciencia de datos, te recomiendo el Bootcamp de Aprende a Programar desde Cero Full Stack Jr., donde aprenderás todas estas tecnologías desde lo fundamental hasta proyectos aplicados que transformarán tu carrera. Documentación oficial de Pandas. Tutorial completo de Scikit-learn.