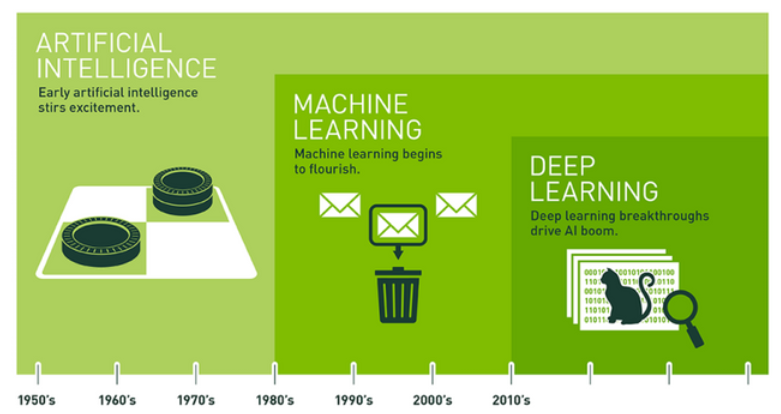

Saber cuál es el contexto histórico del Deep Learning es de suma importancia dentro del manejo de los macrodatos, ya que el aprendizaje profundo o Deep Learning (DL) es un subcampo del Machine Learning, uno de los campos más amplios y fundamentales.

En suma, el Deep Learning soluciona el problema de la elección de características, que también es llamado aprendizaje jerárquico. La magia está en que ya no necesitamos volvernos locos buscando las mejores características o atributos para cada problema, ya que ahora esto lo hace automáticamente nuestro algoritmo.

De manera que el Deep Learning aprende distintas representaciones de los datos que se introducen en un clasificador final. Por esta razón, en este artículo, te exponemos todo el contexto histórico del Deep Learning.

Contexto histórico del Deep Learning

Probablemente muchas personas piensan que el área del Deep Learning y las redes neuronales es una novedad, pero ¡nada más lejos de la realidad! Por ello, es importante conocer el contexto histórico del Deep Learning.

De hecho, la primera red neuronal data de 1958. El problema es que no había potencia de cálculo suficiente para poder progresar hasta hace relativamente poco, con la popularización de las GPUs de altas prestaciones.

Así, para el contexto histórico del Deep Learning, estos son los hechos más importantes que han ocurrido en el campo de la IA (Inteligencia Artificial):

- 1950: Alan Turing crea el Test de Turing.

- 1952: Arthur Samuel crea el primer programa que aprende partida tras partida a jugar a las damas.

- 1956: Martin Minsky acuña el término «Artificial Intelligence» para referirse a este nuevo campo.

- 1958: Frank Rosenblatt diseña el Perceptrón, la primera red neuronal artificial.

Como podéis ver, la Inteligencia Artificial no es ni mucho menos nueva, lleva mucho tiempo entre nosotros, sufriendo altibajos como consecuencia de las altas expectativas depositadas y los «pocos» avances conseguidos.

Desde 1974 hasta nuestros días, ha habido épocas mejores y peores. Para este contexto histórico del Deep Learning, algunos de los hechos más relevantes hasta 2006 son:

- 1967: nace el campo del reconocimiento de patrones con la aparición del algoritmo «Nearest Neighbor».

- 1979: crean el Stanford Cart, un robot capaz de navegar automáticamente por una habitación evitando obstáculos.

- 1981: Gerald Dejong introduce el «Explanation Based Learning», el precursor del Machine Learning. El ordenador analizaba datos de entrenamiento y creaba reglas para descartar los datos menos importantes.

- 1985: Terry Sejnowski inventa NetTalk, un algoritmo capaz de aprender a pronunciar palabras como lo haría un niño.

- 1990: cambia el paradigma del Machine Learning de un enfoque orientado al conocimiento a uno orientado al dato. Empiezan a extraer conclusiones de grandes cantidades de datos.

- 1997: DeepBlue derrota a Kaspárov por primera vez.

Tras esta época de luces y sombras y gracias, entre otras cosas, a la disponibilidad de mucha más potencia de cálculo y de datos, desde 2006 hasta la fecha ha habido una explosión del Machine Learning. El contexto histórico del Deep Learning continúa:

- 2006: aparecen las arquitecturas profundas, acuñadas como Deep Learning por Geoffrey Hinton.

- 2011: Watson IBM vence a sus competidores humanos en el concurso Jeopardy.

- 2012: Geoffrey Hinton gana por goleada el concurso de ImageNet con una red neuronal profunda.

- 2012: en Google X crean GoogleBrain, capaz de detectar gatos en vídeos.

- 2014: Facebook desarrolla DeepFace, capaz de reconocer caras de humanos con una precisión de 97.25%, solo un 0.28% por debajo de un ser humano.

- 2014: Google compra DeepMind, una startup inglesa que había creado un algoritmo capaz de aprender a jugar con juegos Atari simplemente viendo el vídeo.

- 2014: aparecen las GANs (Generative Adversarial Networks), capaces de generar contenido falso que no lo parece, cambiando para siempre la percepción de «real» (deep fakes).

- 2015: Elon Musk y Sam Altman crean OpenAI para promover el bueno uso de la IA.

- 2016: Google DeepMind vence por primera vez en el juego Go, consiguiendo movimientos creativos.

Por medio de este post, te has podido acercar a cuál es el contexto histórico del Deep Learning, sin embargo, este es un campo sumamente amplio. Por este motivo, desde KeepCodging te presentamos el Big Data, Inteligencia Artificial & Machine Learning Full Stack Bootcamp, por medio del que podrás aprender mucho más sobre este servicio y, en general, sobre los sistemas y herramientas más importantes en el mundo del Big Data. De esta forma, de la mano de profesionales y en menos de nueve meses, te convertirás en todo un experto y podrás conocer e identificar las alternativas de gestión de datos más apropiadas para los estudios de los macrodatos. ¡No esperes más para empezar e inscríbete ahora!