Data Quality es una herramienta sumamente importante dentro del universo Big Data, puesto que, gracias a ella, se consigue la confiabilidad de los datos y, por tanto, la funcionalidad de los resultados y sus correspondientes rutas de acción. Por ello, si lo que buscas es ser todo un experto en el manejo de los macrodatos, has de considerar cómo implementar Data Quality en tus estudios de la información.

Por este motivo, desde KeepCoding te familiarizamos con qué es y cómo funciona Data Quality dentro del mundo Big Data.

¿Qué es Data Quality?

En la carga de un sistema de información, lo más común es que tengas siempre unos requisitos para llevar a cabo el proceso de carga de los datos. Por tanto, se especifican una serie de reglas para que lleves el procesamiento de cierta forma. Esto hace referencia al proceso de Data Quality.ç

De esta forma, implementar Data Quality en un procesamiento de datos consiste en hacer una normalización de datos antes de llevar a cabo la ingesta de estos en el sistema destino. En efecto, las ETL (extract, transform, load) están muy ligadas a las herramientas de calidad y las herramientas de gobierno.

Para ello, Data Quality permite hacer transformaciones para convertir el dato a los requisitos establecidos, ya sean técnicos o de negocio, de forma que sea efectiva y confiable la ingesta de datos de tu sistema al sistema destino.

Por otra parte, Data Quality consiste en eliminar inconsistencias y duplicados, limpiar y clasificar, etc. Por ello, las transformaciones de los datos te van a facilitar todo ese trabajo.

¿Cómo funciona Data Quality?

Como ya se ha mencionado, Data Quality funciona por medio de unas transformaciones en los datos que se implementan con el fin de mantener o mejorar la calidad de los datos que serán procesados. Para ello, te expondremos los dos principales comandos que se utilizan para hacer la limpieza de los datos:

- tReplace: este comando te permite buscar una cadena de texto y sustituirla por otra.

- tConvertType: este te permite establecer un esquema y, por medio de la opción Autocast, convertir los tipos de origen al datatype establecido en el esquema.

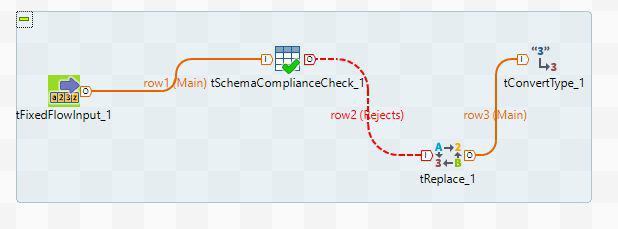

A continuación, te compartimos un breve ejemplo de cómo funciona Data Quality en el flujo de datos desde un sistema destinario a un sistema destino:

En el ejemplo se muestra cómo el componente de tSchemaComplianceCheck rechaza los registros que no cumplen con los requisitos establecidos. Por otra parte, el componente tReplace sustituye los valores para que cumpla («dos» por «2»). Por último, el componente tConvertType cambia el datatype (en el ejemplo, de «string» a «integer»).

Ahora que sabes qué es Data Quality, te aconsejamos llevar este conocimiento a la práctica para que aprendas a implementar estos comandos de manera natural para tus estudios de datos.

En el transcurso de este post, te has familiarizado con queé es y cómo funciona Data Quality dentro del Big Data. Sin embargo, este factor dentro del mundo Big Data posee varias opciones de desarrollo según el programa o plataforma que busques implementar en el estudio de los macrodatos. Por este motivo, te aconsejamos continuar aprendiendo sobre el Big Data.

Para ello, nuestro Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Learning es ideal para ti, ya que te permitirá consolidar tus conocimientos y poner a prueba tus destrezas en el desarrollo de un procesamiento de datos efectivo. Por medio de este bootcamp, aprenderás cómo el Data Mining es la técnica por excelencia para extraer el conocimiento a través de grandes volúmenes de datos.

Además, sabrás utilizar sus métodos de inteligencia artificial, aprendizaje automático, estadística y sistemas de bases de datos. Todo ello te ayudará a convertirte en un experto del sector IT. No lo dudes más, ¡inscríbete y empieza ahora para continuar aprendiendo!