El proceso de hacer queries en DataProc con GCloud, Python y Hive requiere de una serie de conocimientos base que ayuden a llevarlas a cabo de manera ágil y precisa. Como sabrás, en general, las queries para la gestión de los macrodatos supone uno de los factores más importantes a la hora comprobar la clasificación de la información y su eficacia al responder a las peticiones.

De manera que considerar el desarrollo de las queries como uno de los pilares de DataProc con GCloud, Python y Hive resulta imprescindible, sin embargo, lo interesante es cómo se complementan estas. Por ello, en este post te explicamos cómo hacer queries en DataProc con GCloud, Python y Hive.

¿Cómo hacer queries en DataProc con GCloud, Python y Hive?

Para hacer queries en DataProc con GCloud, Python y Hive debes partir desde el notebook con el server de Hive. Para esto, necesitarás añadir una regla de fuego para abrir el puerto 0.0.0.0/0 a todo internet. De esta manera, podrás ahorrarte tiempo en investigar la IP actual de la instancia desde la que estés ejecutando el ejemplo.

Ten en cuenta que el siguiente ejemplo no es más que una simple práctica de un primer acercamiento, puesto que hay mecanismos para ir más seguros. Sin embargo, en este post pretendemos que lo aprendas en profundidad y puedas abrir más caminos para comunicar con el clúster y flexibilizar la arquitectura que estás implementando.

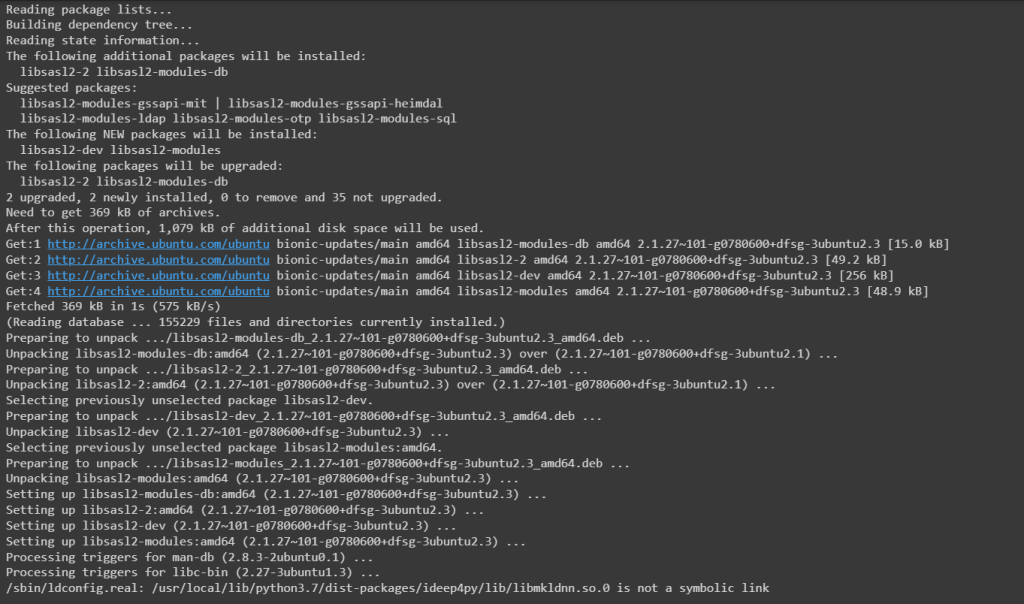

En primer lugar, tendrás que instalar las librerías necesarias para usar PyHIVE; para ello, deberás usar los siguientes comandos:

- %%bash

apt-get install libsasl2-dev libsasl2-modules - apt-cache search libsasl2-modules

A partir de allí, podrás ver en la consola algo como:

- !curl ipecho.net/plain

- 34.86.88.185

Instalar librerías de Python para interactuar con Hive

A continuación, tendrás que instalar las librerías de Python para interactuar con HIVE de la siguiente forma:

- !pip install pyhs2 pyhive[hive]

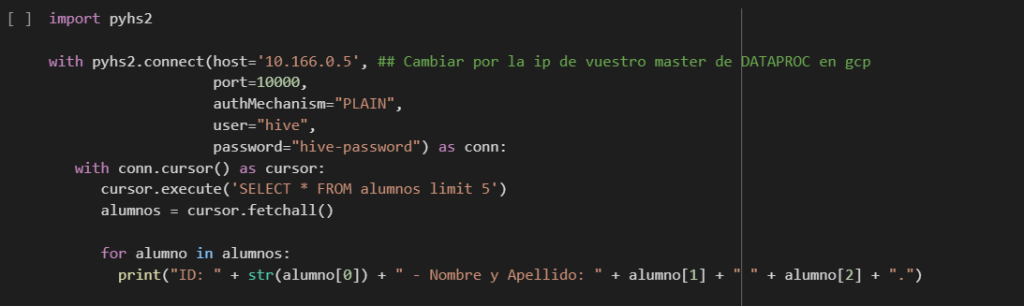

Acceder a la base de datos de Hive

Finalmente, para acceder a la base de datos de HIVE, tendrás que hacer una query. Ten cuidado con la autenticación, puesto que esta, por defecto, viene definida en GCP (Google Cloud Plataform) Dataproc dentro de /usr/lib/hive/conf/hive-site.xml.

Por último, deberás realizar el siguiente procedimiento en la consola:

En este post, te has encontrado con cómo hacer queries en DataProc con GCloud, Python y Hive y, en definitiva, todo lo relacionado con su desarrollo en la consola de DataProc y para qué sirven en el mundo Big Data. A pesar de ello, las queries y sus tipos se diversifican y se hacen más complejas, por lo que su estudio exige mucho más conocimiento y práctica para llevarlas a cabo de manera efectiva.

Por este motivo, en KeepCoding contamos con el Bootcamp Full Stack Big Data, Inteligencia Artificial & Machine Leraning. Gracias a este bootcamp, podrás instruirte en profundidad por medio de once módulos que verás en remoto sobre los principales sistemas, lenguajes y herramientas que trabajan con el procesamiento de los macrodatos. En menos de nueve meses podrás considerarte todo un experto. ¡No dudes en consultar nuestro temario y apúntate ahora!